«`html

Освоение новых возможностей с помощью xLSTM: расширение возможностей Long Short-Term Memory LSTM для продвинутого языкового моделирования и не только

Вопреки своему значительному вкладу в глубокое обучение, у долгих краткосрочных памяти (LSTM) есть ограничения, особенно в пересмотре сохраненной информации. Например, когда сталкиваются с проблемой поиска ближайшего соседа, где последовательность должна найти наиболее похожий вектор, у LSTM возникают трудности с обновлением сохраненных значений при обнаружении более близкого совпадения позже в последовательности. Эта неспособность пересматривать решения по хранению затрудняет их производительность в задачах, требующих динамических настроек сохраненной информации. Эти вызовы требуют постоянного совершенствования архитектур нейронных сетей для решения ограничений и улучшения возможностей модели.

Решения для развития xLSTM

Исследователи из ELLIS Unit, LIT AI Lab, Institute for Machine Learning, JKU Linz, Austria NXAI Lab, Linz, Austria и NXAI GmbH, Linz, Austria, нацелены на улучшение языкового моделирования LSTM за счет устранения его ограничений. Они представляют экспоненциальные вентили и модифицируют структуры памяти, чтобы создать xLSTM, который может эффективно пересматривать сохраненные значения, вмещать больше информации и обеспечивать параллельную обработку. Интеграция этих усовершенствований в архитектуры остаточных блоков достигает конкурентоспособной производительности, сравнимой с передовыми трансформерами и моделями пространства состояний. Преодоление ограничений LSTM открывает пути для масштабирования языковых моделей до масштаба текущих крупных языковых моделей, потенциально революционизируя понимание и генерацию языка.

Практические применения xLSTM

Различные подходы появились для решения квадратичной сложности механизмов внимания в трансформерах, включая линейные техники внимания, такие как Synthesizer, Linformer, Linear Transformer и Performer. Модели пространства состояний (SSM) приобрели популярность благодаря их линейности в длине контекста, причем модели, такие как S4, DSS и BiGS, показывают многообещающие результаты. Рекуррентные нейронные сети (RNN) с линейными блоками и механизмами вентилирования также привлекли внимание, как это видно в моделях, таких как HGRN и RWKV. Правила обновления ковариации, смешивание памяти и архитектуры остаточного стекирования играют ключевую роль в улучшении возможностей модели, причем архитектуры xLSTM стоят наравне с трансформерами в задачах большого языкового моделирования.

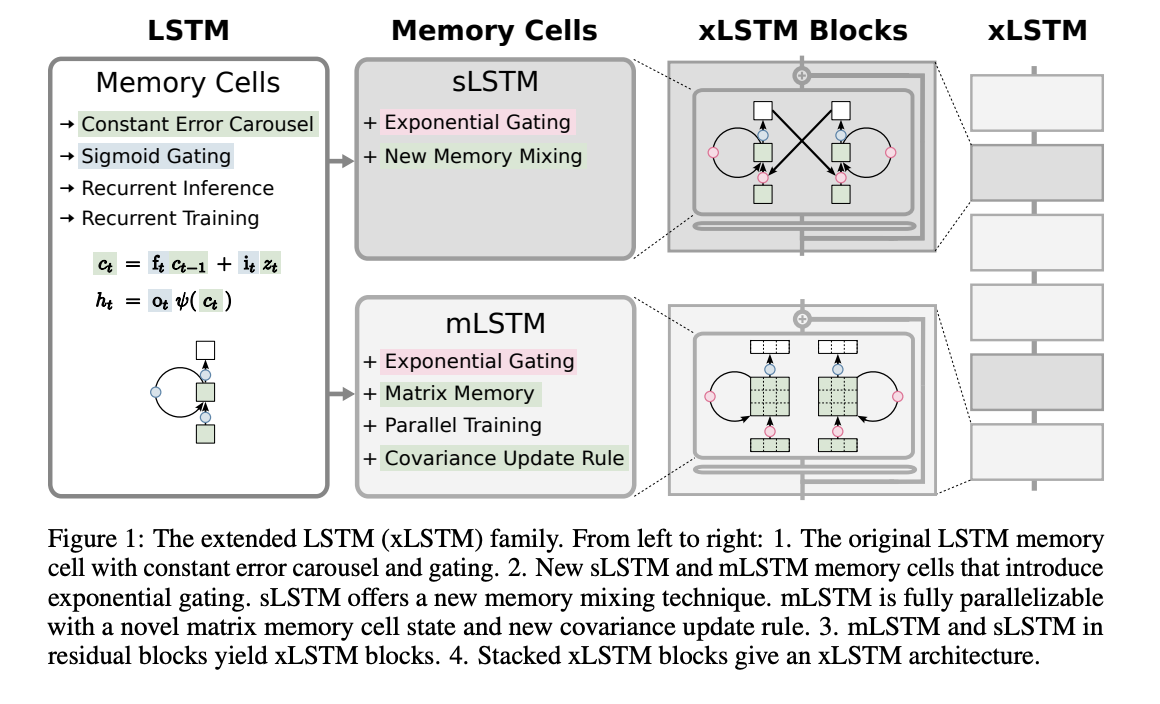

Расширенная долгая краткосрочная память (xLSTM) вводит экспоненциальные вентили и структуры памяти для улучшения моделей LSTM. Она представляет два варианта: sLSTM с скалярной памятью и обновлением, представляющий смешивание памяти, и mLSTM с матричной памятью и правилом обновления ковариации, который полностью параллелизуем. Интеграция в архитектуры остаточных блоков приводит к блокам xLSTM, которые могут резюмировать прошлые контексты нелинейно в высокомерном пространстве. Архитектуры xLSTM формируются путем стекирования этих блоков остаточно, предлагая линейные вычисления и постоянную сложность памяти относительно длины последовательности. В то время как mLSTM вычислительно затратна из-за своей матричной памяти, оптимизации позволяют эффективную параллельную обработку на графических процессорах.

В экспериментальной оценке xLSTM для языкового моделирования исследуются синтетические задачи и производительность на наборах данных SlimPajama. Возможности xLSTM тестируются на формальных языках, задачах ассоциативного воспоминания и сценариях с дальним диапазоном. Сравнения с существующими методами показывают превосходство xLSTM в валидационной непонятности. Исследования абляции подчеркивают важность экспоненциальных вентилей и матричной памяти в производительности xLSTM. Эксперименты по масштабированию языкового моделирования на 300 млрд токенов дополнительно подтверждают эффективность xLSTM, показывая ее устойчивость в обработке длинных контекстов, задач вторичной обработки и различных текстовых областей. Анализ поведения масштабирования предполагает благоприятную производительность xLSTM по сравнению с другими моделями при увеличении размера.

В заключение, у xLSTM есть ограничения, включая более медленную параллелизацию по сравнению с mLSTM, более медленные ядра CUDA и вычислительную сложность матричной памяти. Важна тщательная инициализация вентиля забывания, и более длинные контексты могут нагружать память. Несмотря на это, xLSTM обещает в языковом моделировании, конкурируя с трансформерами и моделями пространства состояний. Законы масштабирования подтверждают его потенциальную конкурентоспособность с крупными языковыми моделями. Для более крупных архитектур xLSTM требуется дальнейшая оптимизация. В целом, инновации xLSTM в вентиляции и структурах памяти позиционируют его как значительного участника в языковом моделировании и, возможно, в других областях глубокого обучения, таких как обучение с подкреплением и прогнозирование временных рядов.

Ссылки и контакты

Подробнее ознакомьтесь с результатами исследования. Вся заслуга за это исследование принадлежит его ученым. Также не забудьте подписаться на нас в Twitter. Присоединяйтесь к нашему каналу в Telegram, Discord и группе в LinkedIn.

Если вам нравится наша работа, вам понравится наш информационный бюллетень.

Не забудьте присоединиться к нашему SubReddit с более чем 42 тыс. подписчиков.

Развитие вашей компании с использованием искусственного интеллекта

Если вы хотите, чтобы ваша компания развивалась с помощью искусственного интеллекта (ИИ) и оставалась в числе лидеров, грамотно используйте xLSTM: расширение возможностей Long Short-Term Memory LSTM для продвинутого языкового моделирования и не только.

Проанализируйте, как ИИ может изменить вашу работу. Определите, где возможно применение автоматизации: найдите моменты, когда ваши клиенты могут извлечь выгоду из AI. Определитесь какие ключевые показатели эффективности (KPI): вы хотите улучшить с помощью ИИ.

Подберите подходящее решение, сейчас очень много вариантов ИИ. Внедряйте ИИ решения постепенно: начните с малого проекта, анализируйте результаты и KPI.

На полученных данных и опыте расширяйте автоматизацию.

Если вам нужны советы по внедрению ИИ, пишите нам на https://t.me/itinai. Следите за новостями о ИИ в нашем Телеграм-канале t.me/itinainews или в Twitter @itinairu45358.

Попробуйте AI Sales Bot https://itinai.ru/aisales. Этот AI ассистент в продажах помогает отвечать на вопросы клиентов, генерировать контент для отдела продаж и снижать нагрузку на первую линию.

Узнайте, как ИИ может изменить ваши процессы с решениями от AI Lab itinai.ru. Будущее уже здесь!

«`