«`html

Улучшение моделей трансформера с помощью встраивания абака для превосходной арифметической и алгоритмической рассуждательной производительности

Трансформаторные модели значительно продвинули машинное обучение, особенно в обработке сложных задач, таких как обработка естественного языка и арифметические операции, такие как сложение и умножение. Эти задачи требуют от моделей решать проблемы с высокой эффективностью и точностью. Исследователи стремятся улучшить способности этих моделей выполнять сложные многошаговые рассуждения, особенно в арифметике, где отслеживание позиций цифр в длинных последовательностях имеет ключевое значение.

Проблема трансформаторных моделей

Основной вызов трансформаторных моделей — выполнение многошаговых рассуждений, таких как сложение и умножение больших чисел. Эта проблема в основном связана с трудностями в точном отслеживании позиций цифр в длинных последовательностях, что необходимо для правильного выполнения арифметических операций. Традиционные модели часто не удерживают эту позиционную информацию, что приводит к ошибкам в вычислениях с большими числами.

Решение с использованием встраивания позиций

Существующие методы включают в себя встраивания позиций, которые помогают трансформаторам понимать позиции цифр в последовательностях. Эти встраивания улучшили производительность модели, но по-прежнему оказываются недостаточными при работе с длинными последовательностями. Разработаны продвинутые методики, такие как функциональная интерполяция для встраивания относительной позиции (FIRE), чтобы расширить возможности этих моделей, но они также сталкиваются с ограничениями в обобщении к невидимым длинам и задачам.

Новый метод Abacus Embeddings

В недавнем исследовании ученые из Университета Мэриленда, Национальной лаборатории Ливермор, Центра искусственного интеллекта в Тюбингене и Карнеги-Меллонского университета представили новый метод под названием Abacus Embeddings. Этот подход значительно улучшает способность трансформаторной модели отслеживать позицию каждой цифры в числе. Abacus Embeddings присваивают одно и то же встраивание позиции всем цифрам одинаковой значимости, что позволяет модели правильно выравнивать цифры.

Практические применения и результаты

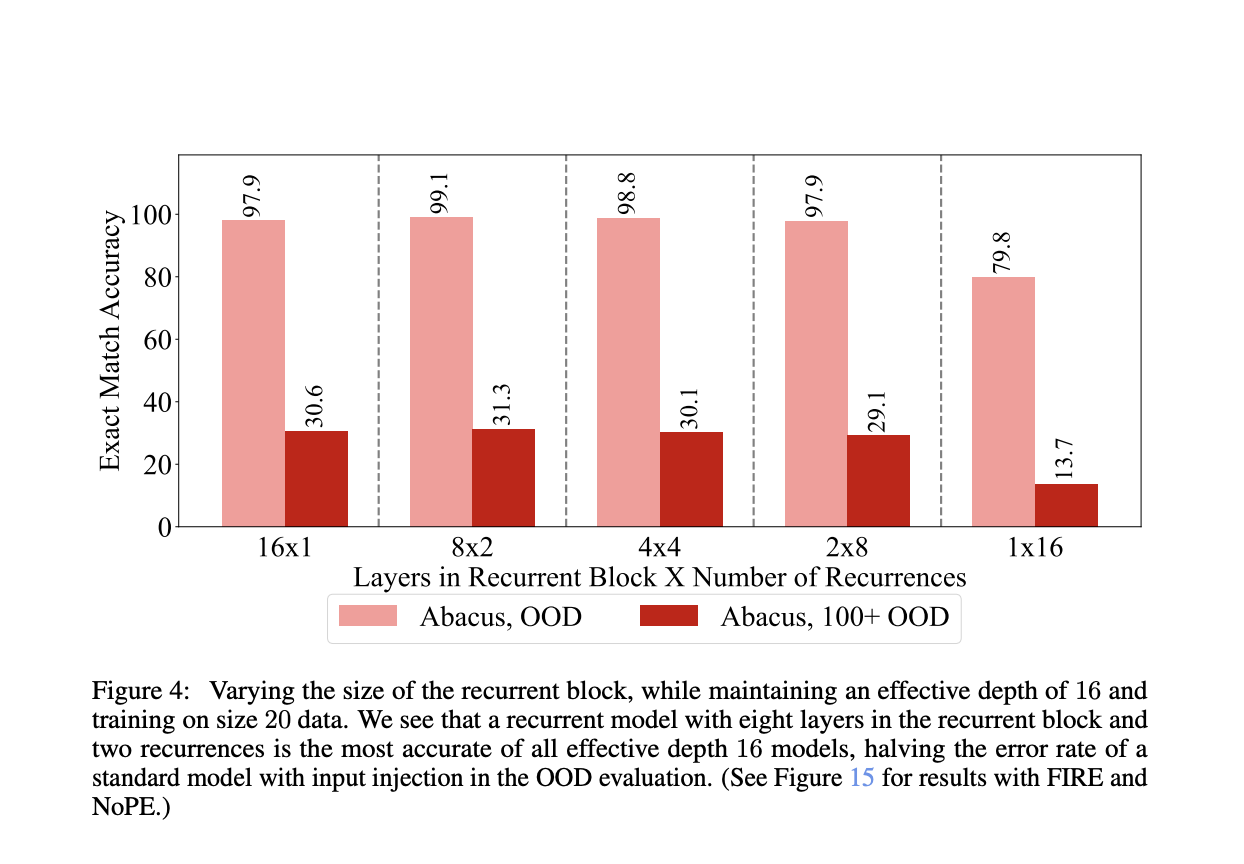

Техника Abacus Embeddings комбинирует встраивания позиций с инъекцией ввода и циклическими архитектурами трансформера. Кодируя относительную позицию каждой цифры в числе, модель может более точно выполнять арифметические операции. Например, исследователи обучали трансформаторные модели на задачах сложения с числами до 20 цифр и достигли до 99% точности на задачах сложения с числами до 100 цифр. Это представляет собой передовую производительность, значительно превосходящую предыдущие методы.

Улучшения производительности с использованием Abacus Embeddings не ограничиваются только сложением. Метод также показал заметные улучшения в других алгоритмических задачах, таких как умножение и сортировка. Исследование показало, что модели, обученные с использованием Abacus Embeddings, могут обобщаться к задачам умножения с числами до 15 цифр и задачам сортировки с массивами до 30 чисел, каждое из которых имеет до 30 цифр. Это демонстрирует универсальность и эффективность подхода Abacus Embeddings в решении различных сложных задач.

Результаты исследования были впечатляющими, достигнув почти идеальной точности во многих случаях. Например, модели, использующие Abacus Embeddings в сочетании с инъекцией ввода, достигли точности 99,1% на задачах вне распределения, сократив ошибки на 87% по сравнению со стандартными архитектурами. Этот уровень производительности подчеркивает потенциал Abacus Embeddings трансформировать способность трансформаторных моделей обрабатывать арифметику и другие алгоритмические задачи.

Заключение

Исследование подчеркивает преимущества, сделанные возможными благодаря Abacus Embeddings, в улучшении способностей моделей трансформера. Метод решает критические проблемы выполнения многошаговых рассуждений, таких как отслеживание позиционной информации цифр в длинных последовательностях, приводя к существенным улучшениям в точности и обобщении. Этот инновационный подход прокладывает путь для дальнейших прорывов в области, потенциально расширяясь на еще более сложные и разнообразные задачи за пределами базовой арифметики. Исследователям рекомендуется дальше изучать эти результаты, используя надежные решения, предлагаемые Abacus Embeddings, для улучшения производительности и применимости моделей трансформера в широком спектре вычислительных задач.

Проверьте статью и GitHub. Вся заслуга за это исследование принадлежит ученым этого проекта. Также не забудьте подписаться на нас в Twitter. Присоединяйтесь к нашему каналу в Telegram, каналу в Discord и группе в LinkedIn.

Если вам понравилась наша работа, вам понравится наш новостной бюллетень.

Не забудьте присоединиться к нашему SubReddit с 43 тыс. подписчиков. Также ознакомьтесь с нашей платформой AI Events Platform.

Представляем

— Sean Mcleish (@SeanMcleish) May 28, 2024

Если вы хотите, чтобы ваша компания развивалась с помощью искусственного интеллекта (ИИ) и оставалась в числе лидеров, грамотно используйте Enhancing Transformer Models with Abacus Embeddings for Superior Arithmetic and Algorithmic Reasoning Performance.

Проанализируйте, как ИИ может изменить вашу работу. Определите, где возможно применение автоматизации: найдите моменты, когда ваши клиенты могут извлечь выгоду из AI.

Определитесь какие ключевые показатели эффективности (KPI): вы хотите улучшить с помощью ИИ.

Подберите подходящее решение, сейчас очень много вариантов ИИ. Внедряйте ИИ решения постепенно: начните с малого проекта, анализируйте результаты и KPI.

На полученных данных и опыте расширяйте автоматизацию.

Если вам нужны советы по внедрению ИИ, пишите нам на https://t.me/itinai. Следите за новостями о ИИ в нашем Телеграм-канале t.me/itinainews или в Twitter @itinairu45358

Попробуйте AI Sales Bot https://itinai.ru/aisales. Этот AI ассистент в продажах, помогает отвечать на вопросы клиентов, генерировать контент для отдела продаж, снижать нагрузку на первую линию.

Узнайте, как ИИ может изменить ваши процессы с решениями от AI Lab itinai.ru будущее уже здесь!

«`