Оптимизация обработки длинного контекста с помощью Role-RL: каркас обучения с подкреплением для эффективного развертывания больших языковых моделей

Проблемы в обучении крупных языковых моделей

Обучение крупных языковых моделей, способных обрабатывать длинные контексты, остается сложной задачей из-за ограничений на разреженность данных, сложности реализации и эффективности обучения. Работа с документами бесконечной длительности, характерными для современных медиаформатов, таких как автоматизированные новостные обновления, платформы электронной коммерции с прямой трансляцией и вирусные короткометражные фильмы, подчеркивает эти проблемы очевидным образом.

Online Long-context Processing (OLP)

OLP — это новая парадигма, предназначенная для преодоления этих препятствий. Она специально создана для обработки массивных объемов данных в реальном времени, организуя и оценивая различные потоки медиаконтента по мере их поступления. OLP помогает разделять и классифицировать потоки текстов в соответствующие области, такие как описания продуктов, обсуждения цен или взаимодействия с клиентами на платформах электронной коммерции с прямой трансляцией. Также он помогает организовывать постоянный поток новостных данных на факты, мнения и прогнозы в автоматизированной новостной отчетности, что улучшает точность информации и удобство для пользователей.

Решение с использованием Role Reinforcement Learning (Role-RL)

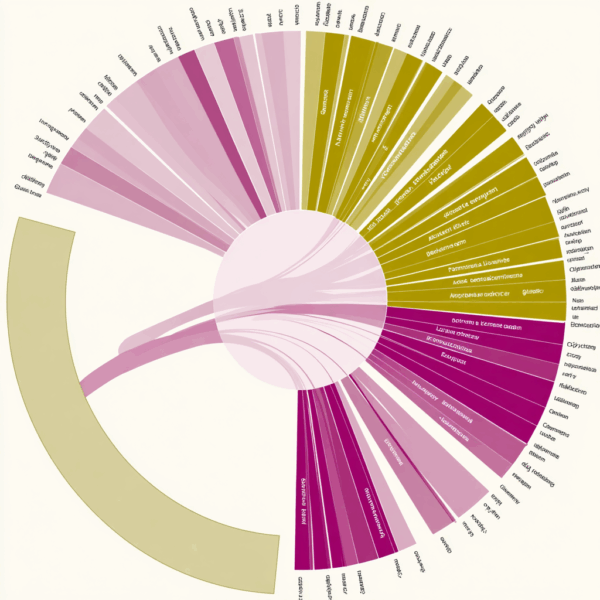

Для выбора оптимальной языковой модели из постоянно растущего множества моделей была предложена система под названием Role Reinforcement Learning (Role-RL). Эта система использует данные о производительности в реальном времени для автоматизации развертывания различных языковых моделей в парадигме OLP в соответствии с их оптимальными ролями.

Каждая языковая модель оценивается Role-RL на основе важных метрик производительности, таких как скорость, точность и эффективность стоимости. Role-RL максимизирует общую эффективность системы, динамически назначая каждую модель на задачи, для которых она наиболее подходит, на основе этих оценок. Таким образом, ресурсы могут использоваться более стратегически, гарантируя, что высокопроизводительные модели берут на себя наиболее важные задачи, а более экономичные модели используются для более простых процедур.

Оценка пользы и выводы

Исследования на датасете OLP-MINI показали значительные преимущества комбинированного фреймворка OLP и Role-RL. Средний уровень полноты составил 93,2%, что является показателем стабильной и частой выдачи соответствующей информации. Этот фреймворк также позволил сократить расходы на развертывание LLM на 79,4%, продемонстрировав свою экономическую целесообразность в дополнение к эффективности.