«`html

Повышение понимания документов с помощью DocOwl2: новая архитектура сжатия высокого разрешения

Понимание многостраничных документов и новостных видеороликов — обычная задача в повседневной жизни человека. Для решения таких сценариев мультимодальные модели большого языка (MLLMs) должны быть оснащены способностью понимать несколько изображений с богатой визуально-ориентированной текстовой информацией. Однако понимание изображений документов более сложно, чем естественных изображений, поскольку требуется более тонкое восприятие для распознавания всего текста. Существующие подходы либо добавляют высокоразрешающий кодировщик, либо обрезают высокоразрешающие изображения на низкоразрешающие подизображения, оба из которых имеют ограничения.

Практические решения и ценность

Исследователи из Alibaba Group и Renmin University of China предложили надежную архитектуру сжатия под названием High-resolution DocCompressor. Этот метод использует визуальные особенности глобального низкоразрешающего изображения в качестве руководства для сжатия, поскольку глобальная карта особенностей может эффективно захватывать общую информацию о макете документа. Вместо того чтобы обращаться ко всем высокоразрешающим особенностям, High-resolution DocCompressor собирает группу высокоразрешающих особенностей с идентичными относительными положениями в исходном изображении в качестве объектов сжатия для каждого запроса с глобальной карты особенностей. Этот метод, ориентированный на макет, помогает лучше суммировать текстовую информацию в определенной области макета.

Кроме того, исследователи утверждают, что сжатие визуальных особенностей после модуля отображения в текст мультимодальной большой языковой модели может лучше сохранять текстовую семантику на изображениях документов, поскольку это аналогично суммированию текстов в обработке естественного языка.

Модель DocOwl2 использует модуль адаптивного обрезания формы и низкоразрешающий визионный кодировщик для кодирования высокоразрешающих изображений документов. Модуль адаптивного обрезания формы разбивает исходное изображение на несколько низкоразрешающих подизображений, а низкоразрешающий визионный кодировщик используется для кодирования как подизображений, так и глобального изображения. Модель затем использует модуль отображения в текст под названием H-Reducer для ансамблирования горизонтальных визуальных особенностей и выравнивания размерности визионных особенностей с большой языковой моделью. Кроме того, DocOwl2 включает высокоразрешающий сжиматель, который является ключевым компонентом High-resolution DocCompressor. Этот сжиматель использует визуальные особенности глобального низкоразрешающего изображения в качестве запроса и собирает группу высокоразрешающих особенностей с идентичными относительными положениями в исходном изображении в качестве объектов сжатия для каждого запроса. Этот метод, ориентированный на макет, помогает лучше суммировать текстовую информацию в определенной области макета. Наконец, сжатые визуальные токены нескольких изображений или страниц конкатенируются с текстовыми инструкциями и подаются на вход большой языковой модели для мультимодального понимания.

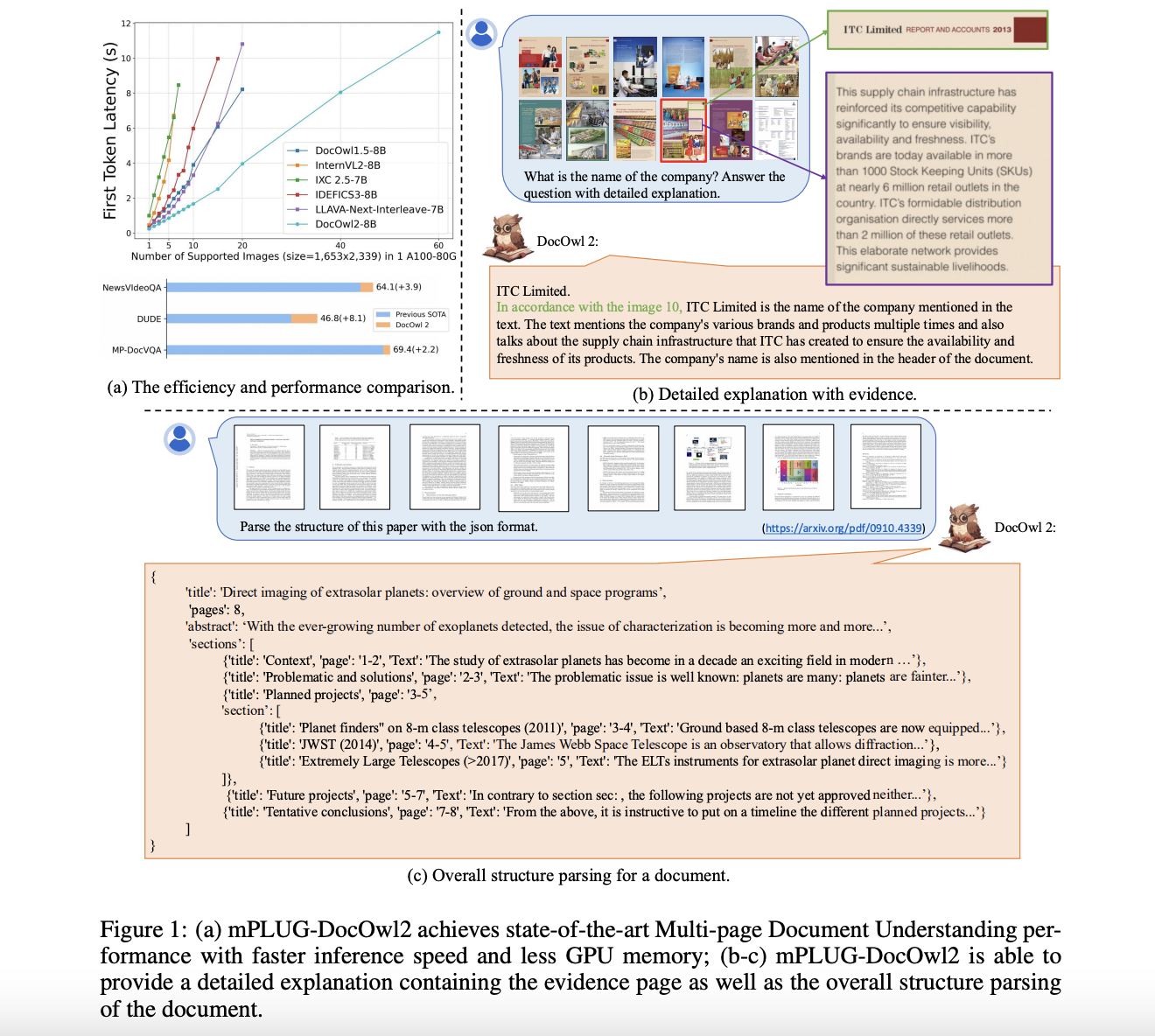

Исследователи сравнили модель DocOwl2 с передовыми мультимодальными большими языковыми моделями на 10 бенчмарках понимания одиночных изображений документов, 2 бенчмарках понимания многостраничных документов и 1 бенчмарке понимания видео с богатым текстом. Они рассматривали как производительность в вопросно-ответной системе (измеряемая по ANLS), так и первую задержку токена (в секундах), чтобы оценить эффективность своей модели.

Результаты показывают, что, хотя модели, специально донастроенные на каждом конечном наборе данных, показали себя хорошо, мультимодальные LLMs продемонстрировали потенциал для обобщенного понимания документов без OCR. По сравнению с другими мультимодальными LLMs с менее чем 1 000 визуальными токенами, модель DocOwl2 показала лучшие или сопоставимые результаты на 10 бенчмарках. Особенно с меньшим количеством визуальных токенов DocOwl2 превзошла модели, такие как TextMonkey и TokenPacker, которые также стремились сжимать визуальные токены, демонстрируя эффективность High-resolution DocCompressor.

Также по сравнению с передовыми мультимодальными LLMs с более чем 1 000 визуальными токенами модель DocOwl2 достигла более 80% их производительности, используя менее 20% визуальных токенов. Для задач понимания многостраничных документов и понимания видео с богатым текстом модель DocOwl2 также продемонстрировала превосходную производительность и значительно меньшую первую задержку токена по сравнению с другими мультимодальными LLMs, которым можно подавать более 10 изображений на одной GPU A100-80G.

Это исследование представляет mPLUG-DocOwl2, мультимодальную большую языковую модель, способную к эффективному OCR-бесплатному пониманию многостраничных документов. Надежная архитектура High-resolution DocCompressor сжимает каждое высокоразрешающее изображение документа всего лишь в 324 токена с использованием кросс-внимания с глобальными визуальными особенностями в качестве руководства. На бенчмарках одиночных изображений DocOwl2 превосходит существующие методы сжатия и соответствует передовым MLLM, используя меньше визуальных токенов. Он также достигает передовой производительности без OCR в задачах понимания многостраничных документов и видео с богатым текстом с гораздо меньшей задержкой. Исследователи подчеркивают, что использование тысяч визуальных токенов на страницу документа часто излишне и является потерей вычислительных ресурсов. Они надеются, что DocOwl2 привлечет внимание к балансировке эффективного представления изображений и высокопроизводительного понимания документов.

Проверьте статью и GitHub. Вся заслуга за это исследование принадлежит исследователям этого проекта. Также не забудьте подписаться на нас в Twitter и LinkedIn. Присоединяйтесь к нашему Telegram-каналу.

Если вам нравится наша работа, вам понравится наша рассылка.

Не забудьте присоединиться к нашему 50k+ ML SubReddit

Пост опубликован на MarkTechPost.

«`