«`html

Многофункциональные большие языковые модели (MLLMs)

Многофункциональные большие языковые модели (MLLMs) привлекают внимание благодаря своей способности выполнять сложные задачи, связанные с интеграцией визуальных, языковых и аудио данных. Однако они не обеспечивают полноценное выравнивание, выходящее за рамки базового обучения с учителем.

Проблемы и решения

Современные модели часто обходят строгие этапы выравнивания, что приводит к недостаточному учету таких важных аспектов, как правдивость, безопасность и предпочтения человека. Существующие подходы фокусируются только на отдельных областях, таких как снижение галлюцинаций или улучшение разговорных навыков, что не позволяет повысить общую надежность моделей.

Недавние достижения

В последние годы достигнут значительный прогресс в MLLMs, основанных на современных архитектурах, таких как GPT, LLaMA и другие. Появились несколько открытых MLLMs, таких как Otter и LLaVA, которые решают основные многомодальные задачи. Однако усилия по выравниванию остаются ограниченными.

Новый подход MM-RLHF

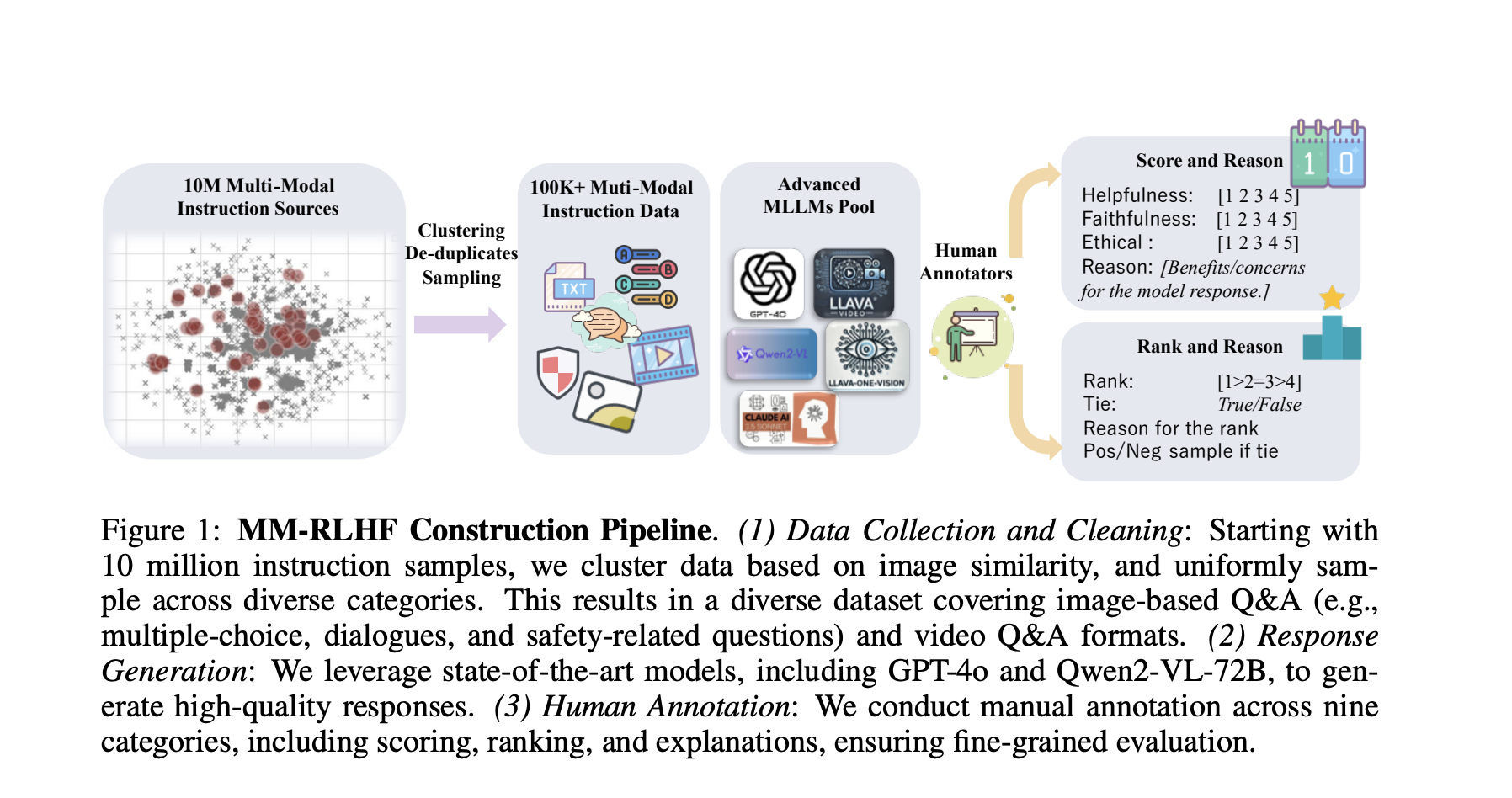

Исследователи предложили новый подход MM-RLHF, который включает обширный набор данных из 120 тысяч пар сравнений предпочтений, аннотированных людьми. Этот набор данных значительно превосходит существующие ресурсы по размеру и качеству аннотаций.

Ключевые инновации

Метод включает две ключевые инновации: модель вознаграждения на основе критики и динамическое масштабирование вознаграждений. Это улучшает интерпретируемость решений модели и эффективность процесса выравнивания.

Процесс реализации

Реализация MM-RLHF включает сложный процесс подготовки и фильтрации данных в трех основных областях: понимание изображений, понимание видео и многомодальная безопасность. Это приводит к созданию более 10 миллионов образцов диалогов, охватывающих разнообразные задачи.

Результаты и улучшения

Оценка MM-RLHF показывает значительные улучшения в различных аспектах, таких как разговорные способности и снижение небезопасного поведения. Модели, прошедшие выравнивание, показывают лучшие результаты в снижении галлюцинаций и математическом рассуждении.

Будущее исследований

Будущие исследования будут сосредоточены на использовании богатой аннотации для оптимизации, решении ограничений данных и расширении набора данных с помощью полуавтоматизированных методов.

Как использовать ИИ для вашего бизнеса

Если вы хотите, чтобы ваша компания развивалась с помощью ИИ, следуйте этим шагам:

- Анализируйте, как ИИ может изменить вашу работу. Определите области, где возможно применение автоматизации.

- Определите ключевые показатели эффективности (KPI). Выберите, что хотите улучшить с помощью ИИ.

- Подберите подходящее решение. Внедряйте ИИ постепенно, начиная с небольших проектов.

- Расширяйте автоматизацию. На основе полученных данных и опыта.

Если вам нужны советы по внедрению ИИ, пишите нам. Следите за новостями о ИИ в нашем Телеграм-канале или в Twitter.

Попробуйте AI Sales Bot — этот ИИ ассистент в продажах помогает отвечать на вопросы клиентов и генерировать контент для отдела продаж.

Узнайте, как ИИ может изменить ваши процессы с решениями от AI Lab. Будущее уже здесь!

«`