«`html

Улучшение проактивных возможностей разговора больших моделей видео-языка (LVLMs) с помощью MACAROON

Большие модели видео-языка (LVLMs) отлично справляются с задачами, требующими понимания визуальной информации и обработки языка. Однако они часто предоставляют ответы пассивно, даже когда вопрос не ясен или невозможен. Это приводит к предвзятым и неправильным ответам. Для решения этой проблемы был разработан MACAROON, который позволяет LVLMs взаимодействовать более динамично и проактивно.

Практические решения и ценность

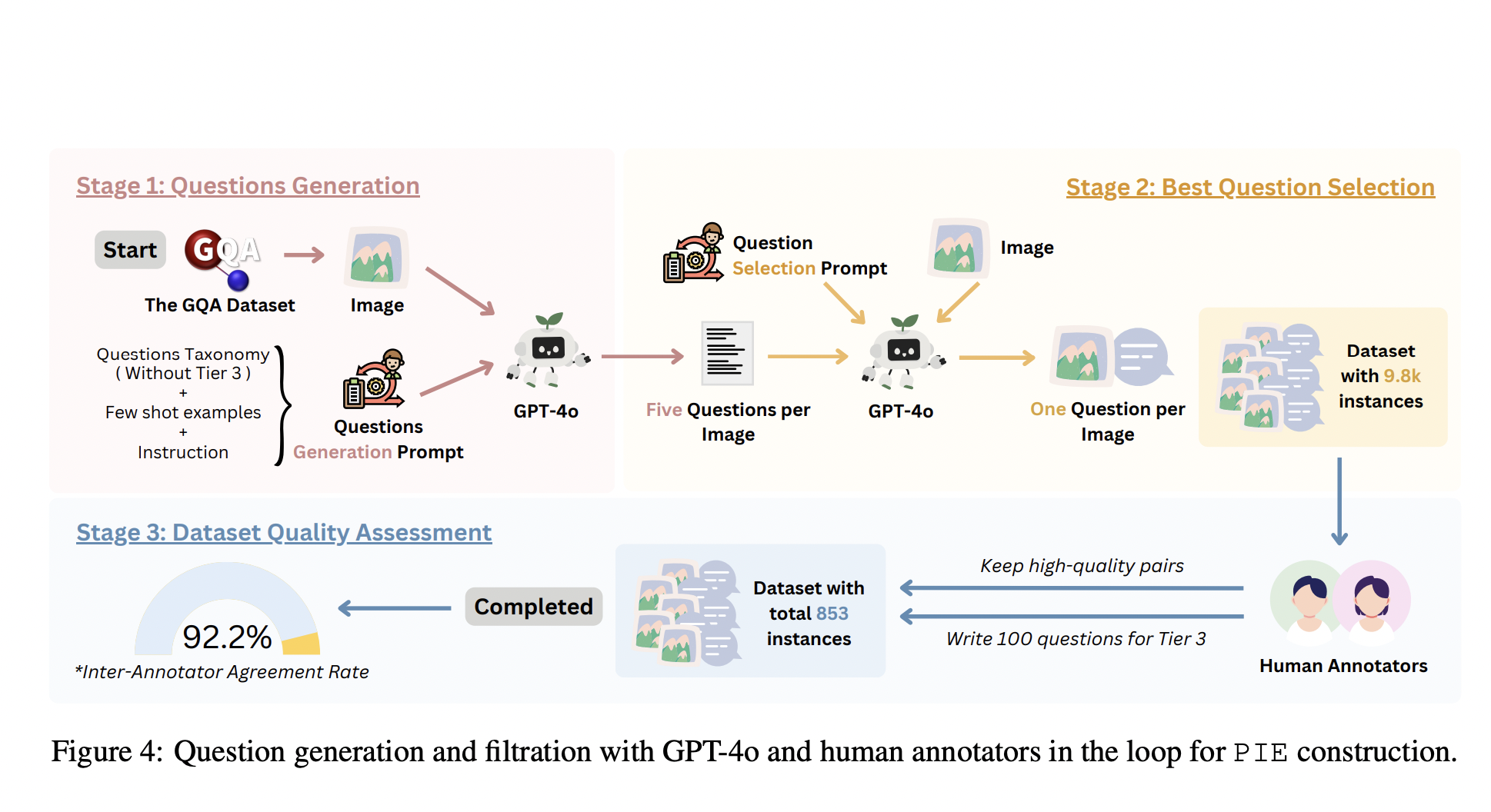

MACAROON обучает LVLMs создавать пары контрастных ответов на основе описаний задач и критериев, определенных людьми. Это позволяет моделям различать хорошие и плохие ответы, стандартизируя данные обучения. Результаты показывают положительное изменение в поведении LVLMs, обеспечивая более динамичное и проактивное взаимодействие (0.84 AAR после применения MACAROON).

MACAROON также предлагает создание набора данных с предпочтениями, что облегчает масштабирование. Техника требует участия аннотаторов для разработки подробных описаний вопросов и определения критериев для желаемого и нежелательного поведения LVLMs. Результаты показывают, что MACAROON значительно превосходит другие LVLMs в проактивном взаимодействии и общих задачах видео-языка.

Заключение

Исследователи представили MACAROON, интегрирующий контрастные ответы в условное обучение, что позволяет LVLMs эффективнее взаимодействовать с людьми. Основное внимание уделяется исследованию проактивных возможностей LVLMs в англоязычной среде. Однако подход имеет ограничения и требует дальнейших исследований для расширения его применимости.

Подробнее ознакомьтесь с статьей и GitHub. Вся заслуга за это исследование принадлежит его авторам.

Присоединяйтесь к нашему Telegram-каналу и группе в LinkedIn.

Если вам нравится наша работа, вам понравится и наша рассылка.

Не забудьте присоединиться к нашему SubReddit.

Источник: MarkTechPost

«`