«`html

Решения на основе искусственного интеллекта (ИИ) для эффективной работы вашей компании

Проблема:

Большие предварительно обученные генеративные трансформеры показали выдающуюся производительность в различных задачах генерации естественного языка, но их адаптация для конкретных приложений через тонкую настройку представляет существенные трудности.

Решение:

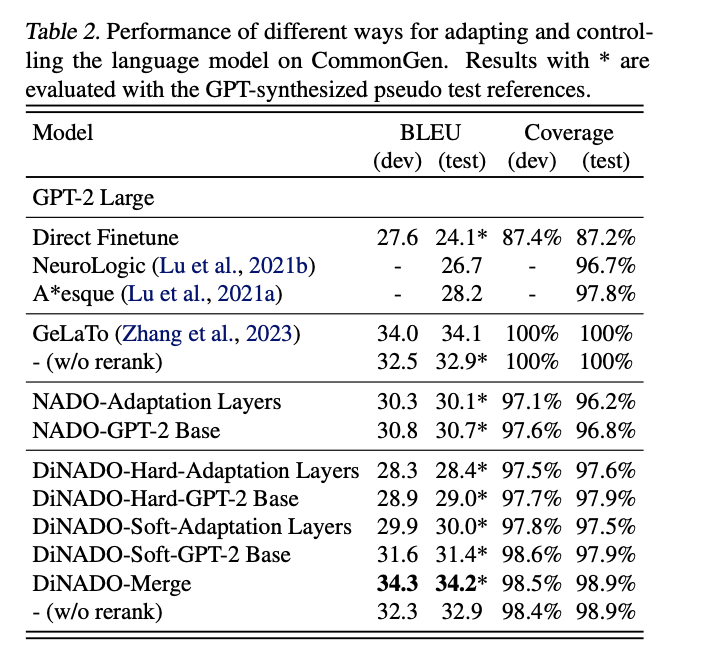

Методы, такие как prompt-tuning, NeurAlly-Decomposed Oracles (NADO) и GeLaTo Algorithm, предлагают практические подходы для адаптации моделей к новым задачам с минимальными данными, улучшая контроль и генерацию текста.

Практическое применение:

Исследователи из Университета Калифорнии, Лос-Анджелес, Amazon AGI и Samsung Research America представили улучшенную параметризацию алгоритма NADO под названием DiNADO. Он улучшает сходимость NADO во время тонкой настройки и сосредотачивается на уникальности глобальных оптимумов параметров. DiNADO демонстрирует превосходную эффективность в контролируемых задачах генерации текста, обеспечивая более гибкий и управляемый подход.

Заключение:

DiNADO представляет собой важное улучшение в области контролируемой генерации языка, открывая новые возможности для более эффективных приложений генерации текста.

Подробнее ознакомьтесь с статьей. Вся заслуга за это исследование принадлежит исследователям проекта. Также не забудьте подписаться на нас в Twitter и LinkedIn. Присоединяйтесь к нашему каналу в Telegram. Если вам нравится наша работа, вам понравится наш рассылка.

Не забудьте присоединиться к нашему сообществу в Reddit.

Этот пост был опубликован на сайте MarkTechPost.

«`