«`html

Решение для ускорения обработки длинного контекста: введение SampleAttention для эффективной обработки длинного контекста

Большие языковые модели (LLM) теперь поддерживают очень длинные окна контекста, но квадратичная сложность стандартного внимания приводит к значительно увеличенной задержке до первого токена (TTFT). Существующие методы решения этой сложности требуют дополнительного предварительного обучения или донастройки и часто ухудшают точность модели. Квадратичная природа механизма внимания в этих моделях значительно увеличивает вычислительное время, делая реальное взаимодействие вызовом. Текущие решения обычно ухудшают точность модели или требуют дополнительного предварительного обучения, что часто является непрактичным.

Практическое решение

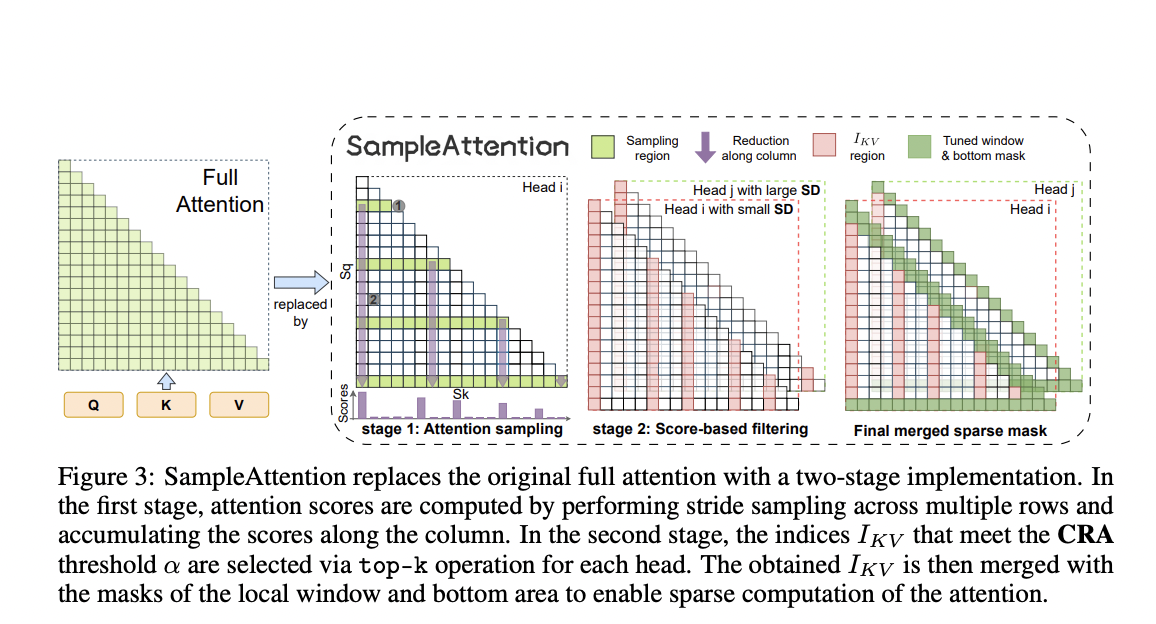

Метод SampleAttention был разработан для динамического захвата разреженных шаблонов во время выполнения с низкими накладными расходами. Он фокусируется на двух основных разреженных шаблонах: локальных оконных шаблонах и шаблонах столбцов. Локальные оконные шаблоны обрабатываются путем внимания к фиксированному проценту смежных токенов, обеспечивая эффективный захват важных локальных зависимостей. Шаблоны столбцов управляются с помощью двухэтапного подхода фильтрации ключ-значение (KV) под управлением запроса, который адаптивно выбирает минимальный набор ключей-значений для поддержания низких вычислительных накладных расходов.

Практическая ценность

SampleAttention значительно снижает задержку до первого токена (TTFT) и обеспечивает значительное ускорение операций внимания без практически никаких потерь точности. Это практичное решение для интеграции в предварительно обученные модели, обеспечивая эффективную обработку важной информации и делая SampleAttention многообещающим прорывом для реального времени применения LLM.

Подробнее о статье можно узнать здесь. Вся заслуга за это исследование принадлежит исследователям этого проекта. Также не забудьте подписаться на наш Twitter.

Присоединяйтесь к нашему каналу в Telegram и группе в LinkedIn.

Если вам понравилась наша работа, вам понравится и наша рассылка.

Не забудьте присоединиться к нашему сообществу в Reddit.

Источник: MarkTechPost.

«`