«`html

Развитие и применение технологий обработки естественного языка с использованием искусственных нейронных сетей

Технологии обработки естественного языка (NLP) значительно продвинулись благодаря нейронным сетям, в частности, благодаря трансформерным моделям, которые стали стандартом в этой области. Однако их высокие требования к памяти и вычислительным ресурсам создают серьезные проблемы, особенно для задач, требующих обработки длинных контекстов. Эта проблема побуждает к поиску более эффективных альтернатив, способных поддерживать высокие стандарты производительности при меньших затратах ресурсов.

Проблема трансформерных моделей и пути ее решения

Главная проблема трансформерных моделей заключается в их высоких требованиях к памяти и вычислительным ресурсам. Несмотря на их хорошую производительность в задачах NLP, они могли бы быть более практичными в условиях ограниченных ресурсов. Такая сложность подчеркивает необходимость моделей с более низким вычислительным потреблением, способных обеспечить сопоставимую или лучшую производительность по сравнению с текущими моделями. Решение этой проблемы существенно для повышения удобства и доступности современной технологии NLP в различных областях применения.

Практические решения и исследования

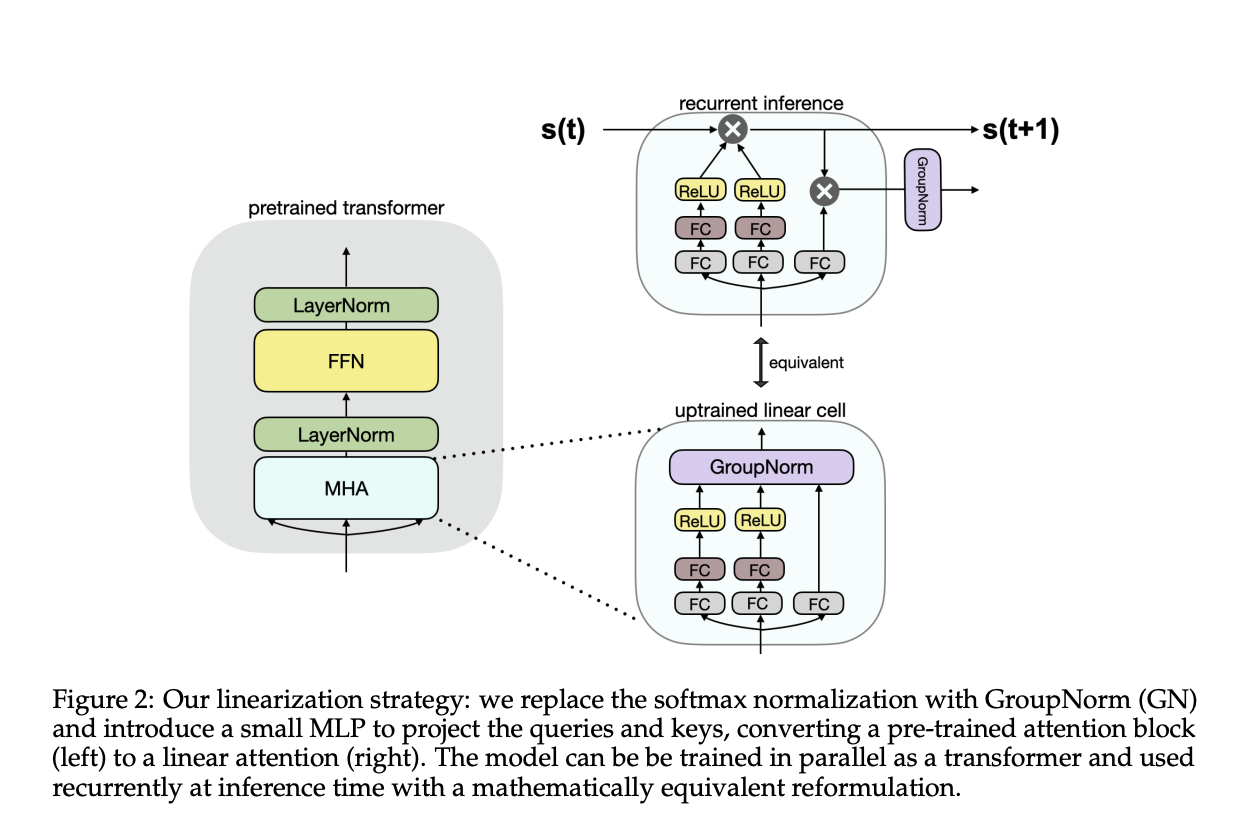

Существующие исследования включают в себя различные методы, направленные на повышение эффективности трансформеров, такие как Linear Transformers, RWKV, RetNet, H3, Hyena, Performers, Cosformer, LUNA и Griffin. Однако исследователи из Toyota Research Institute представили метод Scalable UPtraining for Recurrent Attention (SUPRA), который преобразует предварительно обученные трансформеры в рекуррентные нейронные сети (RNNs). Этот подход сочетает в себе преимущества трансформеров и RNNs, обеспечивая конкурентоспособную производительность при сниженных вычислительных затратах.

Конкурентоспособность и потенциал SUPRA метода

Метод SUPRA показал конкурентоспособные результаты на различных бенчмарках, превзойдя другие модели. Он достиг высоких оценок на задачах HellaSwag, ARC-E и ARC-C, требуя при этом значительно меньшего объема тренировочных данных. Несмотря на некоторые падения производительности в задачах с длинным контекстом, SUPRA продемонстрировал надежные результаты в рамках своей длины контекста обучения.

Заключение и перспективы

Метод SUPRA успешно преобразует предварительно обученные трансформеры в эффективные RNNs, решая проблему высоких вычислительных затрат традиционных трансформеров. Это подходит для различных задач NLP, открывая перспективы для более доступных технологий обработки языка.

Для получения дополнительной информации ознакомьтесь с статьей, а также с проектом на GitHub. Поддержите исследователей этого проекта, следите за нами в Twitter и присоединяйтесь к нашим каналам в Telegram, Discord и LinkedIn.

Если вас интересует внедрение искусственного интеллекта, свяжитесь с нами на Telegram или следите за новостями в нашем Телеграм-канале и на Twitter.

Ознакомьтесь с AI Sales Bot здесь, который поможет автоматизировать процессы в отделе продаж и снизить нагрузку на первую линию поддержки.

Узнайте, как решения от AI Lab itinai.ru могут изменить ваши бизнес-процессы и обеспечить конкурентное преимущество.

«`