«`html

Эффективное развертывание крупномасштабных моделей трансформера: стратегии масштабируемого и низколатентного вывода

Масштабирование моделей на основе трансформера до более чем 100 миллиардов параметров привело к прорывным результатам в обработке естественного языка. Эти большие языковые модели отлично себя проявляют в различных приложениях, но их эффективное развертывание представляет вызовы из-за последовательной природы генеративного вывода, где вычисление каждого токена зависит от предшествующих токенов. Это требует тщательной параллельной организации и оптимизации памяти. Исследование выделяет ключевые инженерные принципы для эффективного обслуживания крупномасштабных моделей трансформера в различных производственных средах, обеспечивая масштабируемость и низкую задержку вывода.

Оптимизация вывода для крупных моделей трансформера

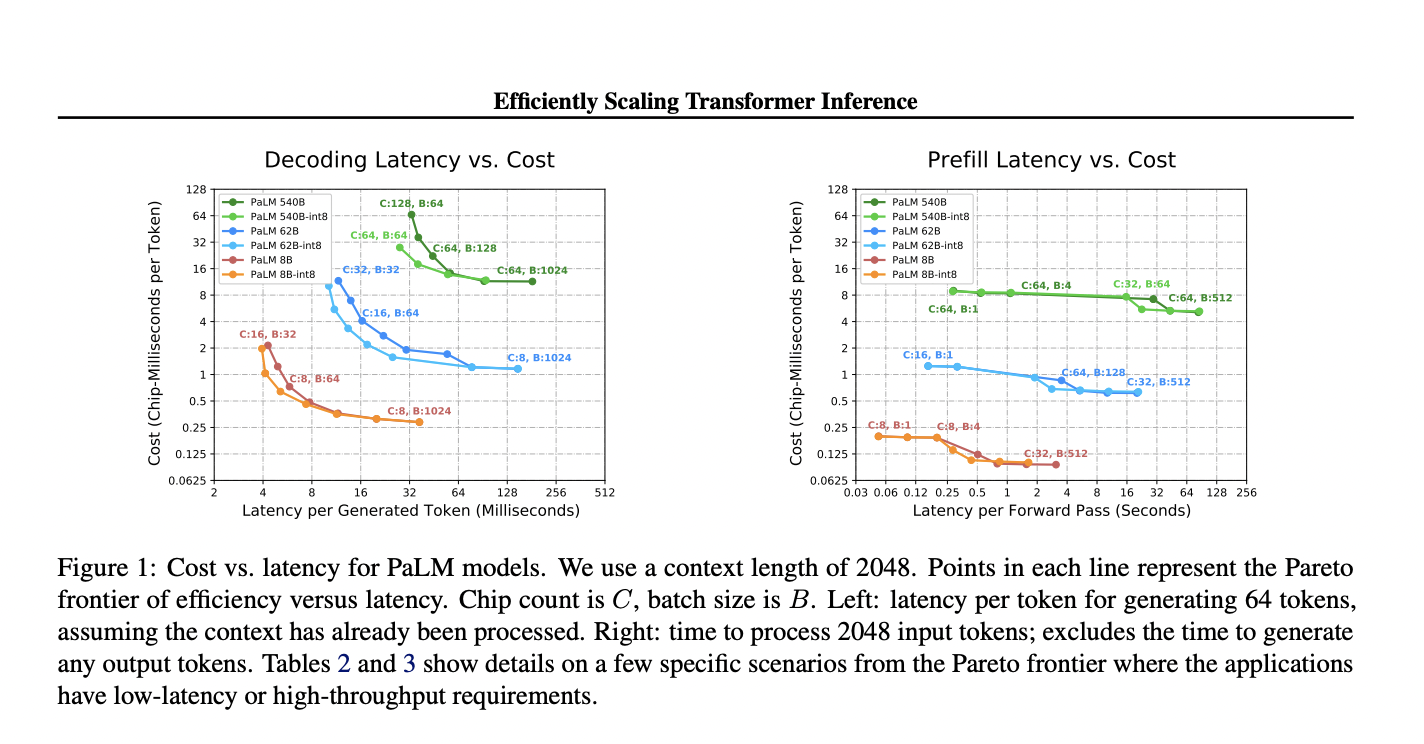

Исследователи Google изучают эффективный генеративный вывод для крупных моделей трансформера, сосредотачиваясь на жестких целях задержки и длинных последовательностях. Они разработали аналитическую модель для оптимизации многомерных методов разделения для срезов TPU v4 и реализовали оптимизацию на низком уровне. Это позволило достичь превосходной задержки и компромиссов между использованием FLOPS модели (MFU) для моделей с более чем 500 миллиардами параметров, превзойдя бенчмарки FasterTransformer. Используя многозапросное внимание, они масштабировали длины контекста до 32× больше. Их модель PaLM 540B достигла задержки в 29 мс на токен с квантованием int8 и 76% использования MFU, поддерживая длину контекста в 2048 токенов, выделяя практические применения в чат-ботах и высокопроизводительном офлайн-выводе.

Эффективные стратегии для развертывания крупных моделей

Предыдущие работы по эффективному разделению для обучения крупных моделей включают NeMo Megatron, GSPMD и Alpa, которые используют параллелизм тензоров и конвейерную параллельность с оптимизацией памяти. FasterTransformer устанавливает бенчмарки для вывода на нескольких GPU и узлах, в то время как DeepSpeed Inference использует ZeRO для выгрузки на CPU и память NVMe. EffectiveTransformer уменьшает заполнение, упаковывая последовательности. В отличие от них, данное исследование разрабатывает стратегии разделения на основе аналитических компромиссов. Для улучшения эффективности вывода подходы включают в себя эффективные слои внимания, дистилляцию, обрезку и квантование. Исследование включает квантование модели для ускорения вывода и предлагает, что его техники могут дополнить другие методы сжатия.

Оптимизация производительности крупных моделей

Увеличение размеров моделей улучшает их возможности, но увеличивает задержку, пропускную способность и стоимость вывода MFU. Ключевые метрики включают задержку (время предварительной загрузки и декодирования), пропускную способность (обрабатываемые/генерируемые токены в секунду) и MFU (наблюдаемая против теоретической пропускной способности). Большие модели сталкиваются с проблемами памяти и вычислений, при малых размерах партий преобладают времена загрузки весов, а при больших — кэш KV. Эффективный вывод требует балансирования низкой задержки и высокой пропускной способности через стратегии, такие как 1D/2D разделение весов. Механизмы внимания влияют на использование памяти, многозапросное внимание уменьшает размер кэша KV, но увеличивает коммуникационные издержки.

Исследование моделей PaLM

В исследовании моделей PaLM были оценены такие техники, как многозапросное внимание и параллельные слои внимания/прямого распространения с использованием JAX и XLA на чипах TPU v4. Для модели PaLM 540B улучшение эффективности разделения было достигнуто путем увеличения внимания к заполнению. Были протестированы различные стратегии разделения: 1D и 2D расположение весов и собранные веса, причем 2D показал лучшие результаты при более высоких значениях чипов. Многозапросное внимание позволило использовать более длинные контексты с меньшим использованием памяти по сравнению с многоголовым вниманием. Исследование продемонстрировало, что оптимизация разделения на основе размера партии и фазы (предварительная загрузка против генерации) критична для балансирования эффективности и задержки.

Демократизация доступа к крупным моделям трансформера

Большие модели трансформера революционизируют различные области, но для демократизации их доступа требуются значительные достижения. Это исследование исследует масштабирование рабочих нагрузок по выводу трансформера и предлагает практические методы разделения, чтобы удовлетворить строгие требования к задержке, особенно для моделей с более чем 500 миллиардами параметров. Оптимальные задержки были достигнуты путем масштабирования вывода на 64+ чипах. Многозапросное внимание с эффективным разделением уменьшает затраты памяти для вывода с длинным контекстом. Хотя масштабирование улучшает производительность, количество операций с плавающей запятой и объем коммуникации остаются ограничивающими факторами. Техники, такие как разреженные архитектуры и адаптивные вычисления, которые уменьшают количество операций с плавающей запятой на токен и объем коммуникации между чипами, обещают дальнейшие улучшения стоимости и задержки.

Проверьте статью. Вся заслуга за это исследование принадлежит исследователям этого проекта. Также не забудьте подписаться на наш Twitter.

Присоединяйтесь к нашему Telegram каналу и группе LinkedIn.

Если вам нравится наша работа, вам понравится наш новостной бюллетень.

Не забудьте присоединиться к нашему SubReddit.

Источник: MarkTechPost.

«`