«`html

Градформер: метод машинного обучения, интегрирующий графовые трансформеры (GT) с внутренними индуктивными смещениями путем применения экспоненциальной маски затухания к матрице внимания

Графовые трансформеры (GT) успешно достигли передовой производительности на различных платформах. GT могут захватывать информацию на большие расстояния от узлов, в отличие от локальной передачи сообщений в графовых нейронных сетях (GNN). Кроме того, механизм самовнимания в GT позволяет каждому узлу прямо смотреть на другие узлы в графе, помогая собирать информацию из произвольных узлов. Тот же механизм самовнимания в GT также обеспечивает гибкость и способность собирать информацию глобально и адаптивно.

Несмотря на преимущества во многих задачах, механизм самовнимания в GT не уделяет достаточного внимания особенностям графов, таким как связанные с структурой смещения. Несмотря на то, что некоторые методы, учитывающие эти особенности, используют позиционное кодирование и модель смещения внимания для индуктивных смещений, они неэффективны в преодолении этой проблемы. Кроме того, механизм самовнимания не использует все преимущества внутренних смещений признаков в графах, что создает серьезные проблемы в захвате существенной информации о структуре графа. Пренебрежение структурной корреляции может привести к равному вниманию каждому узлу механизмом, что создает недостаточное внимание к ключевой информации и агрегацию избыточной информации.

Практические решения и ценность

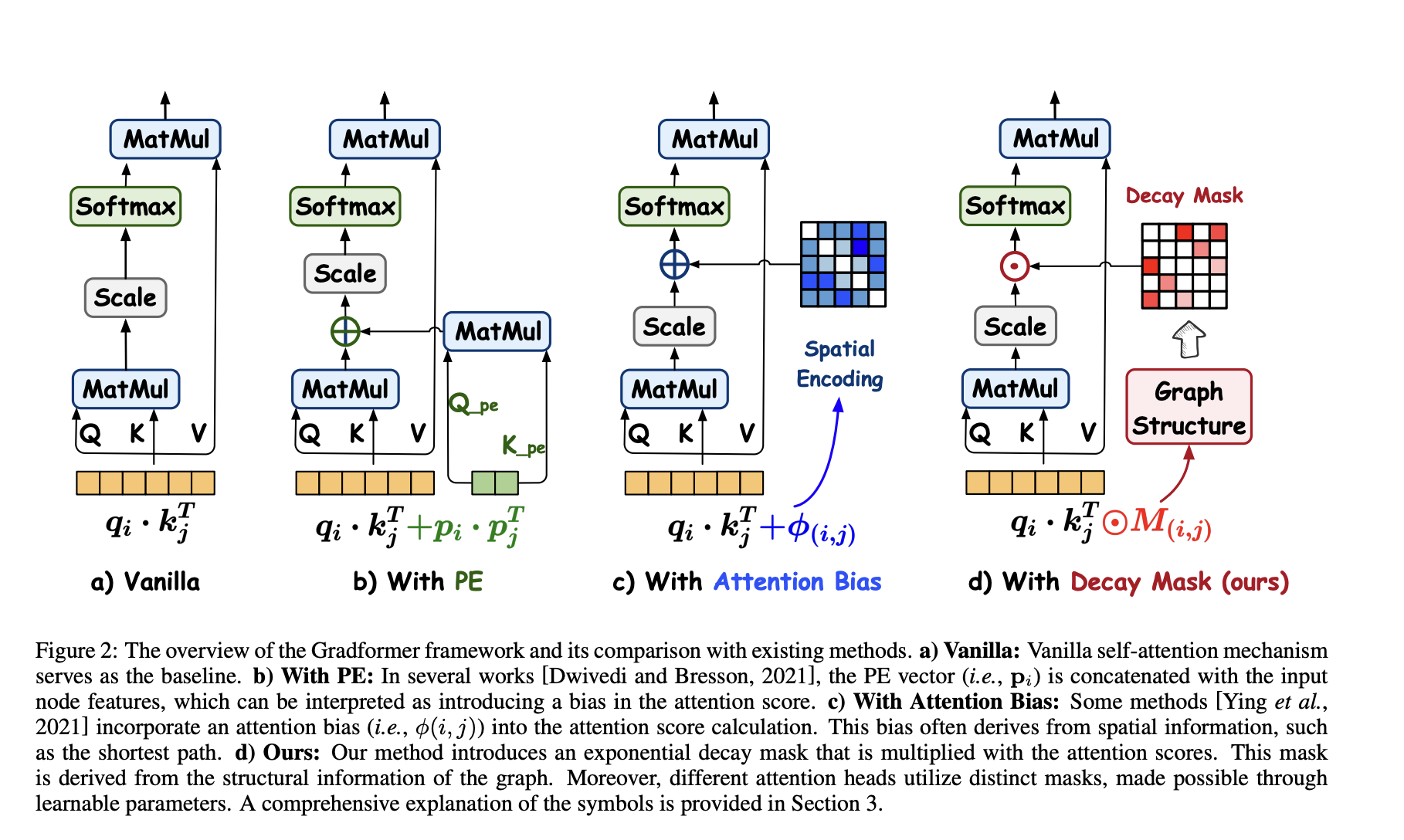

Исследователи из Университета Ухань в Китае, Академии JD Explore в Китае, Университета Мельбурна и Университета Гриффита в Брисбене предложили Gradformer, новый метод, который инновационно интегрирует GT с индуктивным смещением. Gradformer включает специальную функцию под названием экспоненциальная маска затухания в архитектуру самовнимания GT. Этот подход помогает контролировать веса внимания каждого узла относительно других узлов путем умножения маски на оценку внимания. Постепенное уменьшение весов внимания из-за экспоненциального затухания помогает маске эффективно направлять процесс обучения в рамках механизма самовнимания.

Gradformer достигает передовых результатов на пяти наборах данных, подчеркивая эффективность предложенного метода. При тестировании на небольших наборах данных, таких как NC11 и PROTEINS, он превосходит все 14 методов с улучшениями на 2,13% и 2,28% соответственно. Это показывает, что Gradformer эффективно интегрирует индуктивные смещения в модель GT, что становится важным, если доступные данные ограничены. Более того, он хорошо справляется с большими наборами данных, такими как ZINC, что показывает его применимость к наборам данных различного размера.

Исследователи провели анализ эффективности Gradformer и сравнили его стоимость обучения с другими важными методами, такими как SAN, Graphormer и GraphGPS, в основном сосредотачиваясь на параметрах, таких как использование памяти GPU и время. Полученные результаты сравнения показали, что Gradformer оптимально балансирует эффективность и точность, превосходя SAN и GraphGPS в вычислительной эффективности и точности. Кроме того, несмотря на более длительное время работы по сравнению с Graphormer, он превосходит Graphormer в точности, показывая свое превосходство в использовании ресурсов с хорошими результатами производительности.

В заключение, исследователи предложили Gradformer, новый метод интеграции GT с внутренними индуктивными смещениями, достигнутый путем применения экспоненциальной маски затухания с обучаемыми параметрами к матрице внимания. Gradformer превосходит 14 методов GT и GNN с улучшениями на 2,13% и 2,28% соответственно. Gradformer отличается своей способностью поддерживать или даже превосходить точность поверхностных моделей при интеграции более глубоких архитектур сетей. Будущая работа над Gradformer включает (a) изучение возможности достижения передовой структуры без использования MPNN и (b) исследование способности операции маски затухания улучшать эффективность GT.

Проверьте статью. Вся заслуга за это исследование принадлежит исследователям этого проекта. Также не забудьте подписаться на наш Twitter. Присоединяйтесь к нашему каналу в Telegram, каналу в Discord и группе в LinkedIn.

Если вам нравится наша работа, вам понравится наша рассылка.

Не забудьте присоединиться к нашему 40k+ ML SubReddit

Исследователи предложили Gradformer, новый метод интеграции GT с внутренними индуктивными смещениями, достигнутый путем применения экспоненциальной маски затухания с обучаемыми параметрами к матрице внимания. Gradformer превосходит 14 методов GT и GNN с улучшениями на 2,13% и 2,28% соответственно. Gradformer отличается своей способностью поддерживать или даже превосходить точность поверхностных моделей при интеграции более глубоких архитектур сетей. Будущая работа над Gradformer включает (a) изучение возможности достижения передовой структуры без использования MPNN и (b) исследование способности операции маски затухания улучшать эффективность GT.

Проверьте статью. Вся заслуга за это исследование принадлежит исследователям этого проекта. Также не забудьте подписаться на наш Twitter. Присоединяйтесь к нашему каналу в Telegram, каналу в Discord и группе в LinkedIn.

Если вам нравится наша работа, вам понравится наша рассылка.

Не забудьте присоединиться к нашему 40k+ ML SubReddit

Если вы хотите, чтобы ваша компания развивалась с помощью искусственного интеллекта (ИИ) и оставалась в числе лидеров, грамотно используйте Gradformer: A Machine Learning Method that Integrates Graph Transformers (GTs) with the Intrinsic Inductive Bias by Applying an Exponential Decay Mask to the Attention Matrix .

Проанализируйте, как ИИ может изменить вашу работу. Определите, где возможно применение автоматизации: найдите моменты, когда ваши клиенты могут извлечь выгоду из AI.

Определитесь какие ключевые показатели эффективности (KPI): вы хотите улучшить с помощью ИИ.

Подберите подходящее решение, сейчас очень много вариантов ИИ. Внедряйте ИИ решения постепенно: начните с малого проекта, анализируйте результаты и KPI.

На полученных данных и опыте расширяйте автоматизацию.

Если вам нужны советы по внедрению ИИ, пишите нам на https://t.me/itinai. Следите за новостями о ИИ в нашем Телеграм-канале t.me/itinainews или в Twitter @itinairu45358

Попробуйте AI Sales Bot https://itinai.ru/aisales Этот AI ассистент в продажах, помогает отвечать на вопросы клиентов, генерировать контент для отдела продаж, снижать нагрузку на первую линию.

Узнайте, как ИИ может изменить ваши процессы с решениями от AI Lab itinai.ru будущее уже здесь!

«`