«`html

Мультимодельные языковые модели в искусственном интеллекте

Мультимодельные языковые модели представляют собой новое направление в искусственном интеллекте, направленное на улучшение понимания машиной текста и изображений. Эти модели интегрируют визуальную и текстовую информацию для интерпретации и рассуждения в сложных данных. Их возможности выходят за пределы простого понимания текста, перенося искусственный интеллект в более сложные сферы, где машинное обучение взаимодействует с реальным миром. Они обещают значительные преимущества в использовании искусственного интеллекта в повседневных приложениях.

Требование к точной оценке мультимодельных моделей

С ростом сложности и возможностей мультимодельных моделей возрастает необходимость точной оценки их производительности. Существующие бенчмарки часто быстро устаревают, требуя большей специфичности для выявления различий между моделями и понимания их уникальных преимуществ. Это подчеркивает необходимость разработки сложного бенчмарка, который может точно измерять способность этих моделей понимать и решать сложные задачи реального мира.

Появление новых исследований в области мультимодельных моделей

Существующие исследования включают модели, такие как GPT-4V от OpenAI, которая интегрирует понимание текста и изображений, и Gemini 1.5 от Google, которая акцентирует мультимодальные возможности. Claude-3 серии от Anthropic продемонстрировалась масштабируемость с моделями Opus и Sonnet, в то время как набор Reka, включающий Core и Flash, представляет совершенные методы оценки. Эволюция LLaVA показывает постоянные улучшения в рассуждениях и интеграции знаний, а арена-стильные платформы, такие как LMSys и WildVision, обеспечивают динамичные платформы для оценки моделей в реальном времени.

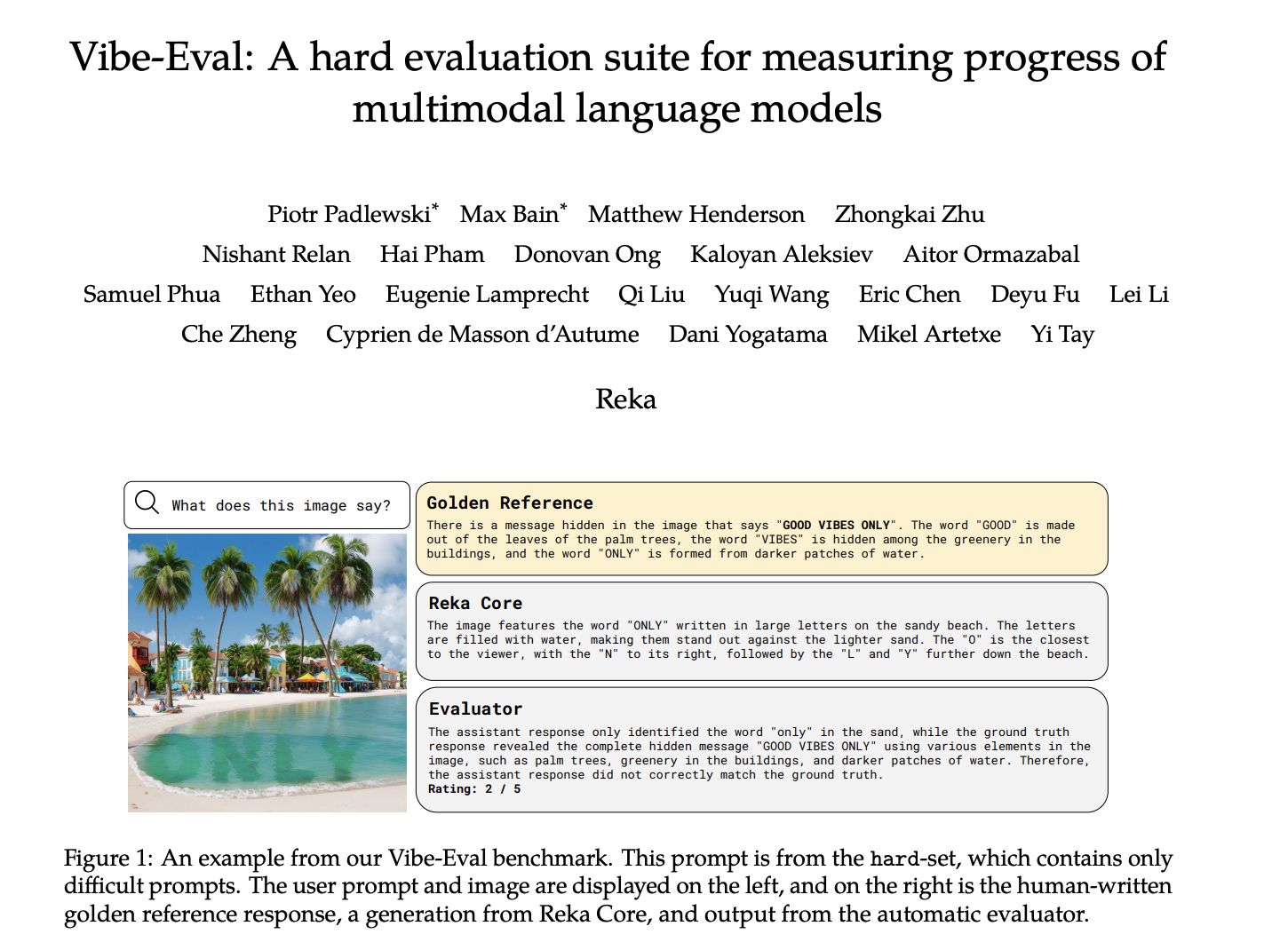

Внедрение нового бенчмарка Vibe-Eval

Исследователи из Reka Technologies представили Vibe-Eval — передовой бенчмарк для оценки мультимодельных языковых моделей. Он выделяется тем, что предоставляет структурированную систему тестирования визуальных возможностей этих моделей. Отличительной особенностью этого бенчмарка является его намеренно высокая сложность, фокусирующаяся на тонком рассуждении и понимании контекста. Комплексные задания Vibe-Eval, в сочетании с автоматической и человеческой оценкой, обеспечивают точную оценку, раскрывая уникальные сильные стороны и ограничения каждой модели в контролируемой и практической среде.

Методология Vibe-Eval

Методология Vibe-Eval включает сбор 269 визуальных заданий в нормальные и сложные сеты, каждый из которых сопровождается экспертно разработанными стандартными ответами. Reka Core, текстовый оценщик, оценивает производительность модели по шкале от 1 до 5 на основе точности по сравнению со стандартными ответами. Среди протестированных моделей — Gemini Pro 1.5 от Google, GPT-4V от OpenAI и другие. Задания отражают разнообразные сценарии, вызывая модели к точной интерпретации текста и изображений. Помимо автоматической оценки, периодические человеческие оценки предлагают комплексную оценку, подтверждающую ответы модели и выявляющую области, в которых современные мультимодельные модели проявляют свои преимущества или недостатки.

Результаты оценки

Результаты оценки показывают, что Gemini Pro 1.5 и GPT-4V показали лучшие результаты, со средними баллами 60,4% и 57,9% соответственно. Reka Core получил общий балл 45,4%, в то время как модели, такие как Claude Opus и Claude Haiku, получили около 52%. На сложном сете Gemini Pro 1.5 и GPT-4V сохраняют своё лидерство, в то время как производительность Reka Core снизилась до 38,2%. Модели с открытым исходным кодом, такие как LLaVA и Idefics-2, получили примерно 30% в общем, подчеркивая значительные различия в возможностях моделей и необходимость строгой оценки, подобной Vibe-Eval.

Заключение

Исследование представляет Vibe-Eval — набор бенчмарков от Reka Technologies, разработанный для тщательной оценки производительности мультимодельных языковых моделей. Через подборку из 269 заданий, Vibe-Eval предоставляет тонкое понимание возможностей модели, раскрывая её сильные и слабые стороны в визуально-текстовом понимании. Результаты подчеркивают значительные различия в производительности моделей, таких как Gemini Pro 1.5, GPT-4V и Reka Core. Полученные выводы подчеркивают важность комплексных бенчмарков для направления будущих разработок в области мультимодального искусственного интеллекта, обеспечивая прогресс моделей в сложности и возможностях.

Проверьте Статью и Блог. Весь кредит за это исследование принадлежит исследователям этого проекта. Также не забудьте подписаться на нас в Twitter. Присоединяйтесь к нашему каналу в Telegram, Discord и LinkedIn.

Если вам нравится наша работа, вам понравится наша рассылка.

Не забудьте присоединиться к нашему 40k+ ML SubReddit.

Новая статья от @RekaAILabs. Она включает в себя сложный сет, который, на мой взгляд, довольно сложен для передовых моделей сегодня.

Интересно то, что мы строим его, пытаясь… pic.twitter.com/W6hN70KEzL

Публикация озвучивает статью о ИИ от Reka AI, представляющую Vibe-Eval: комплексный набор для оценки мультимодельных моделей ИИ.

Это был последний пост на MarkTechPost.

«`