«`html

Видур: крупномасштабная симуляционная платформа, революционизирующая развертывание LLM путем снижения затрат и повышения эффективности

Крупные языковые модели (LLM), такие как GPT-4 и Llama, находятся во главе обработки естественного языка, позволяя различные приложения, от автоматизированных чат-ботов до продвинутого анализа текста. Однако развертывание этих моделей затруднено высокими затратами и необходимостью тонкой настройки множества параметров системы для достижения оптимальной производительности.

Практические решения и ценность

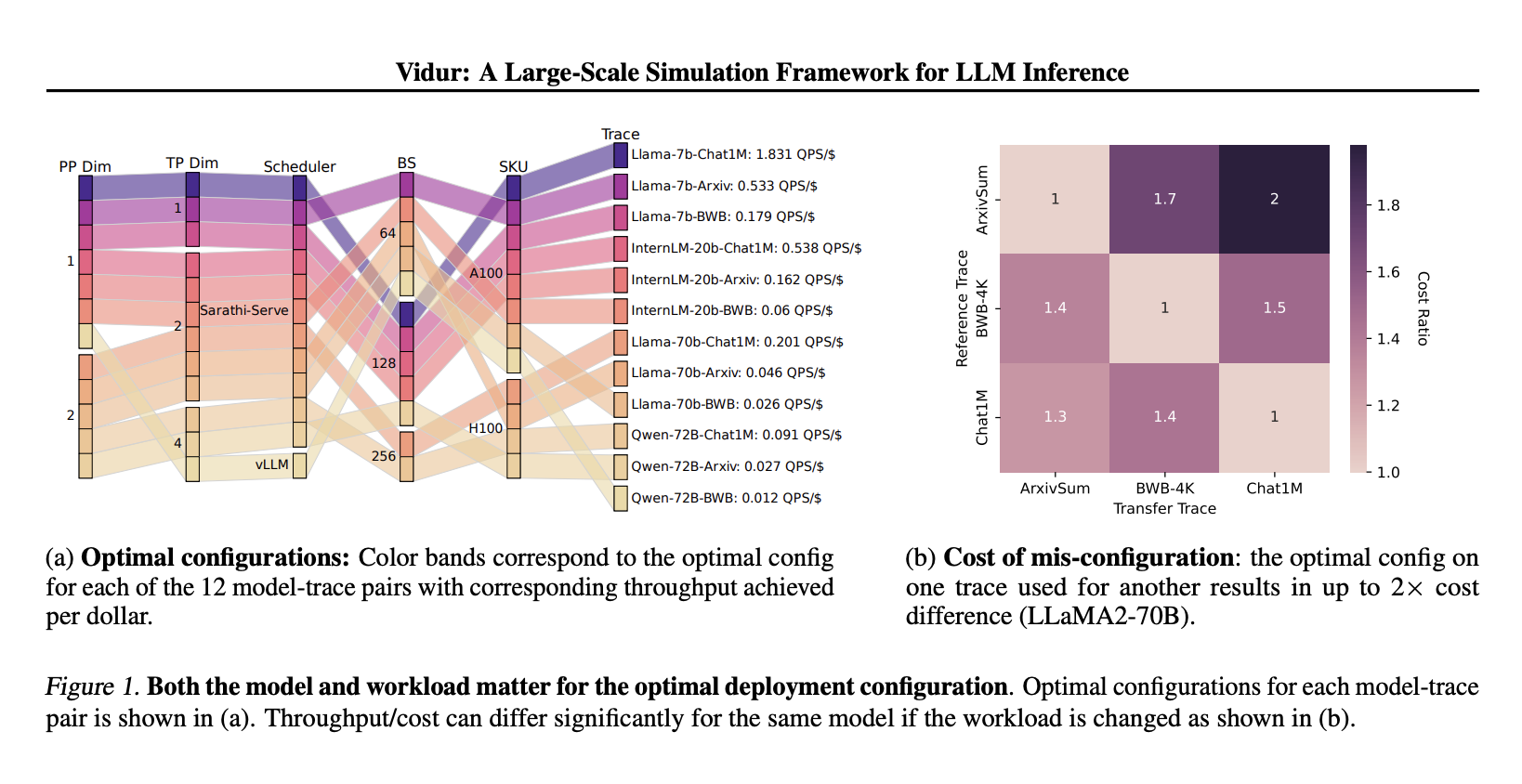

Деплоймент LLM включает сложный процесс выбора среди различных конфигураций системы, таких как параллелизация модели, стратегии пакетирования и политики планирования. Традиционно эта оптимизация требует обширных и дорогостоящих экспериментов. Например, поиск наиболее эффективной конфигурации развертывания модели LLaMA2-70B может потребовать более 42 000 часов работы GPU и обойтись примерно в 218 000 долларов.

Группа исследователей из Грузинского технологического института и Microsoft Research India разработала Vidur — симуляционную платформу, специально предназначенную для вывода LLM. Vidur использует комбинацию экспериментальных данных и прогностического моделирования для симуляции производительности LLM в различных конфигурациях. Эта симуляция позволяет оценивать ключевые показатели производительности, такие как задержка и пропускная способность, без дорогих и длительных физических испытаний.

Одним из ключевых компонентов Vidur является его инструмент поиска конфигурации, Vidur-Search, который автоматизирует исследование конфигураций развертывания. Этот инструмент эффективно определяет наиболее экономичные настройки, удовлетворяющие заранее определенным критериям производительности. Например, Vidur-Search определил оптимальную настройку для модели LLaMA2-70B на платформе CPU всего за один час, что обычно требовало бы обширных ресурсов GPU.

Возможности Vidur распространяются на оценку различных LLM на различных аппаратных платформах и конфигурациях кластера, поддерживая точность предсказания менее чем 9% ошибок для задержки вывода. Кроме того, платформа представляет Vidur-Bench, набор тестов, который облегчает комплексную оценку производительности с использованием различных образцов рабочей нагрузки и конфигураций системы.

На практике Vidur продемонстрировал значительное снижение затрат на развертывание LLM. Использование Vidur-Search в симуляционных средах значительно сократило потенциальные расходы. Эффективность достигается без ущерба точности или актуальности результатов, обеспечивая практичность и эффективность оптимизации производительности.

В заключение, симуляционная платформа Vidur решает проблему высоких затрат и сложности развертывания крупных языковых моделей, представляя инновационный метод, объединяющий экспериментальное профилирование с прогностическим моделированием. Этот подход позволяет точную симуляцию производительности LLM в различных конфигурациях, значительно сокращая необходимость дорогих и длительных физических испытаний. Эффективность Vidur подчеркивается способностью точно настраивать конфигурации развертывания, достигая менее чем 9% ошибок в прогнозах задержки и резкого сокращения часов работы GPU и связанных затрат, что делает ее ключевым инструментом для оптимизации развертывания LLM в практичных, экономичных способах.

Проверьте статью и GitHub. Вся заслуга за это исследование принадлежит исследователям этого проекта. Также не забудьте подписаться на нас в Twitter. Присоединяйтесь к нашему Telegram-каналу, каналу в Discord и группе в LinkedIn.

Если вам понравилась наша работа, вам понравится и наш бюллетень.

Не забудьте присоединиться к нашему подпишитесь на наш SubReddit.

Опубликовано на MarkTechPost.

«`