«`html

Преобразование сложности с помощью трансформеров: исследователи из Anthropic предлагают новую математическую модель для упрощения моделей трансформеров

Трансформеры находятся на передовых позициях современного искусственного интеллекта, обеспечивая системы, способные понимать и генерировать человеческий язык. Они являются основой нескольких влиятельных моделей ИИ, таких как Gemini, Claude, Llama, GPT-4 и Codex, которые сыграли важную роль в различных технологических достижениях. Однако по мере роста размера и сложности этих моделей они часто проявляют непредвиденное поведение, часть из которого может быть проблематичной. Эта проблема требует надежной структуры для понимания и устранения потенциальных проблем по мере их возникновения.

Проблема сложности в моделях на основе трансформеров

Одной из значительных проблем в моделях на основе трансформеров является их склонность к увеличению сложности, что затрудняет предсказание и контроль их результатов. Эта непредсказуемость может привести не только к неожиданным, но иногда и вредоносным результатам, вызывая опасения относительно безопасности и надежности использования этих моделей в реальных сценариях. Основная причина проблемы заключается в открытом дизайне моделей, который, хотя и позволяет создавать гибкие и мощные приложения, также приводит к широкому спектру непреднамеренных поведенческих аспектов.

Практические решения и ценность

Для решения этих проблем были предприняты усилия по демистификации внутренних механизмов трансформеров через механистическую интерпретацию. Этот подход включает разбиение сложных операций этих моделей на более понятные компоненты, фактически пытаясь разобрать сложные механизмы на что-то, что можно легко проанализировать и понять. Традиционные методы добились некоторого успеха в интерпретации более простых моделей, но трансформеры, с их глубокой и сложной архитектурой, представляют более серьезное испытание.

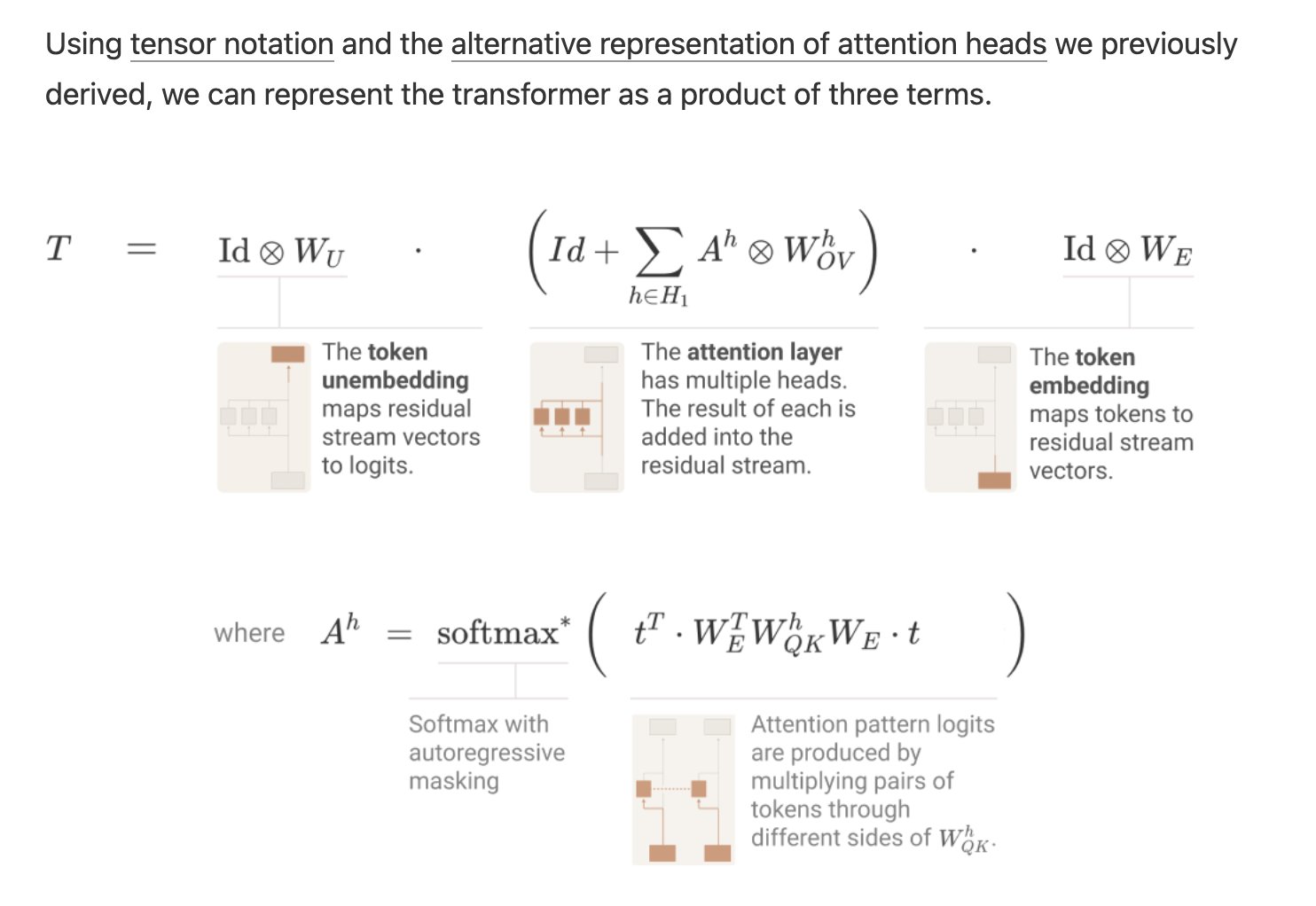

Исследователи из Anthropic предложили математическую модель для упрощения понимания трансформеров, сосредотачиваясь на более маленьких, менее сложных моделях. Этот подход переосмысливает работу трансформеров в математически эквивалентный способ, который легче управлять и понимать. Модель специально рассматривает трансформеры с не более чем двумя слоями и фокусируется исключительно на блоках внимания, игнорируя другие общие компоненты, такие как многослойные перцептроны (MLP), для ясности и простоты.

Исследование продемонстрировало, что этот новый взгляд позволяет более ясно понять, как трансформеры обрабатывают информацию. Особенно он выделил роль конкретных блоков внимания, называемых «индукционными блоками», в облегчении так называемого контекстного обучения. Эти блоки развивают значительные возможности только в моделях с не менее чем двумя слоями внимания. Изучая эти более простые модели, исследователи смогли выявить и описать алгоритмические шаблоны, которые потенциально могут быть применены к более крупным и сложным системам.

Эмпирические результаты этого исследования предоставили количественные понимания функциональности этих моделей. Например, было показано, что трансформеры с нулевым слоем внимания в основном моделируют статистику биграмм, непосредственно доступную из весов. В отличие от этого, трансформеры только с одним и двумя слоями внимания проявляют более сложное поведение через композицию блоков внимания. Двухслойные модели, в частности, используют эти композиции для создания сложных алгоритмов контекстного обучения, значительно продвигая понимание того, как трансформеры учатся и адаптируются.

Заключение

Это исследование предлагает многообещающий путь к улучшению интерпретируемости и, следовательно, надежности моделей трансформеров. Разработав структуру, которая упрощает сложные операции трансформеров до более управляемых и понятных компонентов, исследовательская группа открыла новые возможности для улучшения безопасности и производительности моделей. Понимание, полученное из изучения более маленьких моделей, заложило основу для предвидения и устранения проблем более крупных и мощных систем, обеспечивая, что трансформеры будут развиваться инновационно и безопасно по мере их развития.

Если вы хотите, чтобы ваша компания развивалась с помощью искусственного интеллекта (ИИ) и оставалась в числе лидеров, грамотно используйте Decoding Complexity with Transformers: Researchers from Anthropic Propose a Novel Mathematical Framework for Simplifying Transformer Models.

Практические решения для вашего бизнеса

Проанализируйте, как ИИ может изменить вашу работу. Определите, где возможно применение автоматизации: найдите моменты, когда ваши клиенты могут извлечь выгоду из AI.

Определитесь, какие ключевые показатели эффективности (KPI) вы хотите улучшить с помощью ИИ.

Подберите подходящее решение, сейчас очень много вариантов ИИ. Внедряйте ИИ решения постепенно: начните с малого проекта, анализируйте результаты и KPI.

На полученных данных и опыте расширяйте автоматизацию.

Если вам нужны советы по внедрению ИИ, пишите нам на https://t.me/itinai. Следите за новостями о ИИ в нашем Телеграм-канале t.me/itinainews или в Twitter @itinairu45358.

Попробуйте AI Sales Bot https://itinai.ru/aisales. Этот AI ассистент в продажах помогает отвечать на вопросы клиентов, генерировать контент для отдела продаж, снижать нагрузку на первую линию.

Узнайте, как ИИ может изменить ваши процессы с решениями от AI Lab itinai.ru. Будущее уже здесь!

«`