«`html

Преимущества использования модульного подхода в развертывании искусственного интеллекта на платформе SambaNova SN40L

В области искусственного интеллекта (ИИ) широкое применение получили монолитные модели языка, такие как GPT-4, что существенно продвинуло современные генеративные приложения ИИ. Однако обслуживание, обучение и развертывание таких моделей масштаба сталкиваются с рядом сложностей, включая высокие затраты и сложности. Эти проблемы усугубляются растущим неравновесием между вычислительной мощностью и объемом памяти в современных ускорителях ИИ, что приводит к узкому месту, известному как «стена памяти». Это требует инновационных стратегий развертывания для сделать ИИ более доступным и реальным.

Решение: Подход Композиции Экспертов (CoE)

Подход Композиции Экспертов (CoE) предлагает перспективное решение для этих проблем. Путем интеграции множества более мелких, специализированных моделей, каждая из которых имеет значительно меньше параметров, чем монолитные модели, CoE может сопоставиться или превзойти производительность более крупных моделей. Эта модульная стратегия существенно снижает сложность и стоимость обучения и развертывания систем ИИ.

Практическое применение: Samba-CoE на платформе SambaNova SN40L

Исследователи из SambaNova Systems, Inc., исследуют инновационное применение CoE, развертывая систему Samba-CoE на устройстве SambaNova SN40L Reconfigurable Dataflow Unit (RDU). Этот коммерческий ускоритель потоков данных специально разработан для предприятий и обладает революционной трехуровневой системой памяти, что повышает операционную эффективность моделей ИИ.

Ключевым компонентом этой архитектуры является выделенная сеть между RDU, обеспечивающая масштабирование по множеству сокетов. Эта возможность критически важна для поддержки фреймворка CoE, который зависит от безупречной интеграции и коммуникации между множеством маленьких экспертных моделей.

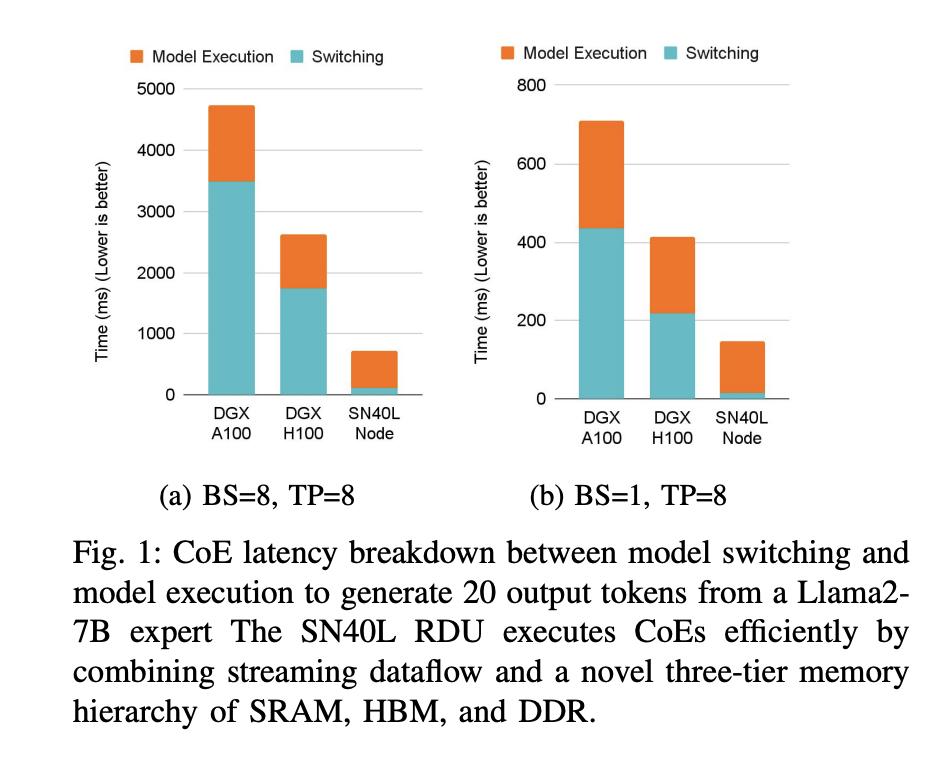

Практические выгоды развертывания CoE на платформе SambaNova проявляются в существенном уменьшении физического размера и операционных издержек систем ИИ. Например, 8-сокетный узел RDU уменьшает площадь машины до 19 раз и улучшает время переключения моделей на 15-31 раз. По совокупному ускорению система превосходит DGX H100 и DGX A100 в 3,7 и 6,6 раз соответственно.

В заключение, применение CoE на платформе SambaNova SN40L представляет собой значительный прорыв в развертывании технологий ИИ. Эта реализация устраняет проблему «стены памяти» и делает передовые возможности ИИ доступными для более широкого круга пользователей и приложений.

Подробнее ознакомьтесь с исследованием.

Все заслуги за это исследование принадлежат исследователям проекта. Также не забудьте подписаться на наш Twitter. Присоединяйтесь к нашему каналу в Telegram, Discord и группе в LinkedIn.

Если вам нравится наша работа, вам понравится наш новостной бюллетень.

Не забудьте присоединиться к нашему SubReddit с более чем 42 тысячами подписчиков.

Источник: MarkTechPost.