«`html

Эффективное параллельное метод для вывода LLM

Преимущества и практические решения

Большие языковые модели (LLM), в частности модели Generative Pre-trained Transformer (GPT), продемонстрировали высокую производительность в различных языковых задачах.

Однако сталкиваются с вызовами в их архитектуре декодера, в частности во времени до первого токена (TTFT) и времени на генерацию каждого последующего токена (TPOT).

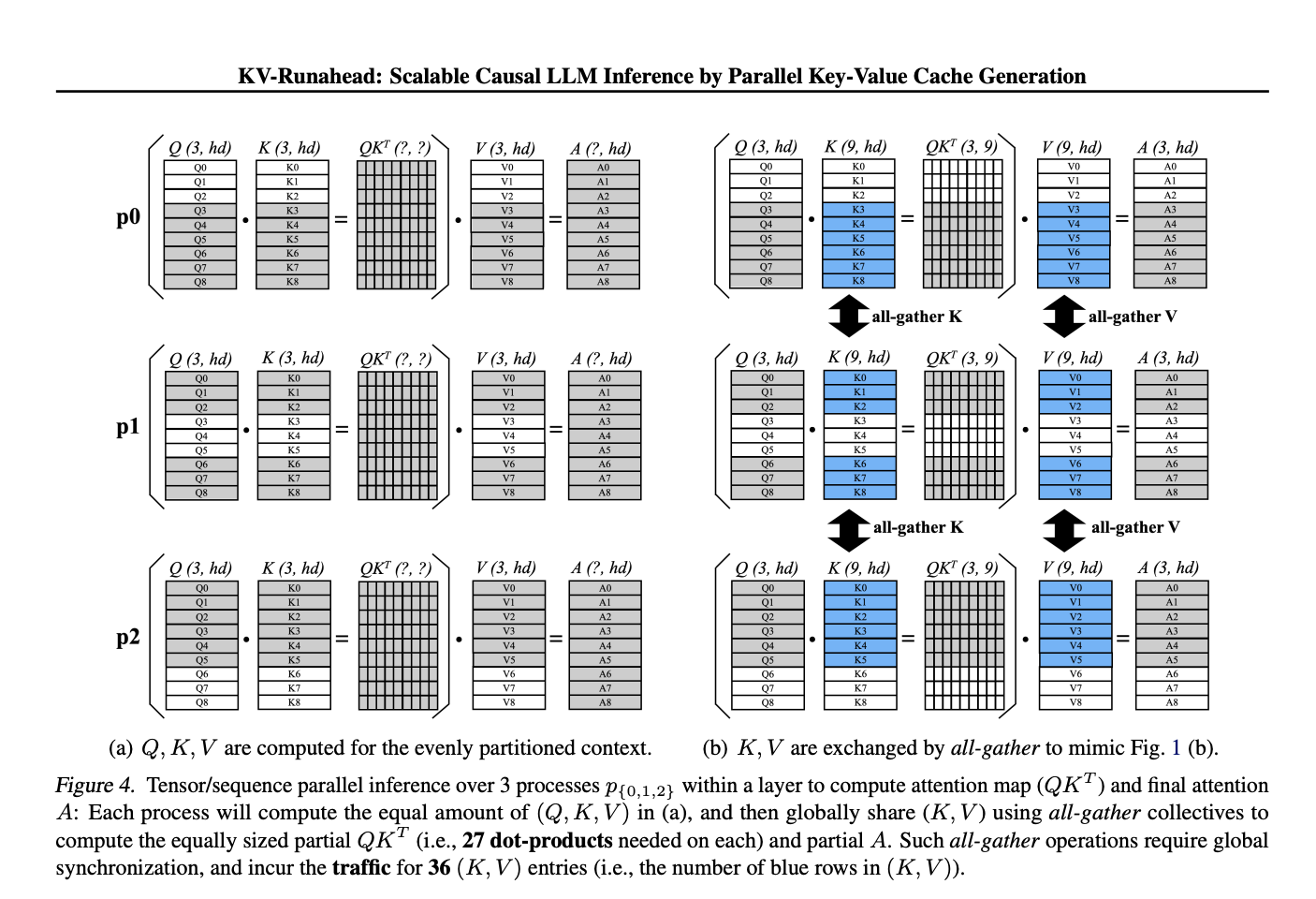

Новый метод KV-Runahead разработанный исследователями Apple оптимизирует параллельное распределение нагрузки, уменьшая время до первого токена значительно больше, чем существующие методы параллелизации.

Если вам нужна дополнительная информация, обращайтесь к нам в Telegram или следите за нашими новостями о ИИ в Телеграм-канале или Twitter.

Попробуйте наш AI Sales Bot itinai.ru/aisales — интеллектуальный помощник в продажах, который помогает в обслуживании клиентов, генерации контента и снижении нагрузки на первую линию.

«`