«`html

Применение техник локального сопоставления изображений для обобщения моделей

Техники сопоставления локальных особенностей помогают определять мелкие визуальные сходства между двумя изображениями. Однако существующие методы не всегда способны обобщать результаты на различные области изображений. Это приводит к снижению производительности моделей на данных, не входящих в их обучающий набор. Для решения этой проблемы необходимо разработать архитектурные улучшения, способствующие обобщению методов сопоставления.

Практические решения

Прежде чем глубокое обучение стало популярным, многие исследования сосредотачивались на разработке обобщаемых моделей локальных особенностей, таких как SIFT, SURF и ORB. Кроме того, существуют методы Sparse Learnable Matching, такие как SuperGlue, использующие SuperPoint для обнаружения ключевых точек и механизм внимания для внутри- и межизображенческой передачи информации о ключевых точках. Еще один метод, Dense image matching, обучает дескрипторы изображений и модуль сопоставления для выполнения сопоставления пикселей на всем входном изображении.

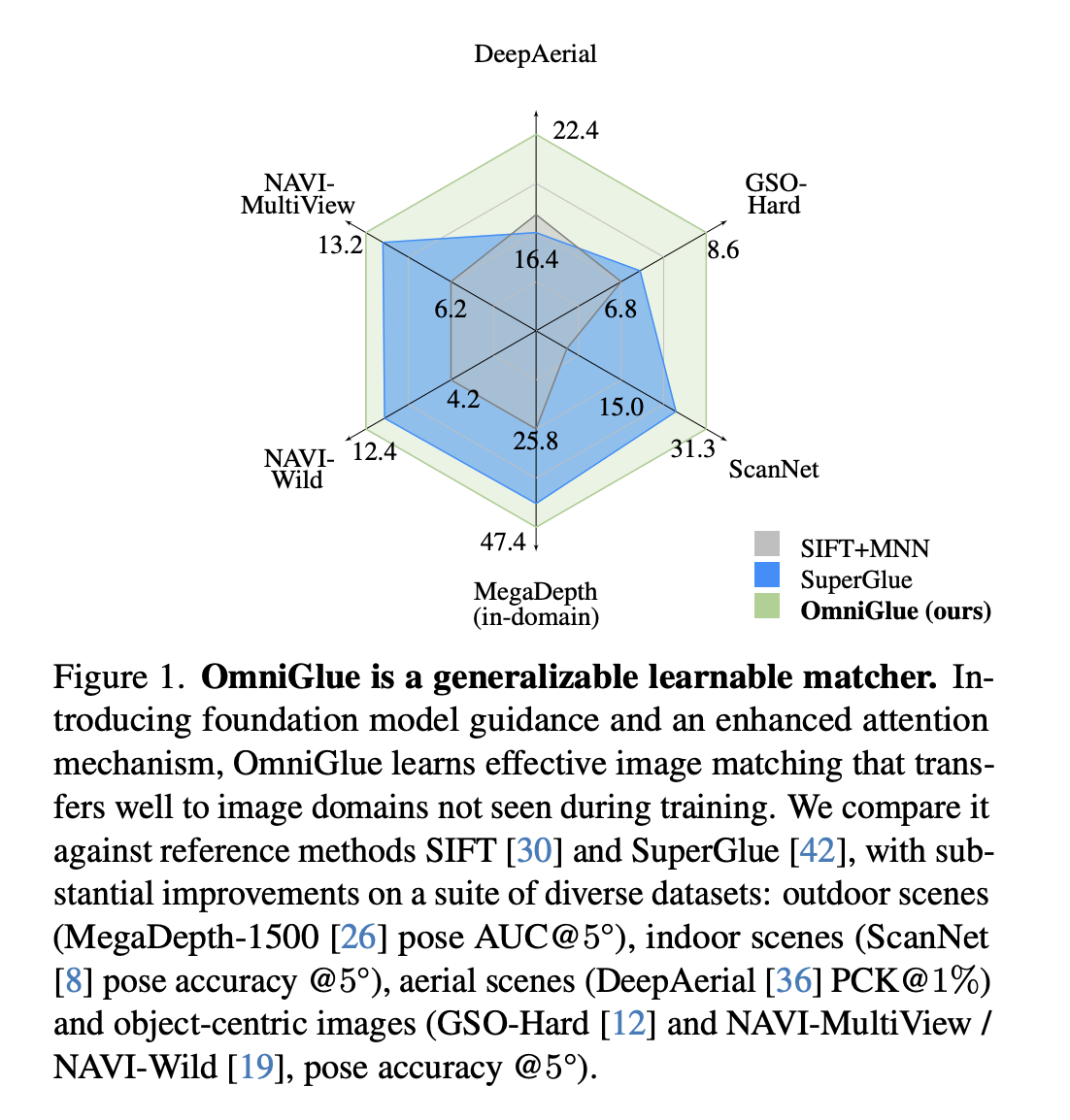

Исследователи из Университета Техаса в Остине и Google Research предложили OmniGlue, первый обучаемый сопоставитель изображений, разработанный с учетом обобщения как основополагающего принципа. Для улучшения обобщения слоев сопоставления исследователи ввели две техники: модельное руководство и внимание к позиции ключевой точки. OmniGlue использует эти техники для лучшего обобщения в области данных, не входящих в распределение, сохраняя при этом производительность на исходной области. Для разработки предложенного метода используется модель DINO, которая хорошо проявляет себя в области разнообразных изображений.

В результате экспериментов исследователи сравнили OmniGlue с (a) SIFT и SuperPoint, предоставляющими доменно-независимые локальные визуальные дескрипторы для ключевых точек, а также генерацией результатов сопоставления с использованием ближайшего соседа + теста отношения (NN/ratio) и взаимного ближайшего соседа (MNN), (b) Sparse Matchers, такими как SuperGlue, использующие слои внимания для информации о ключевых точках внутри и между изображениями, и дескрипторы, полученные из SuperPoint, а также (c) Semi-Dense Matchers, такие как LoFTR и PDCNet, используемые для контекстуализации производительности разреженного сопоставления.

Результаты показывают, что OmniGlue превосходит базовый метод SuperGlue в области данных внутри области и также обладает лучшим обобщением. Кроме того, OmniGlue превосходит SuperGlue, показывая 12,3% относительный прирост на MegaDepth-500 и улучшение воспроизведения на 15% во время переноса с SH200 на Megadepth.

Заключение

Исследователи из Университета Техаса в Остине и Google Research представили OmniGlue, первый обучаемый сопоставитель изображений, разработанный с учетом обобщения как основополагающего принципа. OmniGlue обладает сильными возможностями обобщения, превосходя базовый метод SuperGlue. Кроме того, предложенный метод легко адаптируется к целевой области с небольшим количеством данных для настройки. Будущая работа включает исследование использования неаннотированных данных в целевых областях для улучшения обобщения.

Подробнее ознакомьтесь с исследованием. Вся заслуга за это исследование принадлежит исследователям этого проекта. Также не забудьте подписаться на наш Twitter. Присоединяйтесь к нашему каналу в Telegram, Discord и группе в LinkedIn.

Если вам нравится наша работа, вам понравится наша рассылка.

Не забудьте присоединиться к нашему SubReddit с 42 тысячами подписчиков.

«`