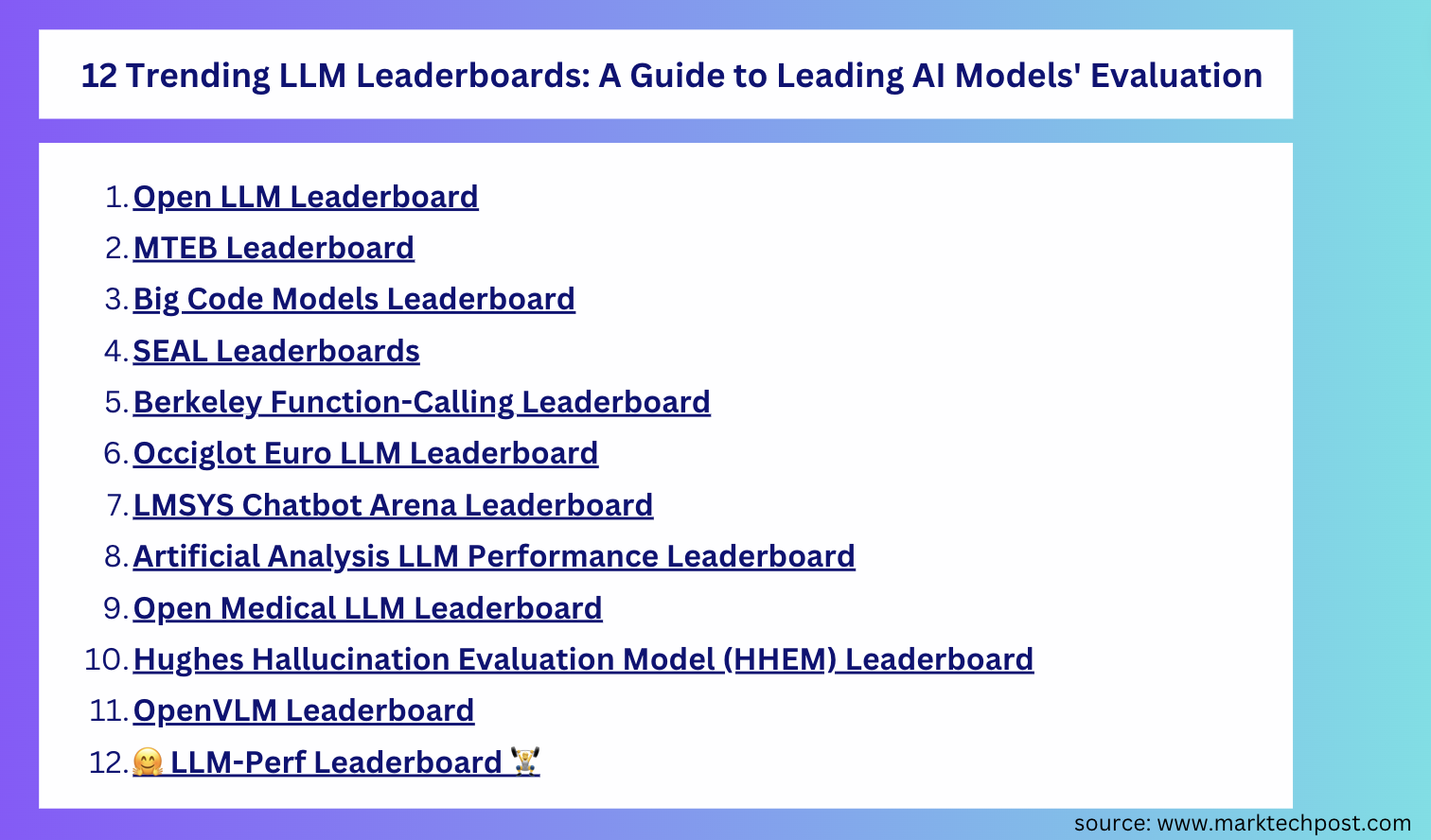

Top 12 Trending LLM Leaderboards: Гид по оценке передовых ИИ-моделей

С быстрым развитием крупных языковых моделей (LLM) возникает необходимость объективно оценивать их возможности на различных задачах. Для этого были разработаны специализированные лидерборды (таблицы рейтингов), в которых модели сравниваются по ряду критериев. Ниже — обзор 12 самых популярных и актуальных лидербордов, используемых сообществом ИИ в 2024–2025 годах.

1. Open LLM Leaderboard (Hugging Face)

Один из самых известных лидербордов, предоставляемый Hugging Face. Он сравнивает модели по следующим шести задачам:

- AI2 Reasoning Challenge (ARC)

- HellaSwag

- MMLU (Massive Multitask Language Understanding)

- TruthfulQA

- Winogrande

- GSM8k (арифметика)

Результаты позволяют объективно оценить способности модели к рассуждению, пониманию текста, честности и решению математических задач.

2. MTEB Leaderboard

MTEB (Massive Text Embedding Benchmark) оценивает вложения текста на 8 типах задач, включая:

- классификацию

- поиск информации

- парное сравнение и др.

Он охватывает более 58 наборов данных на 112 языках. Это делает его важным инструментом для оценки мультиязычных моделей.

3. Big Code Models Leaderboard

Фокус на моделях, предназначенных для генерации и анализа исходного кода. Задачи включают:

- дополнение кода

- исправление ошибок

- генерация функций

Полезен для оценки таких моделей, как StarCoder, Code Llama и других.

4. SEAL Leaderboards

Оценка LLM через систему рейтинга Elo, аналогичную шахматной. Используются задачи на разных языках и в разных стилях взаимодействия. Учитывается стабильность и надежность модели в конкурентной среде.

5. Berkeley Function-Calling Leaderboard

Оценивает, насколько эффективно модель может вызывать внешние функции и инструменты. Это критично для систем, работающих с внешними API или агентными архитектурами.

6. Occiglot Euro LLM Leaderboard

Мультизадачный и мультиязычный рейтинг, включающий задачи:

- Перевод

- Анализ сентимента

- Вопросно-ответный формат

Поддерживает множество европейских языков, включая малораспространенные.

7. LMSYS Chatbot Arena Leaderboard

Пожалуй, самый “человеческий” рейтинг — оценки происходят на основе более миллиона голосов пользователей, которые сравнивают поведение моделей в парных чатах. Это дает представление о реальном пользовательском опыте.

8. Artificial Analysis LLM Performance Leaderboard

Оценивает производительность LLM при вызовах через API, что важно для разработчиков, интегрирующих модели в реальные системы. Включает метрики скорости, стоимости и точности ответов.

9. Open Medical LLM Leaderboard

Фокусируется на задачах из области медицины, таких как:

- Клинические QA

- Медицина доказательств

- Анализ симптомов

Полезен для оценки LLM в медицинских системах поддержки принятия решений.

10. Hughes Hallucination Evaluation Model (HHEM) Leaderboard

Измеряет частоту «галлюцинаций» — ошибок или вымышленных фактов в сгенерированных ответах, особенно в задаче резюмирования документов. Особенно важен при оценке надёжности модели.

11. OpenVLM Leaderboard

Мультимодальный рейтинг, оценивающий Vision-Language Models (VLMs) на 23 различных задачах:

- Визуальный вопросно-ответный формат

- Генерация по изображениям

- Связывание текста и визуального контента

Покрывает 63 модели, включая Gemini, GPT-4V, LLaVA и др.

12. LLaMAIndex Leaderboard (дополнительно)

Хотя менее известен, этот рейтинг оценивает интеграцию LLM с базами данных и retrieval-системами, в частности в контексте RAG (Retrieval-Augmented Generation).

Заключение

Лидерборды играют ключевую роль в прозрачной и объективной оценке возможностей языковых моделей. Для исследователей и разработчиков они предоставляют:

- Сравнительный анализ

- Объективные метрики

- Выбор моделей под конкретные задачи

Регулярный мониторинг рейтингов позволяет отслеживать прогресс в области LLM и выбирать наиболее подходящие решения для ИИ-продуктов.