«`html

Оптимизация разреженных нейронных сетей для улучшения динамики обучения и эффективности

Разреженные нейронные сети направлены на оптимизацию вычислительной эффективности путем сокращения количества активных весов в модели. Эта техника важна, поскольку она решает проблему растущих вычислительных затрат, связанных с обучением и выводом в глубоком обучении. Разреженные сети улучшают производительность без плотных соединений, сокращая вычислительные ресурсы и энергопотребление.

Проблема и решение

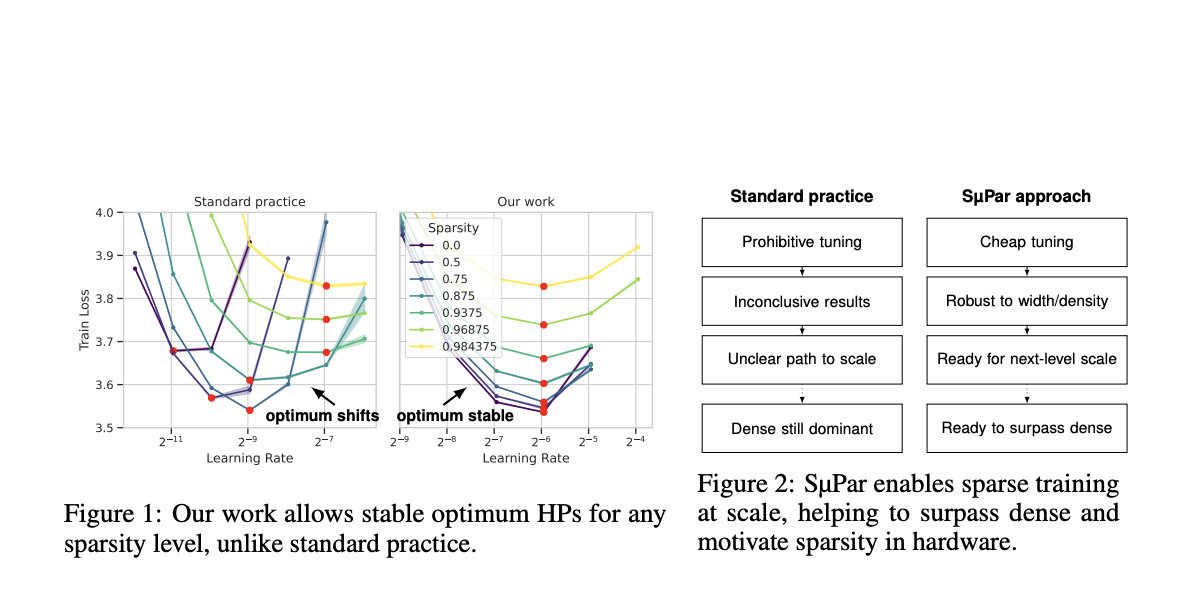

Главная проблема, решаемая в данном исследовании, заключается в необходимости более эффективного обучения разреженных нейронных сетей. Разреженные модели страдают от нарушения распространения сигнала из-за значительного количества весов, установленных в ноль. Эта проблема усложняет процесс обучения, затрудняя достижение уровня производительности, сравнимого с плотными моделями. Кроме того, настройка гиперпараметров для разреженных моделей затратна и занимает много времени, потому что оптимальные гиперпараметры для плотных сетей не подходят для разреженных. Это несоответствие приводит к неэффективным процессам обучения и увеличенным вычислительным нагрузкам.

Существующие методы обучения разреженных нейронных сетей часто включают повторное использование гиперпараметров, оптимизированных для плотных сетей, что может быть менее эффективным. Разреженные сети требуют различных оптимальных гиперпараметров, и введение новых гиперпараметров для разреженных моделей дополнительно усложняет процесс настройки. Эта сложность приводит к запредельным затратам на настройку, подрывая основную цель сокращения вычислений. Кроме того, отсутствие установленных рецептов обучения для разреженных моделей затрудняет их эффективное масштабирование.

Исследователи из Cerebras Systems представили новый подход, названный разреженная максимальная параметризация обновления (SμPar). Этот метод направлен на стабилизацию динамики обучения разреженных нейронных сетей, обеспечивая независимость масштабирования активаций, градиентов и обновлений весов от уровней разреженности. SμPar переопределяет гиперпараметры, позволяя одним и тем же значениям быть оптимальными при различных уровнях разреженности и ширине модели. Этот подход значительно сокращает затраты на настройку, позволяя оптимально настроенным гиперпараметрам для малых плотных моделей эффективно передаваться на большие разреженные модели.

SμPar корректирует инициализацию весов и скорости обучения для поддержания стабильной динамики обучения при различных уровнях разреженности и ширине модели. Он обеспечивает контроль масштабов активаций, градиентов и обновлений весов, избегая проблем вроде взрывающихся или затухающих сигналов. Этот метод позволяет гиперпараметрам оставаться оптимальными независимо от изменений разреженности и ширины модели, облегчая эффективное и масштабируемое обучение разреженных нейронных сетей.

Результаты и выводы

Эффективность SμPar продемонстрировала себя превосходной по сравнению со стандартными практиками. SμPar улучшил потери обучения до 8,2% в моделировании языка большого масштаба по сравнению с общепринятым подходом использования стандартной параметризации плотной модели. Это улучшение было замечено при различных уровнях разреженности, при этом SμPar формировало границу Парето для потерь, указывая на его устойчивость и эффективность. Согласно закону масштабирования Чинчиллы, эти улучшения переводятся в прирост вычислительной эффективности в 4,1× и 1,5×. Такие результаты подчеркивают эффективность SμPar в улучшении производительности и эффективности разреженных нейронных сетей.

В заключение, данное исследование решает неэффективности в текущих методах обучения разреженных сетей и представляет SμPar в качестве комплексного решения. Стабилизируя динамику обучения и сокращая затраты на настройку гиперпараметров, SμPar позволяет более эффективное и масштабируемое обучение разреженных нейронных сетей. Этот прогресс обещает улучшить вычислительную эффективность моделей глубокого обучения и ускорить принятие разреженности в аппаратном проектировании. Новый подход переопределения гиперпараметров для обеспечения стабильности при различных уровнях разреженности и ширине модели является значительным шагом в оптимизации нейронных сетей.

Проверьте статью. Вся заслуга за это исследование принадлежит исследователям этого проекта. Также не забудьте подписаться на наш Twitter. Присоединяйтесь к нашему каналу в Telegram, Discord и группе в LinkedIn.

Если вам нравится наша работа, вам понравится наша рассылка.

Не забудьте присоединиться к нашему подпреддиту о машинном обучении. Также ознакомьтесь с нашей платформой для событий по ИИ.

Источник: MarkTechPost

Применение искусственного интеллекта в вашем бизнесе

Если вы хотите, чтобы ваша компания развивалась с помощью искусственного интеллекта (ИИ) и оставалась в числе лидеров, грамотно используйте Sparse Maximal Update Parameterization (SμPar): Optimizing Sparse Neural Networks for Superior Training Dynamics and Efficiency.

Проанализируйте, как ИИ может изменить вашу работу. Определите, где возможно применение автоматизации: найдите моменты, когда ваши клиенты могут извлечь выгоду из AI.

Определитесь какие ключевые показатели эффективности (KPI): вы хотите улучшить с помощью ИИ.

Подберите подходящее решение, сейчас очень много вариантов ИИ. Внедряйте ИИ решения постепенно: начните с малого проекта, анализируйте результаты и KPI.

На полученных данных и опыте расширяйте автоматизацию.

Если вам нужны советы по внедрению ИИ, пишите нам на https://t.me/itinai. Следите за новостями о ИИ в нашем Телеграм-канале t.me/itinainews или в Twitter @itinairu45358.

Попробуйте AI Sales Bot https://itinai.ru/aisales. Этот AI ассистент в продажах, помогает отвечать на вопросы клиентов, генерировать контент для отдела продаж, снижать нагрузку на первую линию.

Узнайте, как ИИ может изменить ваши процессы с решениями от AI Lab itinai.ru будущее уже здесь!

«`