«`html

Оценка языковых моделей: ключевой аспект исследований в области искусственного интеллекта

Оценка языковых моделей — это критически важный аспект исследований в области искусственного интеллекта, направленный на оценку возможностей и производительности моделей в различных задачах. Эти оценки помогают исследователям понять сильные и слабые стороны различных моделей, что направляет будущее развитие и улучшения.

Стандартизация оценки языковых моделей: вызовы и практические решения

Одним из значительных вызовов в сообществе искусственного интеллекта является отсутствие стандартизированной системы оценки для LLMs. Это отсутствие стандартизации приводит к несогласованности в измерении производительности, что затрудняет воспроизведение результатов и справедливое сравнение различных моделей.

OLMES: открытый стандарт оценки языковых моделей

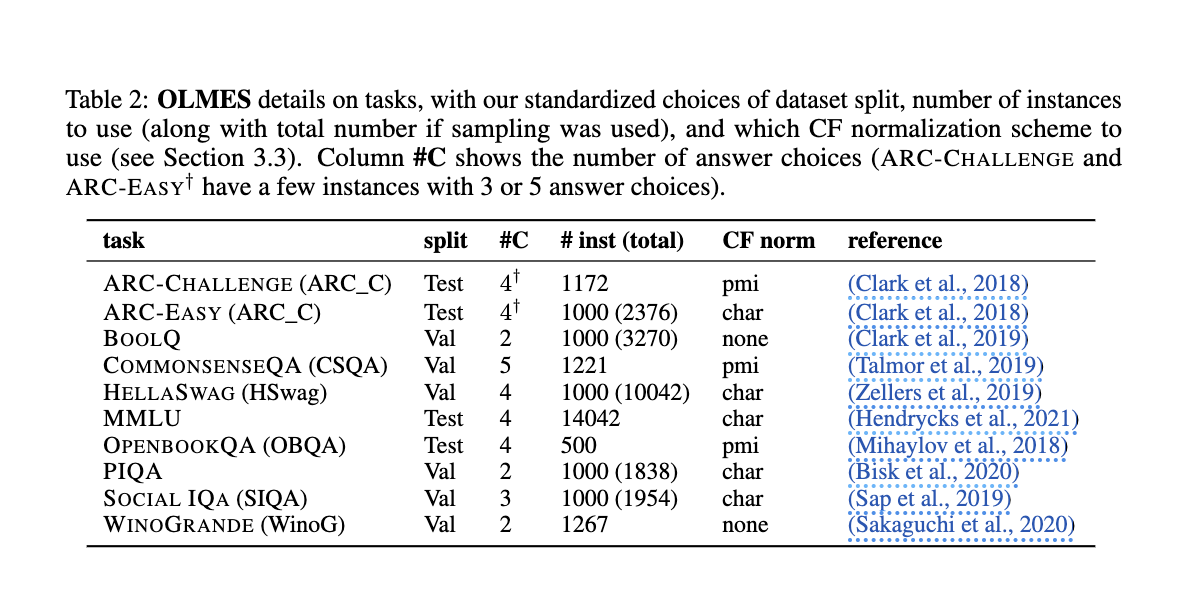

Исследователи из Allen Institute for Artificial Intelligence представили OLMES (Open Language Model Evaluation Standard), который призван решить эти проблемы. OLMES предлагает всеобъемлющий, практичный и полностью задокументированный стандарт для воспроизводимых оценок LLM. Этот стандарт поддерживает значимые сравнения между моделями, устраняя неоднозначности в процессе оценки.

Результаты и преимущества применения стандарта OLMES

Эксперименты показали, что OLMES обеспечивает более последовательные и воспроизводимые результаты. Например, модели Llama2-13B и Llama3-70B значительно улучшили свою производительность при оценке с использованием OLMES. Это подтверждает эффективность стандарта в обеспечении справедливых сравнений.

Завершение и перспективы

Введение стандарта OLMES успешно решает проблему несогласованных оценок в исследованиях по искусственному интеллекту. Этот новый стандарт предлагает комплексное решение, обеспечивая стандартизацию практик оценки и подробные рекомендации для всех аспектов процесса оценки. Применение OLMES позволяет достичь большей прозрачности, воспроизводимости и справедливости в оценке языковых моделей.

«`