«`html

LongRAG: Новая платформа искусственного интеллекта AI, объединяющая RAG с LLM длинного контекста для улучшения производительности

Методы Retrieval-Augmented Generation (RAG) усиливают возможности больших языковых моделей (LLM), интегрируя внешние знания, извлеченные из обширных корпусов. Этот подход особенно полезен для ответов на вопросы в открытом домене, где детальные и точные ответы критически важны. За счет использования внешней информации системы RAG могут преодолеть ограничения, связанные с полаганием только на параметрические знания, встроенные в LLM, что делает их более эффективными в обработке сложных запросов.

Проблема несбалансированности между компонентами retriever и reader

Одним из значительных вызовов в системах RAG является дисбаланс между компонентами retriever и reader. Традиционные фреймворки часто используют короткие единицы извлечения, такие как 100-словные отрывки, что требует от retriever’а просеивать большие объемы данных. Это конструктивное решение создает значительную нагрузку на retriever, в то время как задача reader остается относительно простой, что приводит к неэффективности и потенциальной семантической неполноте из-за усечения документов. Этот дисбаланс ограничивает общую производительность систем RAG и требует переосмысления их дизайна.

Решение: внедрение нового фреймворка LongRAG

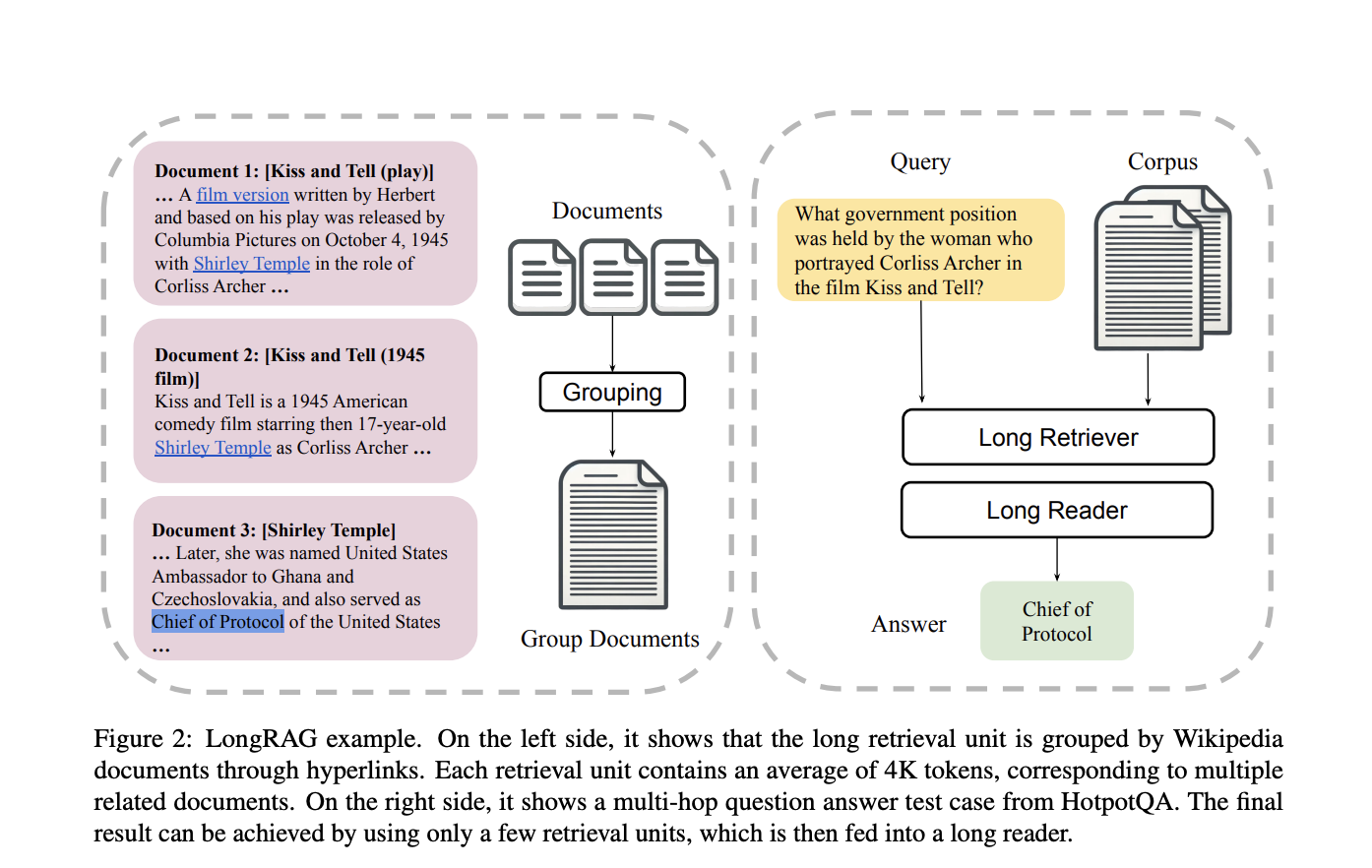

Для преодоления этих вызовов исследовательская группа Университета Ватерлоо представила новый фреймворк под названием LongRAG. Этот фреймворк включает «длинный retriever» и «длинный reader», предназначенные для обработки более длинных единиц извлечения, примерно по 4 тыс. токенов в каждой. Увеличение размера единиц извлечения в LongRAG сокращает количество единиц с 22 миллионов до 600 тысяч, значительно облегчая нагрузку на retriever и улучшая показатели извлечения. Этот инновационный подход позволяет retriever’у обрабатывать более полные информационные единицы, повышая эффективность и точность системы.

LongRAG оперирует путем группировки связанных документов в длинные единицы извлечения, которые затем обрабатывает длинный retriever для идентификации соответствующей информации. Для извлечения конечных ответов retriever фильтрует лучшие 4-8 единиц, объединяет их и передает в длинный LLM, такой как Gemini-1.5-Pro или GPT-4o. Этот метод использует продвинутые возможности LLM для эффективной обработки больших объемов текста, обеспечивая тщательное и точное извлечение информации.

В целом, методика включает использование кодировщика для отображения входного вопроса в вектор и другого кодировщика для отображения единиц извлечения в векторы. Сходство между вопросом и единицами извлечения рассчитывается для определения наиболее релевантных единиц. Длинный retriever просматривает эти единицы, сокращая размер корпуса и улучшая точность извлечения. Полученные единицы объединяются и передаются в длинный reader, который использует контекст для генерации конечного ответа. Такой подход обеспечивает обработку комплексного набора информации reader’ом, улучшая общую производительность системы.

Впечатляющая производительность LongRAG

На наборе данных Natural Questions (NQ) LongRAG достиг точности совпадения (EM) 62,7%, значительный прорыв по сравнению с традиционными методами. На наборе данных HotpotQA он достиг EM-показателя 64,3%. Эти впечатляющие результаты демонстрируют эффективность LongRAG, соответствующую производительности передовых моделей RAG, настроенных на высокую точность. Фреймворк сократил размер корпуса в 30 раз и улучшил извлечение ответов на приблизительно 20 процентных пунктов по сравнению с традиционными методами, демонстрируя показатель извлечения ответа@1 в 71% на NQ и 72% на HotpotQA.

Способность LongRAG обрабатывать длинные единицы извлечения сохраняет семантическую целостность документов, обеспечивая более точные и полные ответы. Путем снижения нагрузки на retriever и использования продвинутых LLM длинного контекста LongRAG предлагает более сбалансированный и эффективный подход к retrieval-augmented generation. Исследование Университета Ватерлоо не только предоставляет ценные идеи для модернизации дизайна систем RAG, но и подчеркивает захватывающий потенциал для дальнейших достижений в этой области, внушая оптимизм в отношении будущего систем retrieval-augmented generation.

В заключение

LongRAG представляет собой значительный шаг вперед в решении неэффективности и дисбаланса в традиционных системах RAG. Использование длинных единиц извлечения и возможностей продвинутых LLM улучшает точность и эффективность задач ответов на вопросы в открытом домене. Этот инновационный фреймворк улучшает производительность извлечения и заложил основу для будущих разработок в системах retrieval-augmented generation.

Посмотрите статью и репозиторий на GitHub. Вся заслуга за это исследование принадлежит исследователям этого проекта. Также не забудьте подписаться на наш Twitter.

Присоединяйтесь к нашему Telegram-каналу и группе в LinkedIn.

Если вам нравится наша работа, вам понравится наша рассылка.

Не забудьте присоединиться к нашему сообществу 45 тыс. подписчиков в ML SubReddit.

Если вы хотите, чтобы ваша компания развивалась с помощью искусственного интеллекта (ИИ) и оставалась в числе лидеров, грамотно используйте LongRAG: A New Artificial Intelligence AI Framework that Combines RAG with Long-Context LLMs to Enhance Performance.

Проанализируйте, как ИИ может изменить вашу работу. Определите, где возможно применение автоматизации: найдите моменты, когда ваши клиенты могут извлечь выгоду из AI.

Определитесь какие ключевые показатели эффективности (KPI): вы хотите улучшить с помощью ИИ.

Подберите подходящее решение, сейчас очень много вариантов ИИ. Внедряйте ИИ решения постепенно: начните с малого проекта, анализируйте результаты и KPI.

На полученных данных и опыте расширяйте автоматизацию.

Если вам нужны советы по внедрению ИИ, пишите нам на https://t.me/itinai. Следите за новостями о ИИ в нашем Телеграм-канале t.me/itinainews или в Twitter @itinairu45358.

Попробуйте AI Sales Bot https://itinai.ru/aisales. Этот AI ассистент в продажах помогает отвечать на вопросы клиентов, генерировать контент для отдела продаж, снижать нагрузку на первую линию.

Узнайте, как ИИ может изменить ваши процессы с решениями от AI Lab itinai.ru будущее уже здесь!

«`