«`html

Natural Language Processing (NLP) в Искусственном Интеллекте

Одной из ключевых областей искусственного интеллекта является Обработка Натурального Языка (NLP). Она фокусируется на взаимодействии компьютеров и человеческого языка, разрабатывая алгоритмы и модели, позволяющие компьютерам понимать, интерпретировать и генерировать человеческий язык. Эта технология находит применение в различных областях, таких как машинный перевод, анализ настроений и поисковая информация.

Оценка длинноконтекстных языковых моделей и новый метод NOCHA

Оценка длинноконтекстных языковых моделей представляет собой вызов. Для задач, требующих понимания и генерации текста на основе обширного контекста, эти модели часто нуждаются в помощи для поддержания последовательности и точности на протяжении длинных отрывков, что может привести к потенциальным ошибкам и неэффективности в приложениях, требующих глубокого контекстного понимания.

Существующие исследования включают в себя методы оценки длинноконтекстных языковых моделей, такие как «игла в стоге сена» (NIAH). Модели, такие как GPT-4 и RULER, оцениваются с использованием этих методов. Однако эти методы обычно включают синтетические задачи, которые могут не иметь сложности реального мира. Бенчмарки, такие как NIAH и его варианты, часто не могут полностью передать тонкости повествовательного текста, часто не справляясь с глобальными задачами рассуждения. Синтетический характер текущих методов оценки ограничивает их эффективность в оценке истинного понимания языка.

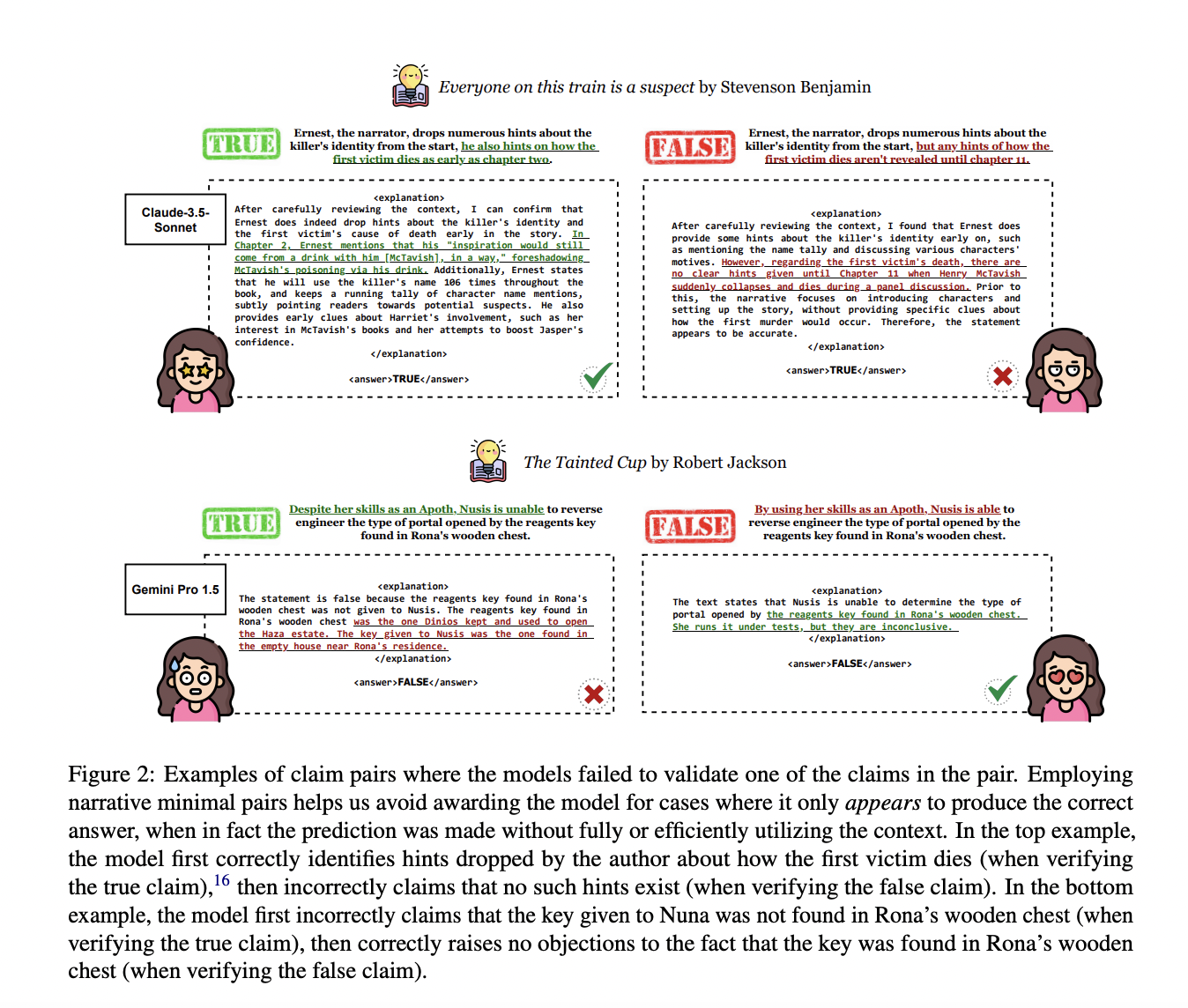

Исследователи из Университета Массачусетса в Амхерсте, Института Аллена по искусственному интеллекту и Принстонского университета представили новую методологию оценки под названием NOCHA (Narrative Open-Contextualized Human Annotation). Этот подход разработан для более точной оценки производительности длинноконтекстных языковых моделей. NOCHA включает в себя сбор минимальных пар повествовательных утверждений, где одно утверждение верно, а другое ложно, написанных читателями книг.

Методология NOCHA включает в себя сбор минимальных пар повествовательных утверждений из недавно опубликованных художественных книг. Аннотаторы, знакомые с этими книгами, генерируют пары истинных и ложных утверждений на основе содержания. Этот набор данных включает 1,001 пару, полученную из 67 книг, используемых для оценки моделей, таких как GPT-4 и RULER. Каждая модель получает эти утверждения и весь контент книги для проверки утверждений. Этот процесс гарантирует, что модели тестируются на реалистичных, контекстно насыщенных сценариях. Сбор данных и контроль качества включают в себя множество аннотаторов и обширные обзоры для поддержания высокой точности при проверке утверждений.

Исследование продемонстрировало, что текущие длинноконтекстные языковые модели, включая GPT-4 и его варианты, достигают различных уровней точности. Например, GPT-4 достиг точности 76.7% на сбалансированных данных, но только 55.8%, когда требуется правильное использование контекста. Этот результат указывает на значительную разницу между производительностью человека и модели, подчеркивая необходимость дальнейших усовершенствований.

Производительность этих моделей была оценена по различным метрикам, включая их способность точно проверять утверждения о содержании книг. Человеческие читатели достигли точности проверки утверждений 96.9%, значительно превышающей производительность лучшей модели. Этот результат подчеркивает трудности моделей с задачами, требующими глобального рассуждения на протяжении расширенных контекстов, а не простого извлечения на уровне предложения.

В заключение, исследование выявляет значительные вызовы в оценке длинноконтекстных языковых моделей и представляет новую методологию для решения этих проблем. Подход NOCHA предлагает более реалистичную и строгую рамку для тестирования этих моделей, предоставляя ценные исследования их сильных и слабых сторон. Эта работа подчеркивает важность разработки более сложных методов оценки для развития области NLP.

Проверьте статью, GitHub и рейтинг. Вся заслуга за это исследование принадлежит его ученым. Также не забудьте подписаться на наш Twitter.

Присоединяйтесь к нашему каналу в Telegram и группе в LinkedIn.

Если вам понравилась наша работа, вам понравится и наш новостной бюллетень.

Не забудьте присоединиться к нашему подразделению ML на Reddit.

Оцените AI Sales Bot здесь. Этот AI-ассистент в продажах поможет вам отвечать на вопросы клиентов, генерировать контент для отдела продаж и снижать нагрузку на первую линию.

Узнайте, как ИИ может изменить ваши процессы с решениями от AI Lab itinai.ru. Будущее уже здесь!

«`