«`html

Большие языковые модели (LLM)

Большие языковые модели (LLM) продемонстрировали впечатляющие возможности в различных задачах, но их стоимость и способности сильно различаются. Развертывание этих моделей в реальных приложениях представляет существенную сложность: направление всех запросов к наиболее способным моделям обеспечивает высокое качество ответов, но является дорогостоящим, в то время как направление запросов к более маленьким моделям экономит затраты за счет качества ответов. Исследователи из UC Berkeley, Anyscale и Canva предлагают RouteLLM, открытую систему маршрутизации LLM, которая эффективно балансирует цену и производительность для решения этой проблемы.

Проблемы в маршрутизации LLM

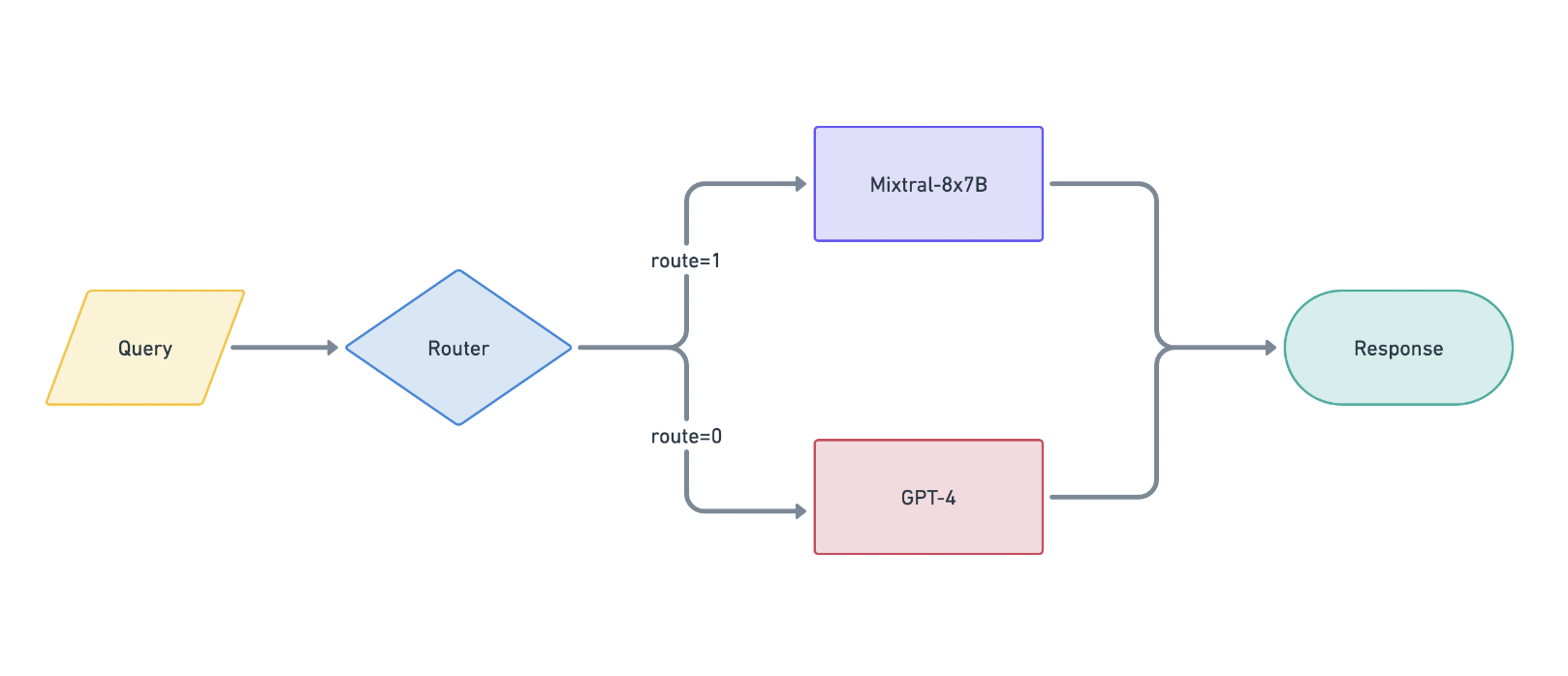

Маршрутизация LLM направлена на определение того, какая модель должна обрабатывать каждый запрос для минимизации затрат при сохранении качества ответов. Система маршрутизации должна выявлять характеристики входящих запросов и способности различных моделей, что делает проблему сложной. RouteLLM решает эту проблему, используя данные предпочтений для обучения своих маршрутизаторов, позволяя системе узнавать, какие запросы могут быть обработаны более слабыми моделями, а какие требуют более сильных моделей.

Фреймворк и методология

RouteLLM формализует проблему маршрутизации LLM и исследует методы улучшения производительности маршрутизатора. Фреймворк использует общедоступные данные из Chatbot Arena и включает новые методы обучения. Было обучено четыре различных маршрутизатора:

- Маршрутизатор ранжирования с взвешенной схожестью (SW): выполняет «взвешенный расчет Эло» на основе сходства.

- Модель факторизации матрицы: изучает функцию оценки того, насколько хорошо модель может ответить на запрос.

- Классификатор BERT: предсказывает, какая модель может предоставить лучший ответ.

- Классификатор причинной LLM: также предсказывает, какая модель может предоставить лучший ответ.

Производительность и экономическая эффективность

Производительность этих маршрутизаторов была оценена на бенчмарках, таких как MT Bench, MMLU и GSM8K. Результаты показали, что маршрутизаторы могут значительно снизить затраты без ущерба для качества. Например, на MT Bench маршрутизатор факторизации матрицы достиг 95% производительности GPT-4, сделав всего 26% вызовов к GPT-4, что привело к сокращению затрат на 48% по сравнению с случайным базовым уровнем.

Сравнение с коммерческими предложениями

Производительность RouteLLM была сравнена с коммерческими системами маршрутизации, такими как Martian и Unify AI. Используя GPT-4 Turbo в качестве сильной модели и Llama 2 70B или Mixtral 8x7B в качестве слабой модели, RouteLLM достигла схожей производительности, при этом стоимость была на 40% ниже. Это подчеркивает экономическую эффективность и конкурентное преимущество фреймворка RouteLLM.

Обобщение на другие модели

Для демонстрации его универсальности, RouteLLM был протестирован с различными парами моделей, такими как Claude 3 Opus и Llama 3 8B. Маршрутизаторы показали сильную производительность без повторного обучения, что указывает на то, что они усвоили общие характеристики, которые помогают различать между сильными и слабыми моделями, применимые к новым парам моделей.

Заключение

RouteLLM предоставляет масштабное и экономически эффективное решение для развертывания LLM путем эффективного балансирования стоимости и производительности. Использование предпочтительных данных и методов увеличения данных обеспечивает высококачественные ответы при значительном снижении затрат — открытый релиз RouteLLM, вместе с его наборами данных и кодом.

Проверьте статью, GitHub и детали. Вся заслуга за это исследование принадлежит исследователям этого проекта. Также не забудьте подписаться на нас в Twitter.

Присоединяйтесь к нашему Telegram-каналу и группе LinkedIn.

Если вам нравится наша работа, вам понравится наша рассылка.

Не забудьте присоединиться к нашему 45 тыс. подписчиков на ML SubReddit.

Источник: MarkTechPost

«`