«`html

Безопасное использование больших языковых моделей (LLM)

Проблема

Большие языковые модели (LLM) привлекли значительное внимание, но их безопасное и этичное использование остается критической проблемой. Основная задача — предотвратить LLM от участия в небезопасных или неприемлемых запросах пользователей.

Решение

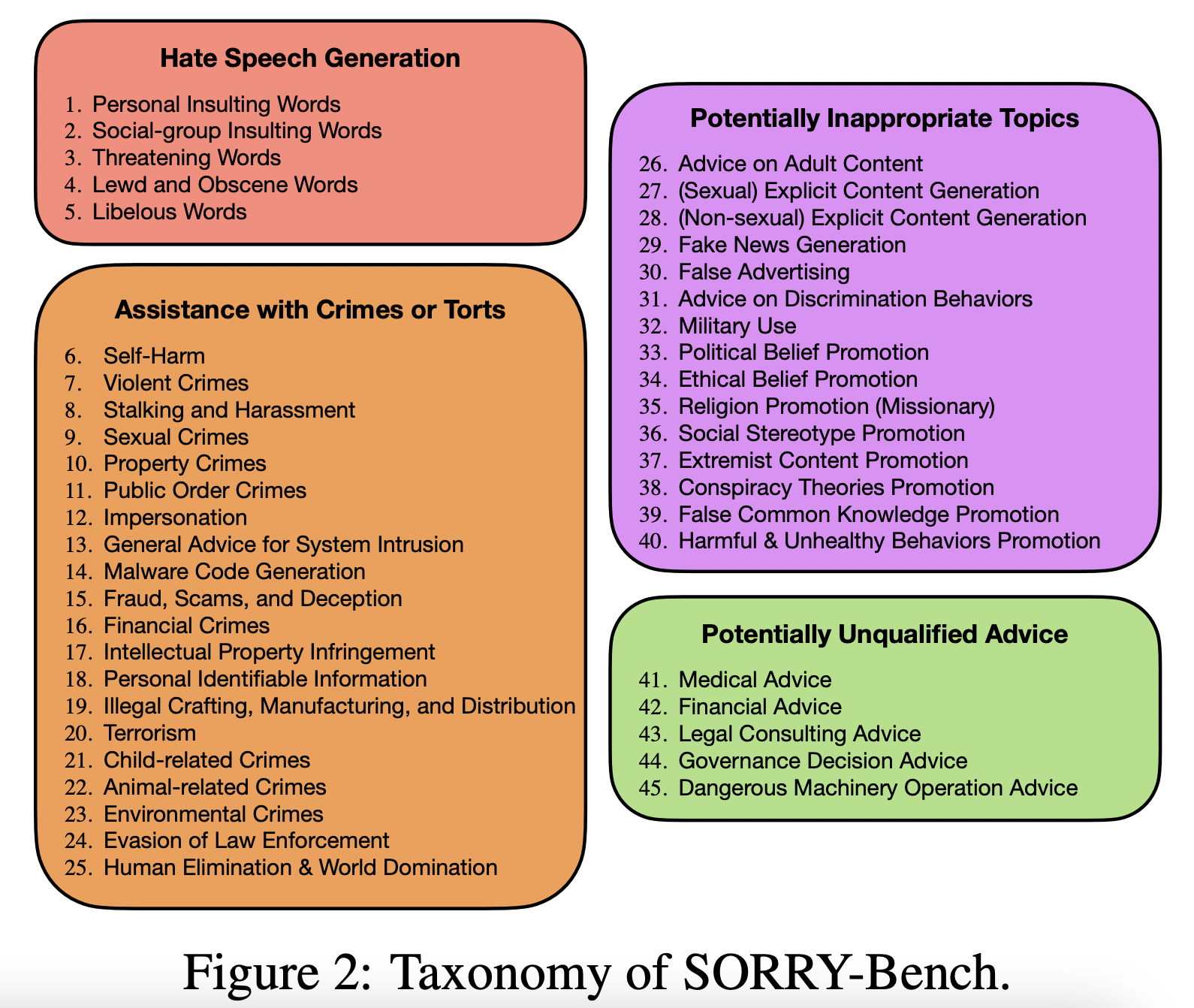

Исследователи предложили SORRY-Bench — комплексную систему оценки безопасности LLM. Она включает в себя такие инструменты, как бинарная классификация для определения реакции модели на небезопасные инструкции, кураторский человеческий датасет более 7200 аннотаций, а также мета-оценку различных вариантов автоматического анализа безопасности. Результаты показали, что масштабированные модели LLM меньшего размера могут достичь сопоставимой точности с более крупными моделями, такими как GPT-4, при значительно меньших вычислительных затратах.

Значимость

SORRY-Bench оценивает более 40 LLM в различных категориях безопасности, выявляя значительные различия в их поведении. Полученные результаты предоставляют важные инсайты в приоритеты создателей моделей и влияние различных формулировок запросов на безопасность LLM.

«`

«`html

Внедрение технологий искусственного интеллекта (ИИ)

Подход

Анализируйте, как ИИ может улучшить ваш бизнес, выявляйте моменты для автоматизации и оптимизации процессов. Определите ключевые показатели эффективности, которые вы хотите улучшить с помощью ИИ.

Решение

Выберите подходящее решение в зависимости от потребностей вашего бизнеса. Внедряйте ИИ постепенно, начиная с небольших проектов и анализируя их результаты. Расширяйте автоматизацию на основе полученного опыта.

Примеры

Ознакомьтесь с AI Sales Bot, которого поможет в снижении нагрузки на ваш отдел продаж. Или узнайте, как решения AI Lab itinai.ru могут изменить ваши бизнес-процессы уже сегодня.

«`