«`html

Проблема производительности больших языковых моделей (LLMs) в обработке длинных контекстов

Исследование показывает, что большие языковые модели (LLMs), такие как GPT-3.5 Turbo и Mistral 7B, часто испытывают затруднения с точным извлечением информации и поддержанием способности к рассуждению при обработке обширных текстовых данных. Это ограничение снижает их эффективность в задачах, требующих обработки и рассуждения над длинными текстами, таких как мультидокументальный вопросно-ответный анализ (MDQA) и гибкий вопросно-ответный анализ (FLenQA).

Новый подход к улучшению производительности LLMs в длинных контекстах

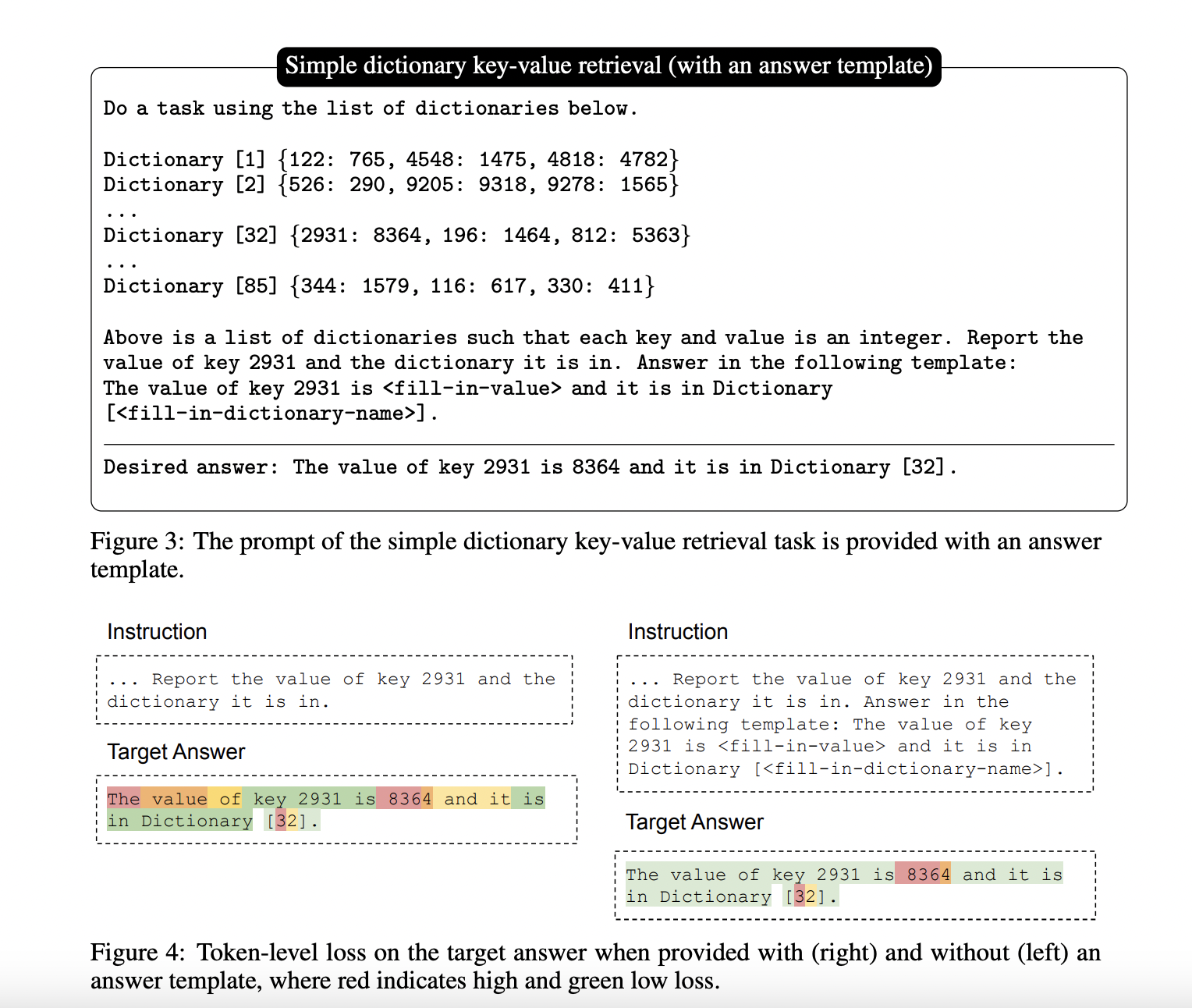

Команда исследователей из Университета Висконсин-Мэдисон предлагает новый метод обучения, используя тщательно разработанный синтетический набор данных для решения этих проблем. Этот набор данных включает в себя задачи по извлечению числовых ключей-значений, способствующие более эффективной обработке длинных контекстов LLMs. Эксперименты показывают, что этот подход значительно улучшает производительность LLMs в задачах с длинными контекстами, преодолевая «потерянный посередине» феномен и снижая примативный эффект.

Применение синтетических данных для улучшения производительности LLMs

Предложенный синтетический набор данных состоит из простых задач по извлечению ключей-значений из словарей. Финетюнинг проводится на части ответов этих задач, что позволяет модели улучшить свои навыки обработки длинных контекстов. Результаты показывают значительное улучшение производительности LLMs в задачах с длинными контекстами, а также сравнение с традиционными методами обучения на реальных данных показывает превосходство синтетического подхода.

Это исследование представляет инновационный подход к обучению LLMs с использованием синтетических данных, значительно улучшающий их производительность в длинных контекстах. Предложенный метод демонстрирует существенные улучшения по сравнению с традиционными методами обучения, преодолевая «потерянный посередине» феномен и снижая примативный эффект. Это исследование подчеркивает потенциал синтетических наборов данных в преодолении ограничений реальных данных, открывая путь к более эффективным и надежным LLMs в обработке обширной текстовой информации.

Подробнее ознакомиться с исследованием можно здесь.

«`