«`html

Исследование AI от Tenyx: Исследование возможностей рассуждения больших языковых моделей (LLMs) через их геометрическое понимание

Большие языковые модели (LLM) продемонстрировали впечатляющую производительность в различных задачах, при этом способность рассуждения является ключевым аспектом их развития. Однако основные элементы, обеспечивающие эти улучшения, остаются неясными. В настоящее время основные подходы к улучшению рассуждений включают увеличение размера модели и расширение длины контекста с помощью методов, таких как цепочка мыслей, увеличение генерации через поиск и примерные подсказки. Хотя эти методы эффективны, они представляют лишь часть потенциальных путей улучшения и часто приводят к увеличению вычислительных затрат и задержке вывода в реальных приложениях.

Практические решения и ценность:

Исследователи из Tenyx представляют это исследование, чтобы исследовать геометрию слоев трансформаторов в LLM, сосредотачиваясь на ключевых свойствах, связанных с их выразительной силой. Исследование выявляет два критических фактора: плотность взаимодействия токенов в многоголовом внимании (MHA), которая отражает сложность представления функций, достижимую последующим многослойным перцептроном (MLP), и связь между увеличением размера модели и длиной контекста с более высокой плотностью внимания и улучшением рассуждений.

Исследование анализирует способности рассуждения LLM через геометрический анализ, сосредотачиваясь на том, как увеличенные области, индуцированные многослойным перцептроном, влияют на рассуждения. Эксперименты с вопросно-ответными парами и случайными токенами показывают, что, хотя добавление токенов увеличивает внутреннюю размерность на первом уровне, улучшенные рассуждения коррелируют с увеличением внутренней размерности на последнем уровне.

Исследование также выявляет сильную корреляцию между внутренней размерностью последних уровней и правильностью ответов, независимо от размера модели. Эксперименты показывают, что увеличение контекста в подсказках может увеличить внутреннюю размерность, особенно когда контекст соответствует вопросу.

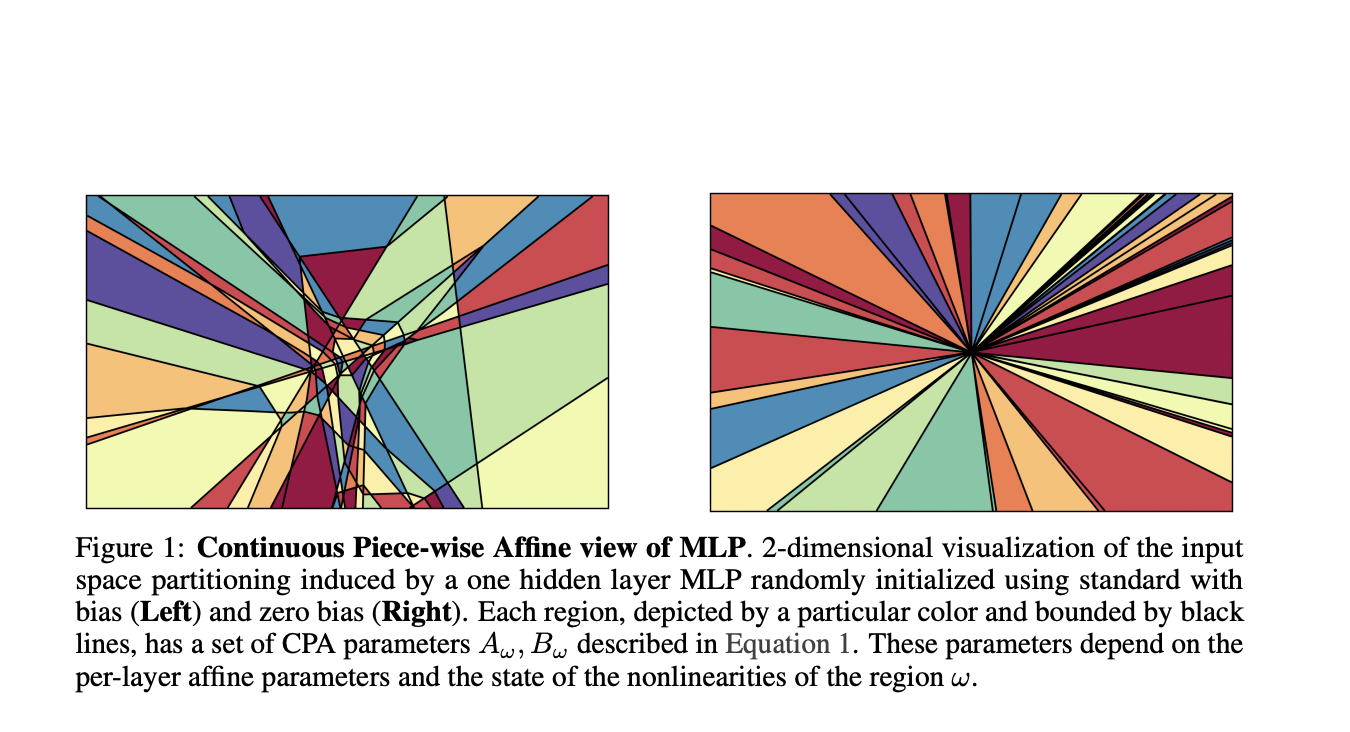

Это исследование подчеркивает важность разбиения входного пространства, вызванного многослойными перцептронами в нейронных сетях и LLM. Адаптивное разбиение играет решающую роль в их способности к аппроксимации функций, исследование демонстрирует, как взаимодействие между аппроксимацией и количеством областей влияет на возможности аппроксимации функций LLM.

Подробнее ознакомиться с исследованием можно по ссылке [ссылка на исследование]. Все права на это исследование принадлежат исследователям проекта. Также не забудьте подписаться на наш Твиттер и присоединиться к нашей группе в LinkedIn для получения обновлений.

Если вас интересует партнерство в области продвижения (контент/реклама/новостная рассылка), заполните [форму].

«`