«`html

Исследователи из Стэнфордского университета и Университета Буффало представили инновационные методы искусственного интеллекта для улучшения качества запоминания в рекуррентных языковых моделях с помощью JRT-Prompt и JRT-RNN

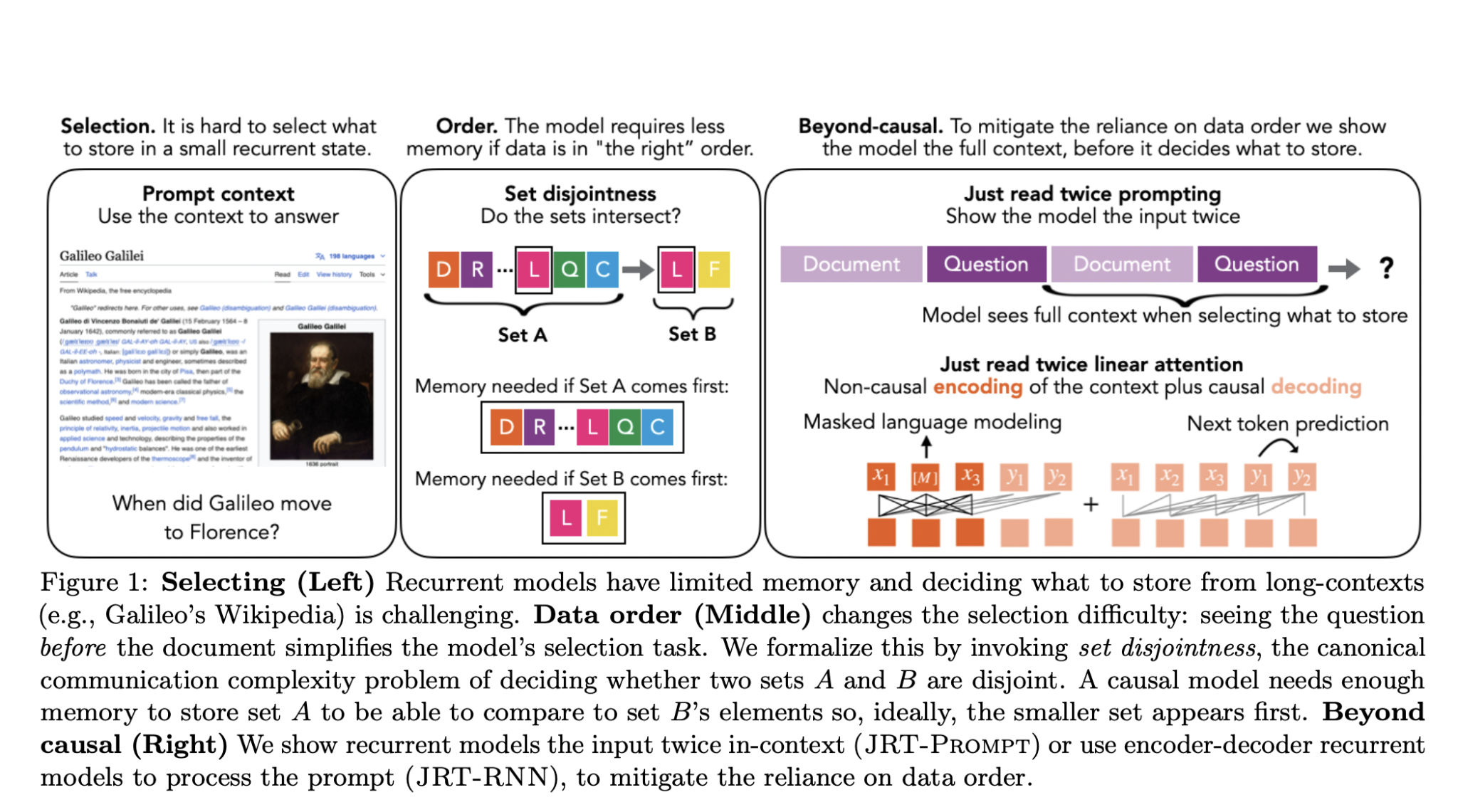

Моделирование языка значительно продвинулось в разработке алгоритмов для понимания, генерации и манипулирования человеческим языком. Эти достижения привели к созданию больших языковых моделей, способных выполнять задачи перевода, сжатия и вопросно-ответной обработки. Они являются ключевыми для обработки естественного языка (NLP) и приложений искусственного интеллекта (AI). Однако, несмотря на свои возможности, эти модели сталкиваются с значительными вызовами, особенно в воспроизведении информации в расширенных контекстах. Это ограничение особенно заметно в рекуррентных языковых моделях, которым часто требуется помощь в эффективном хранении и извлечении необходимой информации для точного контекстного обучения. В результате их производительность должна догнать модели с неограниченной памятью.

JRT-Prompt

JRT-Prompt улучшает рекуррентные модели путем многократного повторения контекста в подсказках для улучшения запоминания, в то время как JRT-RNN использует не-причинную рекуррентную архитектуру для улучшения обработки контекста. Эти методы направлены на уменьшение зависимости от порядка представления данных, тем самым улучшая способность моделей запоминать и эффективно использовать информацию.

Результаты

JRT-Prompt достиг значительного улучшения производительности на различных задачах и моделях, обеспечивая более высокую пропускную способность по сравнению с FlashAttention-2 для предварительного заполнения (длина 32k, размер пакета 16, NVidia H100). JRT-RNN показал улучшение качества до 13,7 пункта при 360 миллионах параметров и до 6,9 пункта при 1,3 миллиардах параметров, а также более высокую пропускную способность в 19,2 раза. Это демонстрирует, что предложенные методы могут соответствовать или превзойти производительность традиционных моделей Transformer, используя меньше памяти.

Заключение

Это исследование решает критическую проблему воспроизведения информации в рекуррентных языковых моделях и представляет эффективные методы для ее устранения. JRT-Prompt и JRT-RNN предлагают многообещающие решения, улучшающие качество и эффективность языковых моделей. Эти достижения представляют собой значительный шаг в развитии более эффективных и способных техник моделирования языка.

Подробнее о исследовании можно узнать здесь.

Вся заслуга за это исследование принадлежит исследователям этого проекта. Также не забудьте подписаться на наш Twitter.

Присоединяйтесь к нашему каналу в Telegram и группе в LinkedIn.

Если вам нравится наша работа, вам понравится наша рассылка.

Не забудьте присоединиться к нашему сообществу в Reddit.