«`html

Решение для оценки неопределенности и улучшения калибровки в глубоком обучении при сдвиге распределения

Исследование сосредотачивается на разработке моделей, которые точно предсказывают результаты и количественно оценивают неопределенность, связанную с этими прогнозами. Это особенно важно в таких областях, как здравоохранение, медицинское изображение и автономное вождение, где решения на основе выводов моделей могут иметь глубокие последствия. Точная оценка неопределенности помогает оценить риск, связанный с использованием прогнозов модели, определяя, когда можно доверять решению модели и когда его нужно переопределить, что критически важно для безопасного применения в реальных сценариях.

Проблема и решение

Традиционные методы оценки неопределенности в моделях машинного обучения часто полагаются на байесовские принципы, что включает в себя определение априорного распределения и выбор из апостериорного распределения. Однако эти методы сталкиваются с существенными вызовами в современном глубоком обучении из-за сложности в определении подходящих априорных распределений и проблем масштабируемости байесовских подходов. Текущие подходы к оценке неопределенности включают различные байесовские методы и принцип минимальной длины описания (MDL). Хотя эти методы теоретически обоснованы, они требуют значительных вычислительных ресурсов и сталкиваются с вызовами в определении подходящих априорных распределений для сложных моделей.

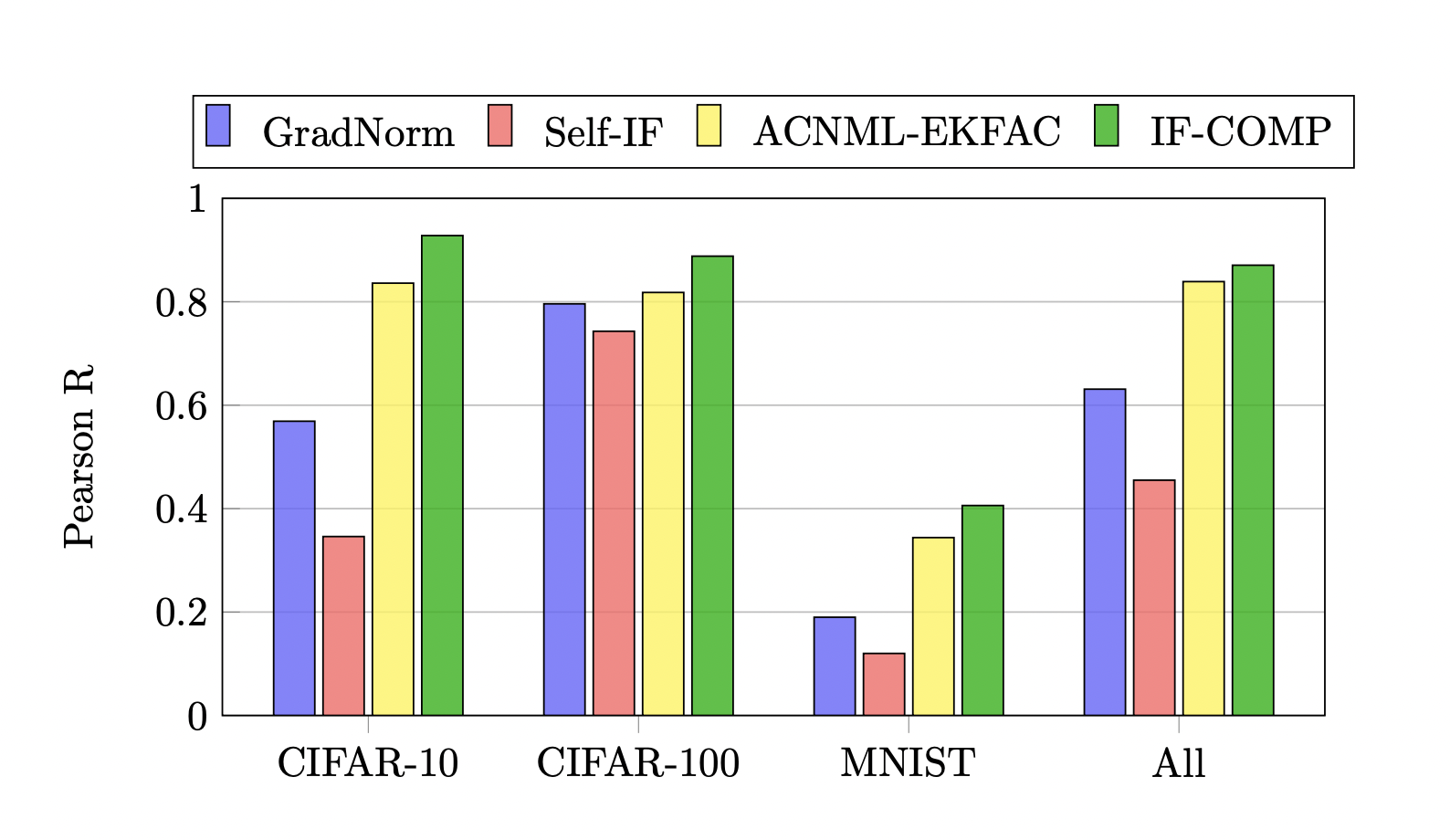

Исследователи из Массачусетского технологического института, Университета Торонто и Института векторного искусственного интеллекта представили IF-COMP, масштабируемое и эффективное приближение распределения pNML. Этот метод использует функцию влияния Больцмана с масштабированием температуры для линеаризации модели, что позволяет получать хорошо калиброванные прогнозы и измерять сложность в размеченных и неразмеченных ситуациях. IF-COMP регуляризует ответ модели на дополнительные точки данных, применяя близкий к целевому объекту метод, который наказывает движение в функциональном и весовом пространстве.

Результаты и преимущества

Экспериментальная проверка IF-COMP показала его превосходство над сильными базовыми методами в задачах калибровки неопределенности, обнаружения ошибок разметки и обнаружения данных вне распределения. IF-COMP продемонстрировал значительные улучшения по сравнению с существующими методами в различных задачах, что подчеркивает его потенциал для повышения надежности и безопасности моделей машинного обучения в реальных приложениях.

В заключение, метод IF-COMP значительно продвигает оценку неопределенности для глубоких нейронных сетей. Его эффективность в различных задачах подчеркивает потенциал для улучшения надежности и безопасности моделей машинного обучения в реальных приложениях.

Подробнее о исследовании можно узнать здесь.

Все заслуги за это исследование принадлежат исследователям проекта.

Следите за нами в Twitter.

Присоединяйтесь к нашему Telegram-каналу и группе LinkedIn.

Если вам нравится наша работа, вам понравится наша рассылка.

Не забудьте присоединиться к нашему SubReddit.

«`