«`html

Решение для улучшения работы с помощью искусственного интеллекта (ИИ)

Одной из центральных проблем моделей с расширенным поиском и генерацией (RAG) является эффективное управление длинными контекстными входами. Модели RAG улучшают большие языковые модели (LLM), интегрируя внешнюю информацию, но это значительно увеличивает длину ввода, что приводит к увеличению времени декодирования. Эта проблема критически влияет на опыт пользователя, особенно в реальном времени, таких как сложные системы вопросов и ответов и поисковые задачи большого масштаба. Решение этой проблемы критично для развития исследований в области ИИ, так как делает LLM более практичными и эффективными для реальных приложений.

Новое решение COCOM

Команда исследователей из Университета Амстердама, Университета Квинсленда и Naver Labs Europe представляют COCOM (COntext COmpression Model) — новый и эффективный метод сжатия контекста, который преодолевает ограничения существующих техник. COCOM сжимает длинные контексты в небольшое количество контекстных вложений, значительно ускоряя время генерации при сохранении высокой производительности. Этот метод предлагает различные уровни сжатия, обеспечивая баланс между временем декодирования и качеством ответа. Инновация заключается в его способности эффективно обрабатывать несколько контекстов, в отличие от предыдущих методов, которые испытывали трудности с многодокументными контекстами. Используя одну модель как для сжатия контекста, так и для генерации ответа, COCOM демонстрирует существенные улучшения в скорости и производительности, обеспечивая более эффективное и точное решение по сравнению с существующими методами.

Технические аспекты COCOM

COCOM включает сжатие контекстов в набор контекстных вложений, что значительно уменьшает размер ввода для LLM. Метод включает предварительное обучение задач, таких как авто-кодирование и языковое моделирование из контекстных вложений. Для обучения используются различные наборы данных вопросов и ответов, такие как Natural Questions, MS MARCO, HotpotQA, WikiQA и другие. Оценочные метрики сосредоточены на точном совпадении (EM) и оценочных баллах (M) для оценки эффективности сгенерированных ответов. Ключевые технические аспекты включают параметрическую настройку LoRA и использование SPLADE-v3 для поиска.

Результаты и преимущества COCOM

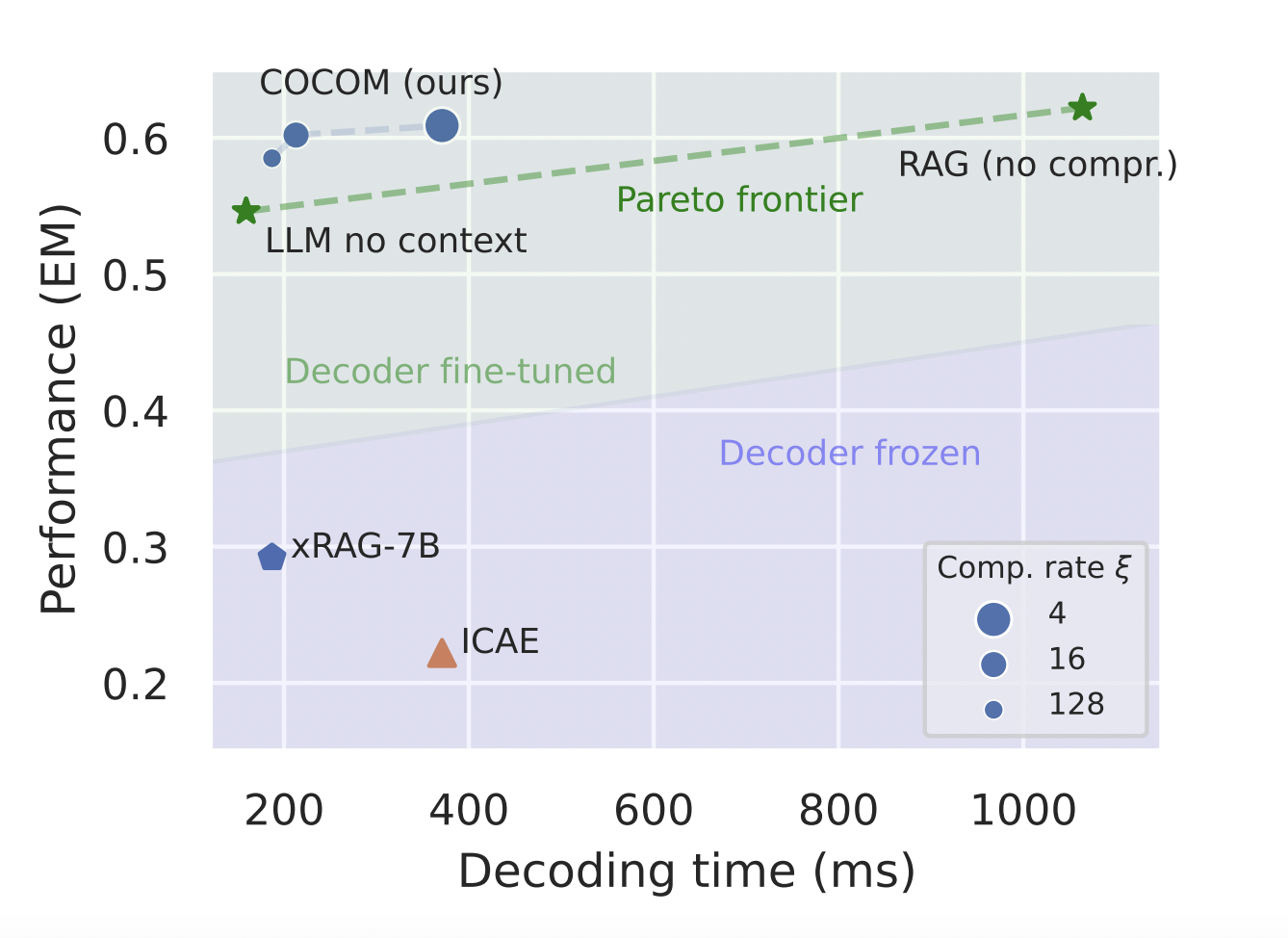

COCOM достигает значительных улучшений в эффективности декодирования и производительности. Он демонстрирует ускорение времени декодирования до 5,69 раз, сохраняя высокую производительность по сравнению с существующими методами сжатия контекста. Например, COCOM достиг EM-оценки 0,554 на наборе данных Natural Questions при коэффициенте сжатия 4 и 0,859 на TriviaQA, превосходя другие методы, такие как AutoCompressor, ICAE и xRAG. Эти улучшения подчеркивают превосходную способность COCOM более эффективно обрабатывать более длинные контексты, сохраняя высокое качество ответов, демонстрируя эффективность и надежность метода на различных наборах данных.

Заключение

COCOM представляет собой значительное достижение в сжатии контекста для моделей RAG, уменьшая время декодирования и сохраняя высокую производительность. Его способность обрабатывать несколько контекстов и предлагать адаптивные уровни сжатия делает его критическим развитием для улучшения масштабируемости и эффективности систем RAG. Это новшество имеет потенциал значительно улучшить практическое применение LLM в реальных сценариях, преодолевая критические проблемы и открывая путь к более эффективным и отзывчивым приложениям ИИ.

Подробнее о статье можно узнать здесь. Вся заслуга за это исследование принадлежит исследователям этого проекта. Также не забудьте подписаться на наш Twitter.

Присоединяйтесь к нашему каналу в Telegram и группе в LinkedIn.

Если вам понравилась наша работа, вам понравится наша рассылка.

Не забудьте присоединиться к нашему сообществу в Reddit.

Источник: MarkTechPost.

Применение ИИ в вашем бизнесе

Если вы хотите, чтобы ваша компания развивалась с помощью искусственного интеллекта (ИИ) и оставалась в числе лидеров, грамотно используйте COCOM: An Effective Context Compression Method that Revolutionizes Context Embeddings for Efficient Answer Generation in RAG.

Проанализируйте, как ИИ может изменить вашу работу. Определите, где возможно применение автоматизации: найдите моменты, когда ваши клиенты могут извлечь выгоду из AI.

Определитесь какие ключевые показатели эффективности (KPI): вы хотите улучшить с помощью ИИ.

Подберите подходящее решение, сейчас очень много вариантов ИИ. Внедряйте ИИ решения постепенно: начните с малого проекта, анализируйте результаты и KPI.

На полученных данных и опыте расширяйте автоматизацию.

Если вам нужны советы по внедрению ИИ, пишите нам на Telegram. Следите за новостями о ИИ в нашем Телеграм-канале t.me/itinainews или в Twitter Twitter.

Попробуйте AI Sales Bot itinai.ru/aisales. Этот AI ассистент в продажах помогает отвечать на вопросы клиентов, генерировать контент для отдела продаж, снижать нагрузку на первую линию.

Узнайте, как ИИ может изменить ваши процессы с решениями от AI Lab itinai.ru. Будущее уже здесь!

«`