«`html

Hugging Face представляет SmolLM: трансформация встроенного ИИ с высокопроизводительными небольшими языковыми моделями от 135M до 1.7B параметров

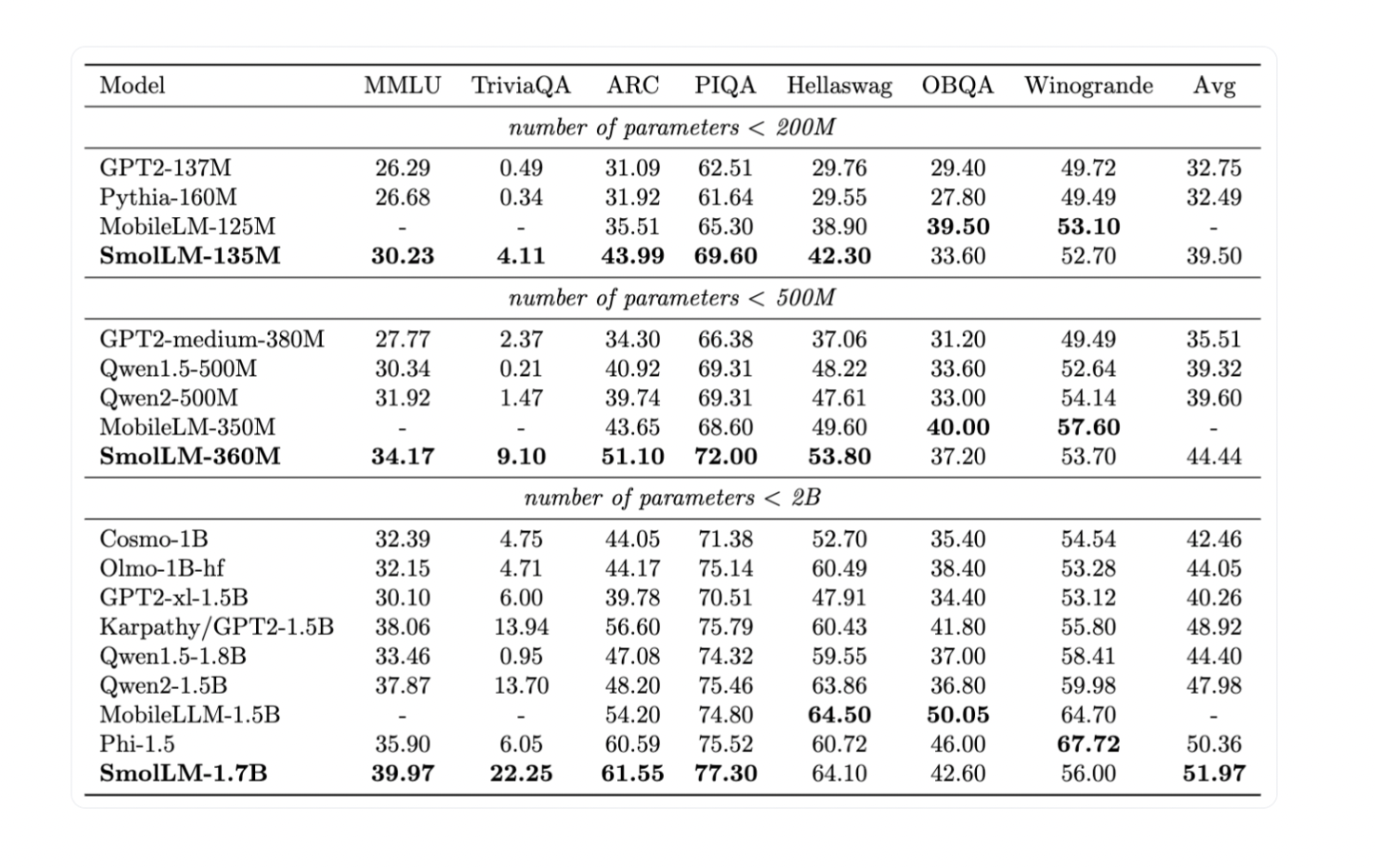

Hugging Face недавно выпустила SmolLM, семейство передовых небольших моделей, разработанных для обеспечения мощной производительности в компактной форме. Модели SmolLM доступны в трех размерах: 135M, 360M и 1.7B параметров, что делает их подходящими для различных приложений при сохранении эффективности и производительности.

Практические решения и ценность

Модели SmolLM обеспечивают высокую производительность с низкими вычислительными затратами и улучшенной конфиденциальностью пользователей. Они обучены на тщательно отобранном высококачественном наборе данных SmolLM-Corpus, включающем различные образовательные и синтетические источники данных.

Модели SmolLM построены на наборе данных SmolLM-Corpus, включающем такие высококачественные источники, как Cosmopedia v2, Python-Edu и FineWeb-Edu. Например, Cosmopedia v2 представляет собой улучшенную версию синтетического набора данных, включающего более 30 миллионов учебников, блогов и историй.

Модели SmolLM успешно прошли оценку по бенчмаркам, продемонстрировав впечатляющую производительность и превзойдя конкурентов в своих размерных категориях.

Одним из значительных преимуществ моделей SmolLM является их способность эффективно работать на различных аппаратных конфигурациях, включая смартфоны и ноутбуки.

Hugging Face также выпустила веб-демонстрации WebGPU для моделей SmolLM-135M и SmolLM-360M, демонстрирующие их возможности и простоту использования.

Заключение

Hugging Face успешно доказала, что высокопроизводительные модели можно достичь с помощью эффективного обучения на высококачественных наборах данных, обеспечивая крепкое соотношение между размером модели и производительностью. Модели SmolLM готовы изменить ландшафт небольших языковых моделей, предлагая мощные и эффективные решения для различных приложений.

Проверьте модели и подробности. Все заслуги за эту работу принадлежат исследователям этого проекта. Также не забудьте подписаться на наш Twitter.

Присоединяйтесь к нашему Telegram-каналу и LinkedIn-группе.

Если вам нравится наша работа, вам понравится наша рассылка.

Не забудьте присоединиться к нашему субреддиту ML с более чем 46 тыс. подписчиков.

Исходный пост: Hugging Face Introduces SmolLM: Transforming On-Device AI with High-Performance Small Language Models from 135M to 1.7B Parameters

«`