«`html

Make-An-Agent: Новый генератор параметров политики, использующий силу условных диффузионных моделей для генерации поведения-политики

Традиционное обучение политике использует выборочные траектории из буфера воспроизведения или демонстрации поведения для обучения политик или моделей траекторий, отображающих состояние в действие. Однако существует вызов в направлении генерации высокоразмерного вывода с использованием низкоразмерных демонстраций. Диффузионные модели показали высокую конкурентоспособность в задачах, таких как синтез текста в изображение. Этот успех поддерживает работу по генерации сети политики как условного процесса денойзинга диффузии. Улучивая шум в структурированные параметры последовательно, генератор на основе диффузии может обнаружить различные политики с превосходной производительностью и устойчивым пространством параметров политики.

Существующие методы в этой области включают генерацию параметров и обучение для обучения политике. Генерация параметров была значительной фокусной точкой исследований с момента появления гиперсетей, что привело к различным исследованиям предсказания весов нейронной сети. Например, Hypertransformer использует трансформеры для генерации весов для каждого слоя сверточных нейронных сетей (CNN) на основе образцов задач, используя обучение с учителем и полу-обучение. С другой стороны, обучение для обучения политике включает мета-обучение, которое направлено на разработку политики, способной адаптироваться к любой новой задаче в пределах заданного распределения задач. В процессе мета-обучения или мета-тестирования предыдущие методы мета-усиления обучения (meta-RL) полагаются на вознаграждения для адаптации политики.

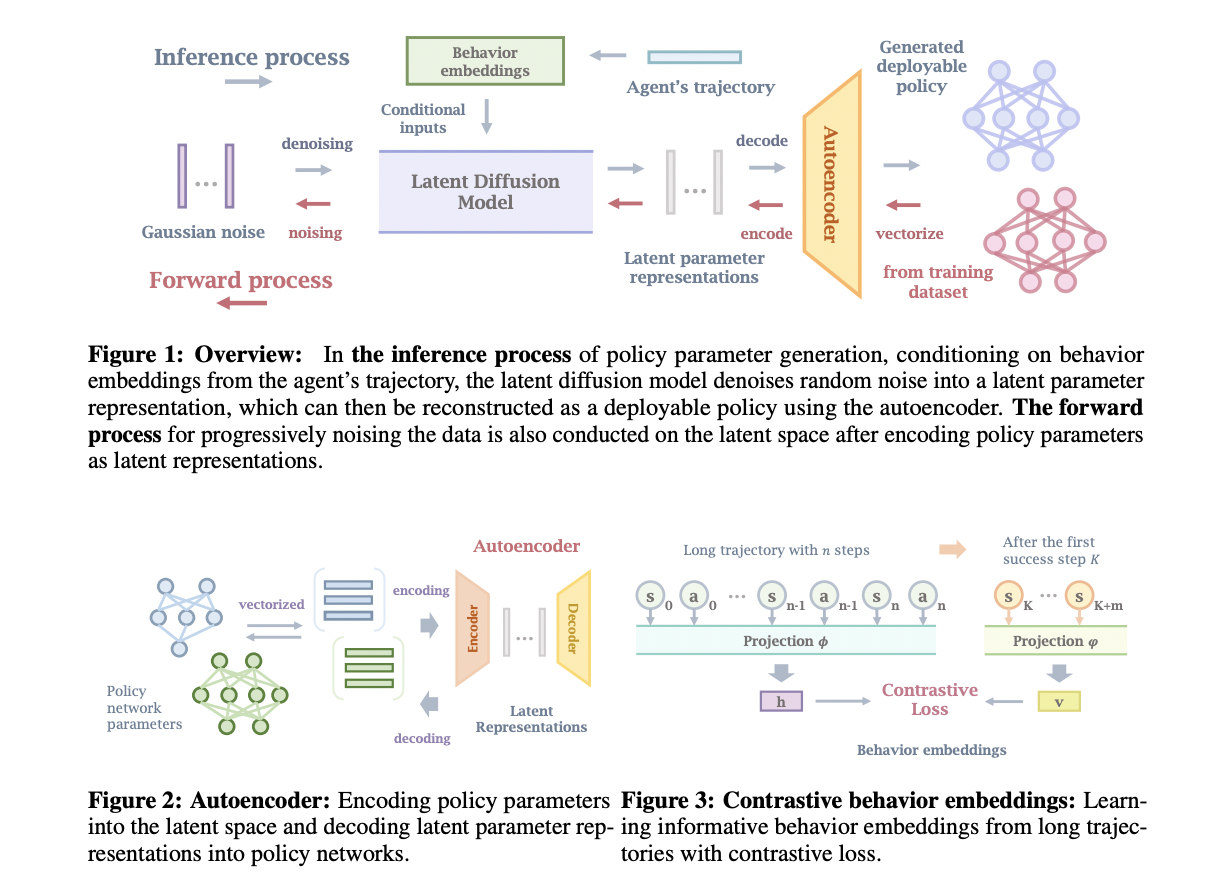

Исследователи из Университета Мэриленда, Университета Цинхуа, Университета Калифорнии, Шанхайского института Ци Чжи и Шанхайской лаборатории ИИ предложили Make-An-Agent, новый метод для генерации политик с использованием условных диффузионных моделей. В этом процессе разрабатывается автоэнкодер для сжатия сетей политики в более маленькие латентные представления на основе их слоя. Исследователи использовали контрастное обучение для установления связи между долгосрочными траекториями и их результатами или будущими состояниями. Кроме того, для генерации параметров политики используется эффективная модель диффузии на основе изученных вложений поведения, которые затем декодируются в используемые политики с помощью предварительно обученного декодера.

Производительность Make-An-Agent оценивается путем тестирования в трех областях непрерывного управления, включая различные задачи манипулирования на столе и задачи реального перемещения. Политики были сгенерированы в процессе тестирования с использованием траекторий из буфера воспроизведения частично обученных агентов RL. Сгенерированные политики превзошли те, которые были созданы с помощью многозадачного или мета-обучения и других методов на основе гиперсетей. Этот подход имеет потенциал для производства разнообразных параметров политики и показывает сильную производительность, несмотря на окружающую случайность как в симуляторах, так и в реальных ситуациях. Более того, Make-An-Agent может производить высокопроизводительные политики даже при наличии шумных траекторий, демонстрируя устойчивость модели.

Политики, сгенерированные Make-An-Agent в реальных сценариях, тестируются с использованием техники «идти-такими-путями» и обучаются на IsaacGym. Сети актеров генерируются с использованием предложенного метода на основе траекторий из симуляций IsaacGym и предварительно обученных модулей адаптации. Эти сгенерированные политики затем развертываются на реальных роботах в средах, отличных от симуляций. Каждая политика для перемещения в реальном мире включает 50 956 параметров, и для каждой задачи в MetaWorld и Robosuite собирается 1 500 сетей политики. Эти сети происходят из точек контроля политики во время обучения SAC и сохраняются каждые 5 000 шагов обучения после достижения успешной ставки теста 1.

В этой статье исследователи представляют новый метод генерации политики под названием Make-An-Agent, основанный на условных диффузионных моделях. Этот метод направлен на генерацию политик в пространствах с большим количеством параметров с использованием автоэнкодера для кодирования и восстановления этих параметров. Результаты, протестированные в различных областях, показывают, что их подход хорошо работает в многозадачных средах, способен обрабатывать новые задачи и устойчив к окружающей случайности. Однако из-за большого количества параметров не исследуются более разнообразные сети политики, и возможности генератора диффузии параметров ограничены автоэнкодером параметров, поэтому будущие исследования могут рассмотреть более гибкие способы генерации параметров.

Проверьте статью. Вся заслуга за это исследование принадлежит исследователям этого проекта. Также не забудьте подписаться на нас в Twitter.

Присоединяйтесь к нашему Telegram-каналу и группе LinkedIn.

Если вам нравится наша работа, вам понравится наша рассылка.

Не забудьте присоединиться к нашему 46 тыс. подписчиков ML SubReddit.

Пост Make-An-Agent: Новый генератор параметров политики, использующий силу условных диффузионных моделей для генерации поведения-политики появился сначала на MarkTechPost.

«`