«`html

Расширение возможностей языковых моделей с помощью EM-LLM

Большие языковые модели (LLM) имеют ограничения в обработке длинных контекстов из-за архитектур на основе трансформеров. Однако исследователи из Huawei Noah’s Ark Lab и University College London разработали уникальную архитектуру EM-LLM, которая интегрирует эпизодическую память в LLM на основе трансформеров. Это позволяет модели обрабатывать значительно более длинные контексты, улучшая производительность на задачах, требующих сложного временного рассуждения.

Практические применения EM-LLM

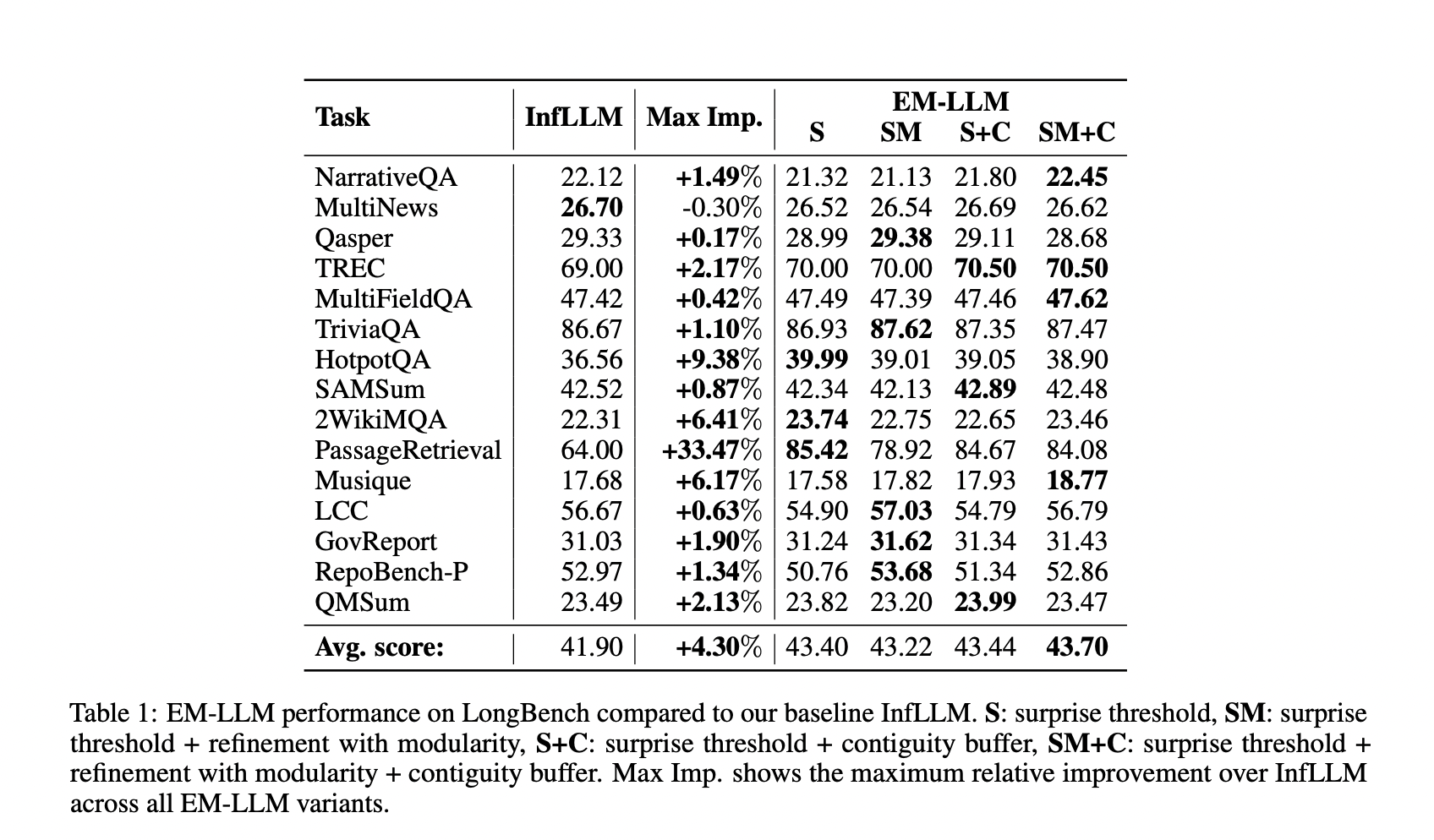

EM-LLM позволяет обрабатывать информацию за пределами предварительно обученного контекста, что открывает новые возможности для решения задач с длинными контекстами. Модель продемонстрировала улучшенную производительность на задачах с длинными контекстами, превосходя базовую модель InfLLM на различных наборах данных. Она также показала значительное улучшение на задачах поиска и извлечения информации, что подчеркивает ее способность к эффективному извлечению детальной информации из больших контекстов и выполнению сложных рассуждений.

EM-LLM представляет собой значительное достижение в области языковых моделей с расширенными возможностями обработки контекста. Интеграция человеческой эпизодической памяти и когнитивных событий в LLM на основе трансформеров позволяет модели эффективно обрабатывать информацию из значительно более длинных контекстов без предварительного обучения.

Преимущества использования EM-LLM

EM-LLM предлагает путь к практически бесконечным контекстным окнам, потенциально революционизируя взаимодействие LLM с непрерывными, персонализированными обменами. Эта гибкая архитектура служит альтернативой традиционным техникам RAG и предоставляет масштабную вычислительную модель для проверки гипотез человеческой памяти.

EM-LLM не только улучшает производительность LLM, но и вдохновляет на дальнейшие исследования в области взаимодействия LLM и механизмов человеческой памяти.

Ссылки и контакты

Подробнее о проекте можно узнать из этой статьи. Следите за нашими новостями в Телеграм-канале и на Twitter.

Присоединяйтесь к нашему Телеграм-каналу и группе в LinkedIn. Если вам интересна наша работа, вы полюбите нашу рассылку.

Не забудьте присоединиться к нашему сообществу более чем 46 000 специалистов по машинному обучению на Reddit.

Попробуйте AI Sales Bot от AI Lab itinai.ru, который поможет вам в автоматизации процессов в области продаж и обслуживания клиентов.

«`