«`html

Решение проблемы множественного изображения в вопросно-ответной системе

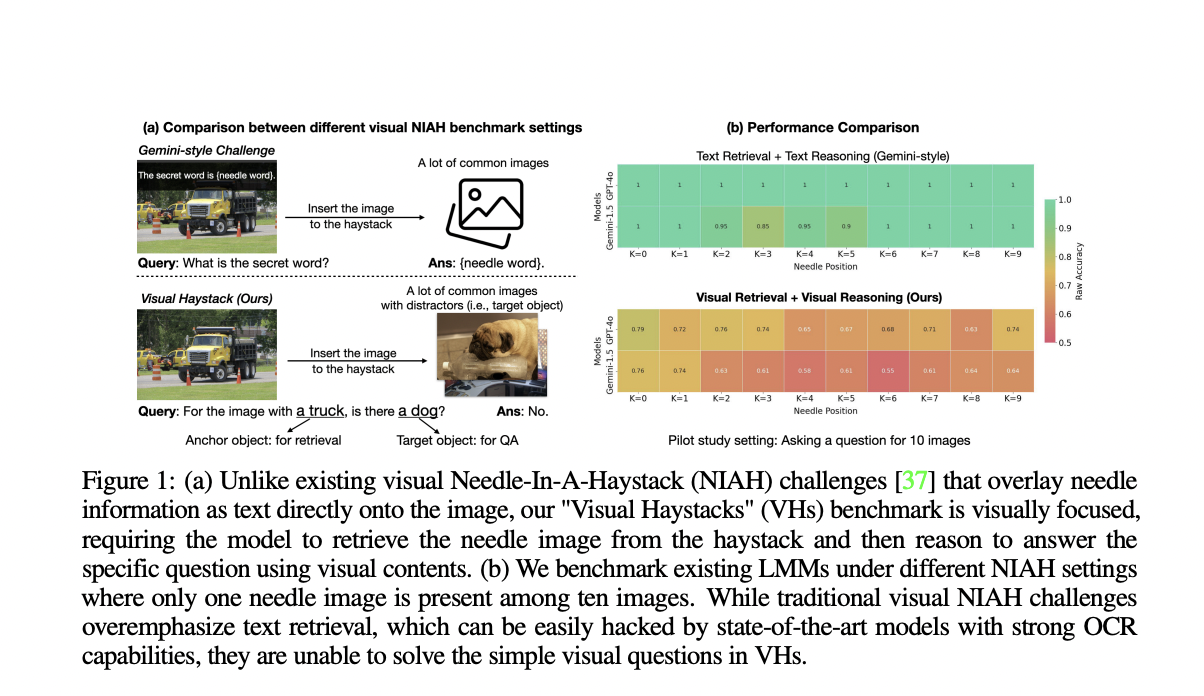

Одной из важнейших задач в области визуальной вопросно-ответной системы (VQA) является задача множественного визуального вопросно-ответного взаимодействия (MIQA). Это задача генерации соответствующих и обоснованных ответов на естественно-языковые запросы на основе большого набора изображений. Существующие модели больших мультимодальных изображений (LMMs) отлично справляются с ответами на вопросы по одному изображению, но сталкиваются с существенными трудностями, когда запросы охватывают большие коллекции изображений. Решение этой проблемы критически важно для реальных применений, таких как поиск в больших фотоальбомах, поиск конкретной информации в интернете или мониторинг изменений окружающей среды с помощью спутниковых изображений.

Проблемы существующих методов

На текущий момент методы визуального вопросно-ответного анализа в основном сосредоточены на анализе одного изображения, что ограничивает их ценность для более сложных запросов, связанных с большими наборами изображений. Модели типа Gemini 1.5-pro и GPT-4V могут обрабатывать несколько изображений, но сталкиваются с затруднениями в эффективном поиске и интеграции соответствующих изображений из больших наборов данных. Эти методы неэффективны с вычислительной точки зрения и демонстрируют ухудшение производительности при увеличении объема и изменчивости изображений. Они также страдают от позиционного смещения и затрудняют интеграцию визуальной информации по множеству несвязанных изображений, что приводит к снижению точности и применимости в масштабных задачах.

Новое решение — MIRAGE

Для преодоления этих ограничений исследователи из Университета Калифорнии предлагают MIRAGE (Multi-Image Retrieval Augmented Generation) — новую структуру, специально адаптированную для MIQA. MIRAGE расширяет модель LLaVA путем интеграции нескольких инновационных компонентов: сжатый кодировщик изображений, фильтр релевантности на основе запросов и обучение с использованием целевых синтетических и реальных данных MIQA. Эти инновации позволяют MIRAGE эффективно обрабатывать большие контексты изображений и повышать точность в решении задач MIQA. Этот подход представляет собой значительный вклад в область, предлагая улучшение точности до 11% по сравнению с закрытыми моделями, такими как GPT-4o на бенчмарке Visual Haystacks (VHs) и демонстрируя улучшение эффективности вплоть до 3.4 раза по сравнению с традиционными текстово-ориентированными подходами.

Основные характеристики MIRAGE

MIRAGE использует механизм сжатого кодирования изображений с помощью Q-former, чтобы сократить количество токенов на изображение с 576 до 32. Это позволяет модели обрабатывать больше изображений в рамках одного контекста. Фильтр релевантности на основе запросов представляет собой однослойную многослойную перцептронную нейронную сеть, которая предсказывает релевантность изображений для запроса, после чего используется для выбора релевантных изображений для детального анализа. Процесс обучения включает в себя как существующие наборы данных MIQA, так и синтетические данные, полученные из наборов данных вопросно-ответной системы одного изображения, что повышает устойчивость и производительность модели в различных сценариях MIQA. Набор данных VHs, используемый для тестирования, содержит 880 пар вопрос-ответ для одного иглы и 1000 пар для множественных игл, обеспечивая строгую оценку моделей MIQA.

Результаты и преимущества MIRAGE

Результаты оценки показывают, что MIRAGE заметно превосходит существующие модели на бенчмарке Visual Haystacks, превосходя закрытые модели, такие как GPT-4o, на 11% по точности для вопросов с одной иглой и демонстрируя заметное улучшение эффективности. MIRAGE поддерживает более высокие уровни производительности с увеличением количества изображений, демонстрируя свою устойчивость в обработке обширных визуальных контекстов. Он достиг значительных улучшений как в точности, так и в эффективности обработки по сравнению с традиционными текстово-ориентированными многоэтапными подходами.

Завершение и приглашение

Исследователи представляют значительный прогресс в области MIQA с помощью рамки MIRAGE. Важная проблема эффективного поиска и интеграции соответствующих изображений из больших наборов данных для ответа на сложные визуальные запросы решена. Инновационные компоненты MIRAGE и надежные методы обучения приводят к превосходной производительности и эффективности по сравнению с существующими моделями, открывая путь для более эффективного применения искусственного интеллекта в реальных сценариях, связанных с обширными визуальными данными.

Подробнее о работе смотрите на ссылке на статью, проекте, GitHub и деталях. Вся заслуга за это исследование принадлежит исследователям этого проекта. Также не забудьте подписаться на наш Twitter и присоединиться к нашему каналу в Telegram и группе в LinkedIn. Если вам нравится наша работа, вам понравится и наш новостной бюллетень.

Не забудьте присоединиться к нашему сообществу 47 тыс. пользователей в подразделе ML на Reddit.

Также смотрите предстоящие вебинары по ИИ здесь.

Это был перевод статьи The First “Visual-Centric” Needle-In-A-Haystack (NIAH) Benchmark to Assess LMMs’ Capability in Long-Context Visual Retrieval and Reasoning на MarkTechPost.