«`html

Встречайте Torchchat: гибкая платформа для ускорения Llama 3, 3.1 и других больших языковых моделей на ноутбуках, настольных ПК и мобильных устройствах

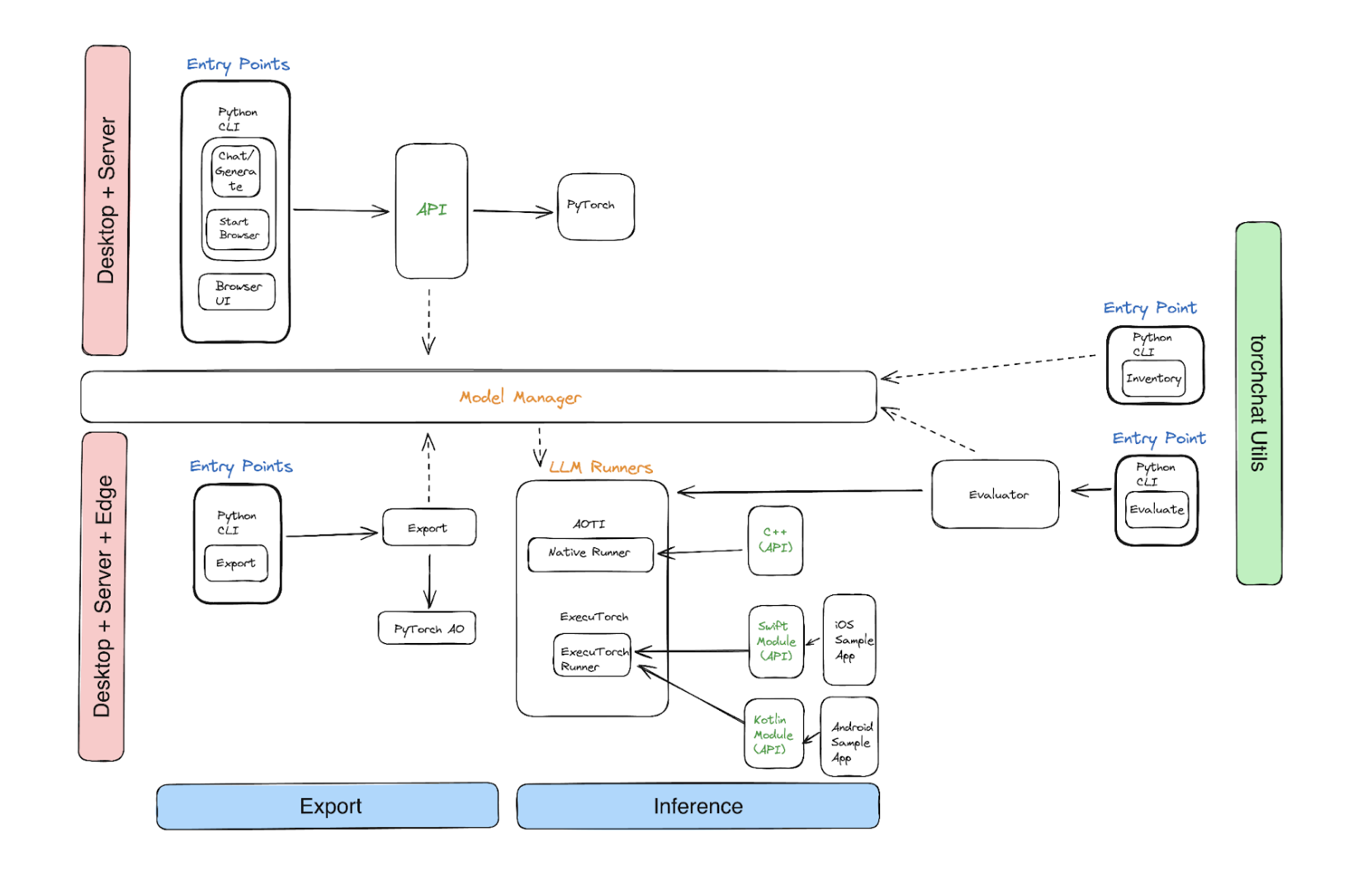

Быстрое развитие крупных языковых моделей (LLM) существенно повлияло на множество областей, таких как генеративное искусственное интеллект, понимание естественного языка и обработка естественного языка. Однако аппаратные ограничения исторически затрудняли запуск этих моделей локально на ноутбуке, настольном ПК или мобильном устройстве. Для преодоления этой проблемы команда PyTorch представила Torchchat — гибкую платформу, разработанную для максимизации производительности LLM, таких как Llama 3 и 3.1, в различных вычислительных условиях. Такой подход позволяет эффективно выполнять локальные выводы на различных устройствах, что может демократизировать доступ к мощным моделям искусственного интеллекта.

Основные особенности Torchchat:

- Python: Веб-браузер или интерфейс командной строки Python (CLI) могут использовать REST API Torchchat. Этот API представляет собой удобный выбор для ученых и разработчиков, поскольку упрощает взаимодействие с LLM.

- C++: С помощью бэкэнда AOTInductor PyTorch Torchchat предлагает бинарный файл, удобный для использования на настольных компьютерах. Эта особенность позволяет эффективно запускать LLM на платформах на базе x86, что делает их отличным выбором для высокопроизводительных настольных сред.

- Мобильные устройства: Torchchat использует ExecuTorch для экспорта бинарного файла ‘.pte’ для вывода на устройствах в ответ на растущий спрос на ИИ на мобильных платформах. Эта функция позволяет запускать надежные LLM на планшетах и смартфонах, открывая новые возможности для мобильных приложений.

В заключение, Torchchat предлагает гибкий и эффективный способ запуска мощных моделей искусственного интеллекта на различных устройствах, что является значительным прорывом в области локальных выводов LLM. Через Torchchat разработчики и исследователи могут более легко устанавливать и оптимизировать LLM локально, открывая новые возможности для исследований ИИ, начиная от настольных приложений и заканчивая мобильными прорывами.

Подробности и исходный код доступны на GitHub. Вся заслуга за этот проект принадлежит его исследователям. Также не забудьте подписаться на наш Twitter и присоединиться к нашему Telegram-каналу и группе в LinkedIn. Если вам нравится наша работа, вам понравится и наша рассылка.

Не забудьте присоединиться к нашему сообществу в Reddit и следить за предстоящими вебинарами по искусственному интеллекту.

Оригинал статьи доступен на MarkTechPost.

«`