«`html

The Role of Explainable AI in In Vitro Diagnostics Under European Regulations

AI в здравоохранении, особенно в ин витро-диагностике (IVD), становится все более важным. Европейское регулирование IVD признает программное обеспечение, включая алгоритмы искусственного интеллекта (AI) и машинного обучения (ML), как часть IVD. Этот регуляторный каркас представляет существенные вызовы для AI-основанных IVD, особенно тех, которые используют техники глубокого обучения (DL). Эти AI-системы должны работать точно и предоставлять понятные результаты, чтобы соответствовать регуляторным требованиям. Доверие к AI необходимо, так как оно должно давать возможность медицинским специалистам уверенно использовать AI в принятии решений, что требует разработки методов объяснимого AI (xAI). Инструменты, такие как layer-wise relevance propagation, могут помочь визуализировать элементы нейронной сети, вносящие вклад в конкретные результаты, обеспечивая необходимую прозрачность.

Explainability and Scientific Validity in AI for In Vitro Diagnostics

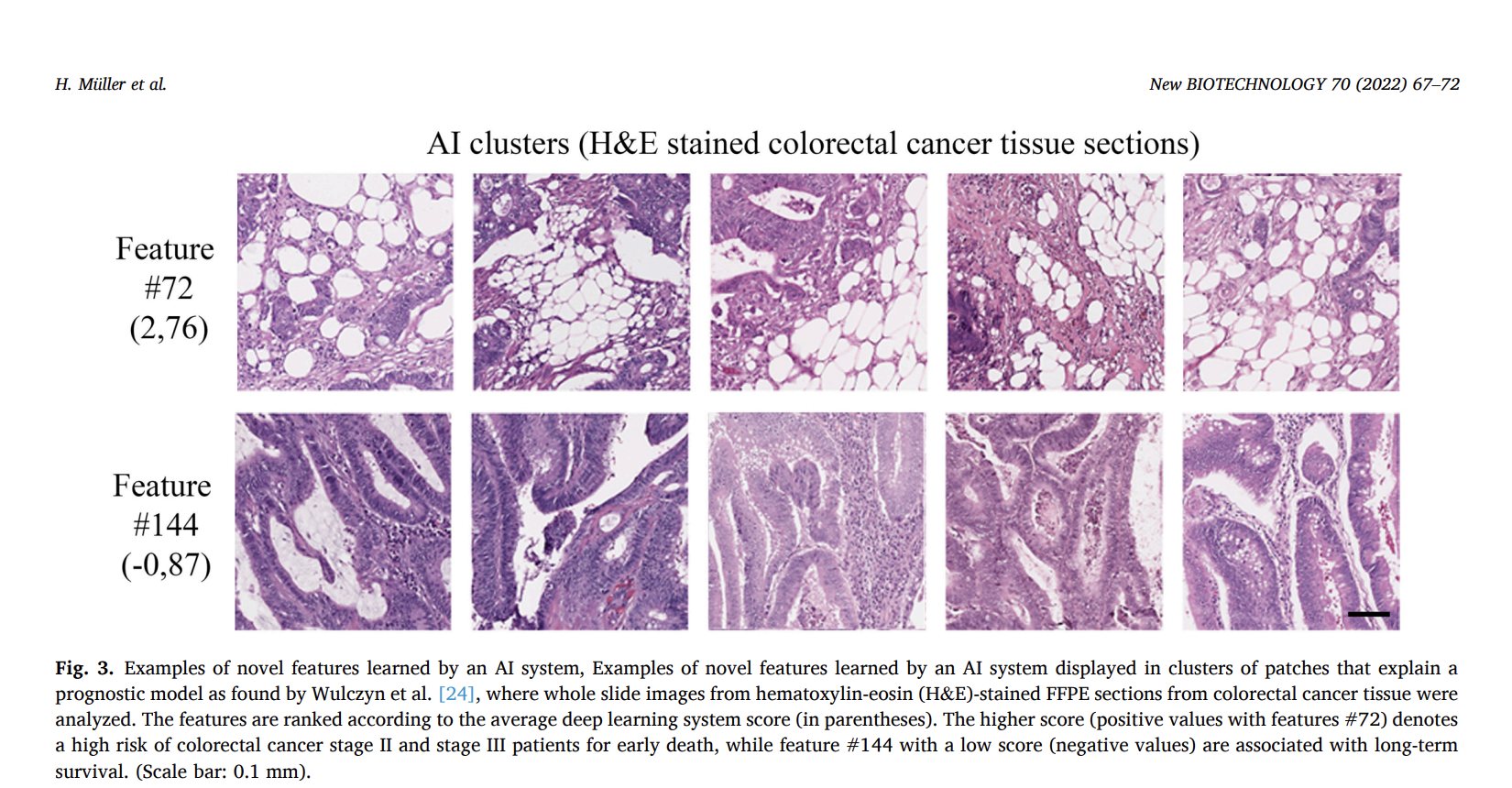

IVDR описывает научную обоснованность как связь между аналитом и конкретным клиническим состоянием или физиологическим состоянием. При применении этого к алгоритмам AI результаты должны быть объяснимы, а не просто получены непрозрачной моделью «черного ящика». Это важно для подтвержденных методов диагностики и алгоритмов AI, поддерживающих или заменяющих эти методы. Например, AI-система, разработанная для обнаружения и количественной оценки PD-L1-положительных опухолевых клеток, должна предоставлять патологам четкий и понятный процесс. Аналогично, при прогнозировании выживаемости при раке толстой кишки, выявленные AI-признаки должны быть объяснимы и подтверждены научными доказательствами, требуя независимой проверки, чтобы обеспечить доверие и точность результатов.

Explainability in Analytical Performance Evaluation for AI in IVDs

При оценке аналитической производительности AI в IVD важно обеспечить, чтобы алгоритмы AI точно обрабатывали входные данные по всему предполагаемому спектру. Это включает в себя учет пациентской популяции, заболеваний и качества сканирования. Методы объяснимого AI (xAI) являются ключевыми в определении допустимых диапазонов входных данных и выявлении, когда и почему AI-решения могут потерпеть неудачу, особенно в случае проблем с качеством данных или артефактов. Правильное управление данными и полное понимание тренировочных данных необходимы для избежания предвзятости и обеспечения надежной производительности AI в реальных приложениях.

Explainability in Clinical Performance Evaluation for AI in IVDs

Клиническая оценка производительности AI в IVD оценивает способность AI предоставлять результаты, соответствующие конкретным клиническим состояниям. Методы xAI критически важны для обеспечения того, чтобы AI эффективно поддерживало принятие решений. Эти методы фокусируются на том, чтобы процесс принятия решения AI был прослеживаемым, интерпретируемым и понятным для медицинских экспертов. Оценка различает между компонентами, обеспечивающими научное подтверждение, и теми, которые разъясняют медицински значимые факторы. Эффективная объяснимость требует статических объяснений и интерактивных, ориентированных на человека интерфейсов, соответствующих потребностям экспертов, обеспечивая более глубокое понимание причинно-следственных связей и прозрачность в AI-помогаемых диагнозах.

Conclusion

Для того чтобы AI-решения в IVD выполняли свою предназначенную цель, они должны продемонстрировать научную обоснованность, аналитическую производительность и, при необходимости, клиническую производительность. Обеспечение прослеживаемости и доверия требует, чтобы объяснения могли быть воспроизведены и проверены различными экспертами и были технически совместимы и понятны. Методы xAI решают критические вопросы: почему AI-решение работает, когда его можно применять и почему оно производит конкретные результаты. В биомедицинской области, где AI имеет огромный потенциал, xAI критически важен для соблюдения регуляторных требований и доверия медицинским специалистам для принятия обоснованных решений.

Источник изображения: [Image source]

Этот текст был адаптирован из оригинальной публикации на MarkTechPost.

Подробнее о данном исследовании можно узнать в оригинальной статье.

Не забудьте подписаться на нашу рассылку, чтобы быть в курсе всех новостей в области AI в медицине.

Подписывайтесь на наш Телеграм-канал и следите за нами в Twitter для самых свежих новостей и обновлений.

Присоединяйтесь к нашему сообществу в LinkedIn, чтобы обсудить последние тенденции в области AI в медицине.

Не забудьте присоединиться к нашему сообществу в Reddit, чтобы быть в курсе всех новостей и обсудить их с коллегами.

Узнайте о предстоящих вебинарах по AI на нашем сайте.

Arcee AI представляет DistillKit: открытый инструмент для моделирования, превращающий процесс дистилляции моделей в эффективное и высокопроизводительное решение для малых языковых моделей.