«`html

The Mixture of Experts (MoE) Models: Enhancing Performance and Computational Efficiency

Преимущества моделей Mixture of Experts (MoE)

Модели Mixture of Experts (MoE) повышают производительность и вычислительную эффективность путем селективной активации подмножеств параметров модели. Традиционные модели MoE используют однородных экспертов с идентичными возможностями, что ограничивает специализацию и использование параметров, особенно при работе с различными уровнями сложности входных данных. Недавние исследования показывают, что однородные эксперты имеют тенденцию сходиться к похожим представлениям, что уменьшает их эффективность. Для решения этой проблемы вводятся разнообразные эксперты, что может предложить лучшую специализацию, но возникают вызовы в определении оптимальной разнообразности и разработке эффективных распределений нагрузки для балансировки эффективности и производительности.

Новое решение: Heterogeneous Mixture of Experts (HMoE)

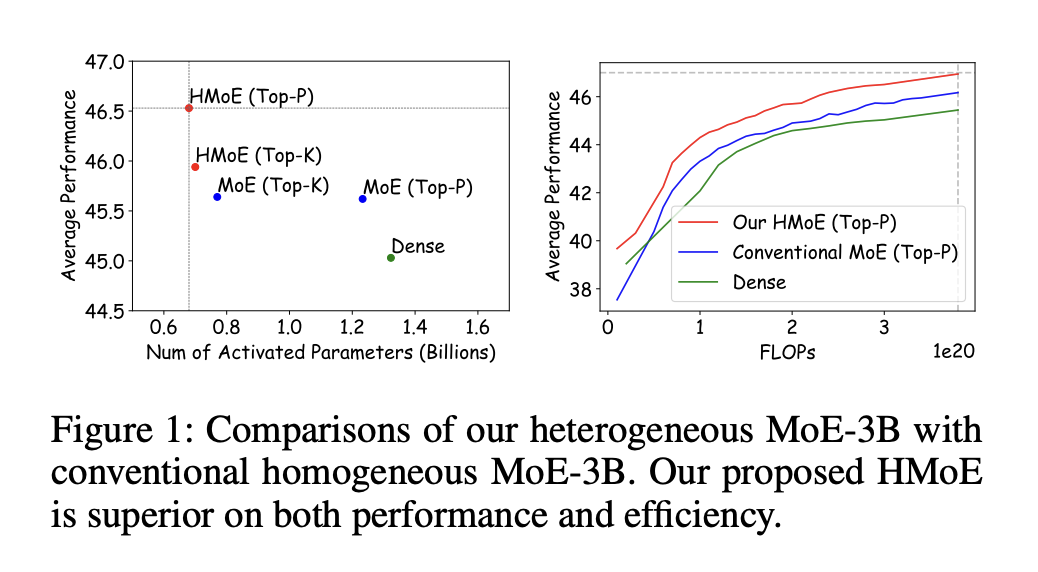

Исследователи из Tencent Hunyuan, Tokyo Institute of Technology и University of Macau представили модель Heterogeneous Mixture of Experts (HMoE), где эксперты различаются по размеру, что позволяет лучше обрабатывать разнообразные уровни сложности токенов. Для решения дисбаланса активации они предлагают новую цель обучения, которая приоритизирует активацию меньших экспертов, улучшая вычислительную эффективность и использование параметров. Их эксперименты показывают, что HMoE достигает более низких потерь с меньшим количеством активированных параметров и превосходит традиционные однородные модели MoE на различных показателях. Кроме того, они исследуют стратегии для оптимальной разнообразности экспертов.

Практическое применение

Модель MoE делит задачи обучения между специализированными экспертами, каждый из которых фокусируется на различных аспектах данных. Поздние разработки внедрили техники селективной активации подмножества этих экспертов, улучшая эффективность и производительность. Недавние исследования интегрировали модели MoE в современные архитектуры, оптимизируя выбор экспертов и балансируя их нагрузку. Исследование расширяет эти концепции, представляя модель HMoE, которая использует экспертов различного размера для лучшей обработки разнообразных уровней сложности токенов. Этот подход приводит к более эффективному использованию ресурсов и повышенной производительности в целом.

Сравнение с классическими моделями MoE

Классические модели MoE заменяют слой Feed-Forward Network (FFN) в трансформерах на слой MoE, состоящий из нескольких экспертов и механизма маршрутизации, который активирует подмножество этих экспертов для каждого токена. Однако традиционные однородные модели MoE требуют большей специализации экспертов, эффективного распределения параметров и дисбаланса нагрузки. Модель HMoE предлагается для решения этих проблем, где эксперты различаются по размеру, что позволяет лучшую специализацию и эффективное использование ресурсов. Исследование также представляет новые функции потерь для оптимизации активации меньших экспертов и поддержания общего баланса модели.

Результаты и перспективы

Исследование оценивает модель HMoE по сравнению с классическими моделями MoE, демонстрируя ее превосходную производительность, особенно при использовании стратегии маршрутизации Top-P. HMoE последовательно превосходит другие модели на различных показателях, преимущества становятся более заметными по мере обучения и увеличения вычислительных ресурсов. Исследование подчеркивает эффективность функции P-Penalty loss в оптимизации меньших экспертов и преимущества гибридного распределения размеров экспертов. Подробные анализы показывают, что HMoE эффективно распределяет токены в зависимости от сложности, при этом меньшие эксперты обрабатывают общие задачи, а большие специализируются на более сложных.

Заключение

Модель HMoE была разработана с экспертами различных размеров для лучшей обработки разнообразных уровней сложности токенов. Была разработана новая цель обучения для стимулирования активации меньших экспертов, что улучшает вычислительную эффективность и производительность. Эксперименты подтвердили, что HMoE превосходит традиционные однородные модели MoE, достигая более низких потерь с меньшим количеством активированных параметров. Исследование предполагает, что подход HMoE открывает новые возможности для разработки крупных языковых моделей с потенциальными будущими применениями в различных задачах обработки естественного языка. Код для этой модели будет доступен после принятия.

Проверьте статью. Вся заслуга за это исследование принадлежит исследователям этого проекта. Также не забудьте подписаться на наш Twitter и присоединиться к нашему Telegram каналу и группе в LinkedIn. Если вам понравилась наша работа, вам понравится наш новостной бюллетень.

Не забудьте присоединиться к нашему 49k+ ML SubReddit.

Найдите предстоящие вебинары по ИИ здесь.

The post Heterogeneous Mixture of Experts (HMoE): Enhancing Model Efficiency and Performance with Diverse Expert Capacities appeared first on MarkTechPost.

Применение Heterogeneous Mixture of Experts (HMoE) в вашем бизнесе

Использование ИИ для развития бизнеса

Если вы хотите, чтобы ваша компания развивалась с помощью искусственного интеллекта (ИИ) и оставалась в числе лидеров, грамотно используйте Heterogeneous Mixture of Experts (HMoE): Enhancing Model Efficiency and Performance with Diverse Expert Capacities.

Практические шаги

Проанализируйте, как ИИ может изменить вашу работу. Определите, где возможно применение автоматизации: найдите моменты, когда ваши клиенты могут извлечь выгоду из AI. Определитесь какие ключевые показатели эффективности (KPI): вы хотите улучшить с помощью ИИ. Подберите подходящее решение, сейчас очень много вариантов ИИ. Внедряйте ИИ решения постепенно: начните с малого проекта, анализируйте результаты и KPI. На полученных данных и опыте расширяйте автоматизацию.

Получение дополнительной информации

Если вам нужны советы по внедрению ИИ, пишите нам на https://t.me/itinai. Следите за новостями о ИИ в нашем Телеграм-канале t.me/itinainews или в Twitter @itinairu45358.

Продукты и решения

Попробуйте AI Sales Bot https://itinai.ru/aisales. Этот AI ассистент в продажах помогает отвечать на вопросы клиентов, генерировать контент для отдела продаж, снижать нагрузку на первую линию. Узнайте, как ИИ может изменить ваши процессы с решениями от AI Lab itinai.ru — будущее уже здесь!

«`