«`html

CausalLM выпустил miniG: инновационную масштабируемую модель языка ИИ, обученную на синтезированном наборе данных из 120 миллионов записей

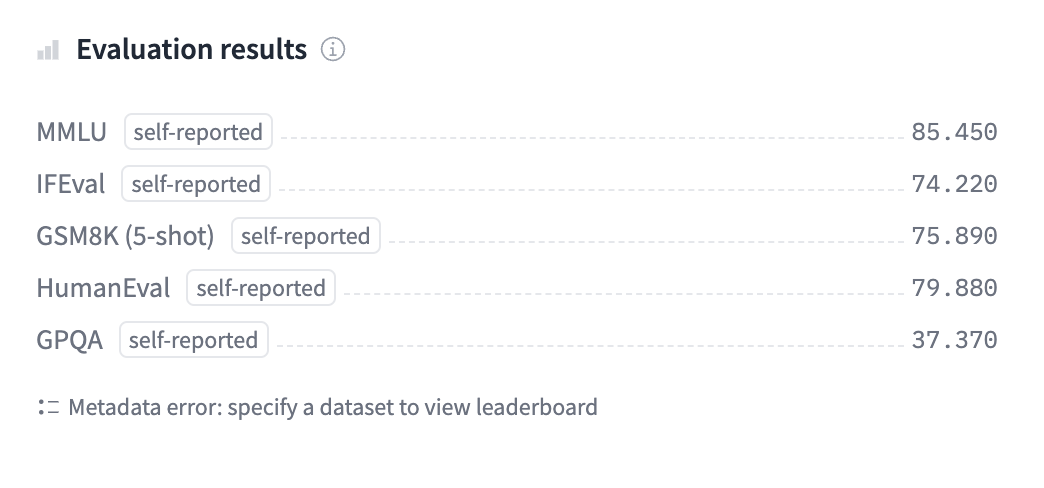

miniG — это прорывная модель языка, разработанная для сокращения разрыва между производительностью и эффективностью. Эта инновационная модель выделяется своими мощными возможностями и компактным дизайном, что делает передовые технологии ИИ более доступными для широкой аудитории. По мере того, как отрасли все больше ищут экономичные и масштабируемые решения ИИ, miniG становится трансформационным инструментом, устанавливающим новый стандарт в разработке и развертывании моделей ИИ.

Фон и разработка miniG

miniG, последнее творение CausalLM, представляет собой значительный скачок в области языковых моделей ИИ. CausalLM, известная своими навыками в разработке передовых моделей ИИ, еще раз продемонстрировала свое мастерство с выпуском miniG. Разработка miniG была обусловлена потребностью в более эффективной, масштабируемой и универсальной языковой модели, способной работать на уровне, сравнимом с более крупными аналогами, сохраняя при этом более компактные размеры.

Источник изображения

Создание miniG включало в себя тщательный процесс исследований и разработки, в ходе которого команда CausalLM сосредоточилась на оптимизации архитектуры модели. Целью было создание модели, способной обеспечивать высокую производительность с меньшими вычислительными ресурсами. Эта цель была достигнута за счет использования передовых техник сжатия моделей, донастройки и дистилляции знаний. Результатом стала языковая модель, мощная и доступная для более широкого круга пользователей, от крупных предприятий до индивидуальных разработчиков.

Основные особенности и возможности miniG

Одним из наиболее замечательных аспектов miniG является его способность выполнять сложные языковые задачи с впечатляющей точностью. Несмотря на свой более компактный размер, miniG не уступает в производительности. Он превосходит в задачах обработки естественного языка (NLP), таких как генерация текста, анализ настроений, перевод и суммирование. Архитектура модели разработана для эффективной обработки больших наборов данных, что делает ее подходящей для различных прикладных задач.

Еще одной особенностью, выделяющей miniG, является его масштабируемость. CausalLM обеспечила возможность легкой интеграции miniG в различные платформы, будь то облачные службы или периферийные устройства. Эта гибкость критически важна для отраслей или компаний, требующих обработки и анализа данных в реальном времени, таких как финансы, здравоохранение и обслуживание клиентов. Способность miniG работать плавно в различных средах делает его важным инструментом для разработчиков, которым необходимо создавать приложения, работающие на ИИ, с ограниченными ресурсами.

Помимо технических возможностей, miniG разработан с удобством использования в виду. CausalLM предоставила полную документацию и поддержку, чтобы помочь пользователям быстро начать работу с моделью. Компания также сделала модель доступной через различные интерфейсы, включая API и библиотеки с открытым исходным кодом, обеспечивая возможность интеграции miniG в свои проекты с минимальными усилиями.

Влияние на сообщество ИИ и отрасль

Выпуск miniG ожидается оказать глубокое влияние на сообщество ИИ и различные отрасли. MiniG устанавливает новый стандарт эффективности и производительности для исследовательского сообщества ИИ. Он бросает вызов убеждению, что большие модели всегда лучше, демонстрируя, что более компактные, оптимизированные модели могут достичь сопоставимых результатов. Этот сдвиг во взглядах, вероятно, повлияет на будущие направления исследований, стимулируя разработку более эффективных моделей, доступных более широкой аудитории.

В отрасли выпуск miniG сопровождается растущим спросом на мощные, экономичные решения ИИ. Бизнесы все больше ищут ИИ-модели, которые могут быть масштабированы без препятствий. miniG отвечает этому требованию, предлагая модель, обеспечивающую высокую производительность за долю стоимости более крупных моделей. Эта доступность и универсальность делают miniG привлекательным вариантом для компаний, желающих интегрировать ИИ в свою деятельность.

Выпуск miniG, вероятно, стимулирует инновации в приложениях ИИ. С мощной, но доступной моделью разработчики и бизнесы могут исследовать новые случаи использования ИИ, ранее считавшиеся слишком ресурсоемкими. Это может привести к разработке новых продуктов и услуг, работающих на ИИ, способствуя росту в технологической отрасли и за ее пределами.

Этические соображения и перспективы

Как и любая модель ИИ, выпуск miniG также вызывает важные этические вопросы. CausalLM подчеркнула важность ответственной разработки ИИ и предприняла шаги, чтобы обеспечить использование miniG в соответствии с этическими стандартами. Компания внедрила меры по предотвращению злоупотребления моделью, такие как ограничение доступа к определенным функциям и предоставление рекомендаций по ответственному использованию ИИ. CausalLM уже намекнула на будущие обновления и итерации модели, которые могут включать улучшения в производительности, безопасности и пользовательском опыте. Преданность компании инновациям подразумевает, что miniG — это только начало новой эры в развитии ИИ, где эффективность и доступность приоритетны наряду с мощностью и производительностью.

Заключение

Выпуск miniG от CausalLM объединяет высокую производительность с эффективностью и доступностью. miniG может потенциально революционизировать использование ИИ в различных отраслях. Его влияние, вероятно, будет ощущено в технологическом секторе и таких областях, как здравоохранение, финансы и обслуживание клиентов, где ИИ становится неотъемлемой частью операций.

Ознакомьтесь с карточкой модели. Вся заслуга за это исследование принадлежит исследователям этого проекта. Также не забудьте подписаться на наш Twitter и присоединиться к нашему Telegram-каналу и группе LinkedIn. Если вам нравится наша работа, вам понравится наша рассылка.

Не забудьте присоединиться к нашему сообществу в Reddit.

Вот рекомендуемый вебинар от нашего спонсора: «Построение производительных приложений ИИ с помощью NVIDIA NIMs и Haystack».

Этот пост был опубликован на MarkTechPost.

«`