«`html

DeepSeek-V2.5: Новейшая модель в мире искусственного интеллекта

DeepSeek-AI выпустили DeepSeek-V2.5, мощную модель Mixture of Experts (MOE) с 238 миллиардами параметров, 160 экспертами и 16 миллиардами активных параметров для оптимальной производительности.

Особенности DeepSeek-V2.5:

- Оптимизирована для чатов и задач кодинга

- Предлагает функции вызова функций, генерации JSON-вывода и завершения Fill-in-the-Middle (FIM)

- Имеет впечатляющую длину контекста 128k

DeepSeek-V2.5 объединяет две предыдущие модели: DeepSeekV2-Chat и DeepSeek-Coder-V2-Instruct, обещая улучшенный опыт пользователя, улучшенные возможности кодирования и лучшее соответствие человеческим предпочтениям.

Основные особенности DeepSeek-V2.5:

- Лучшее соответствие человеческим предпочтениям

- Улучшенные возможности письма и выполнения инструкций

- Обобщенные и кодирующие способности

- Оптимизированные требования к выводу

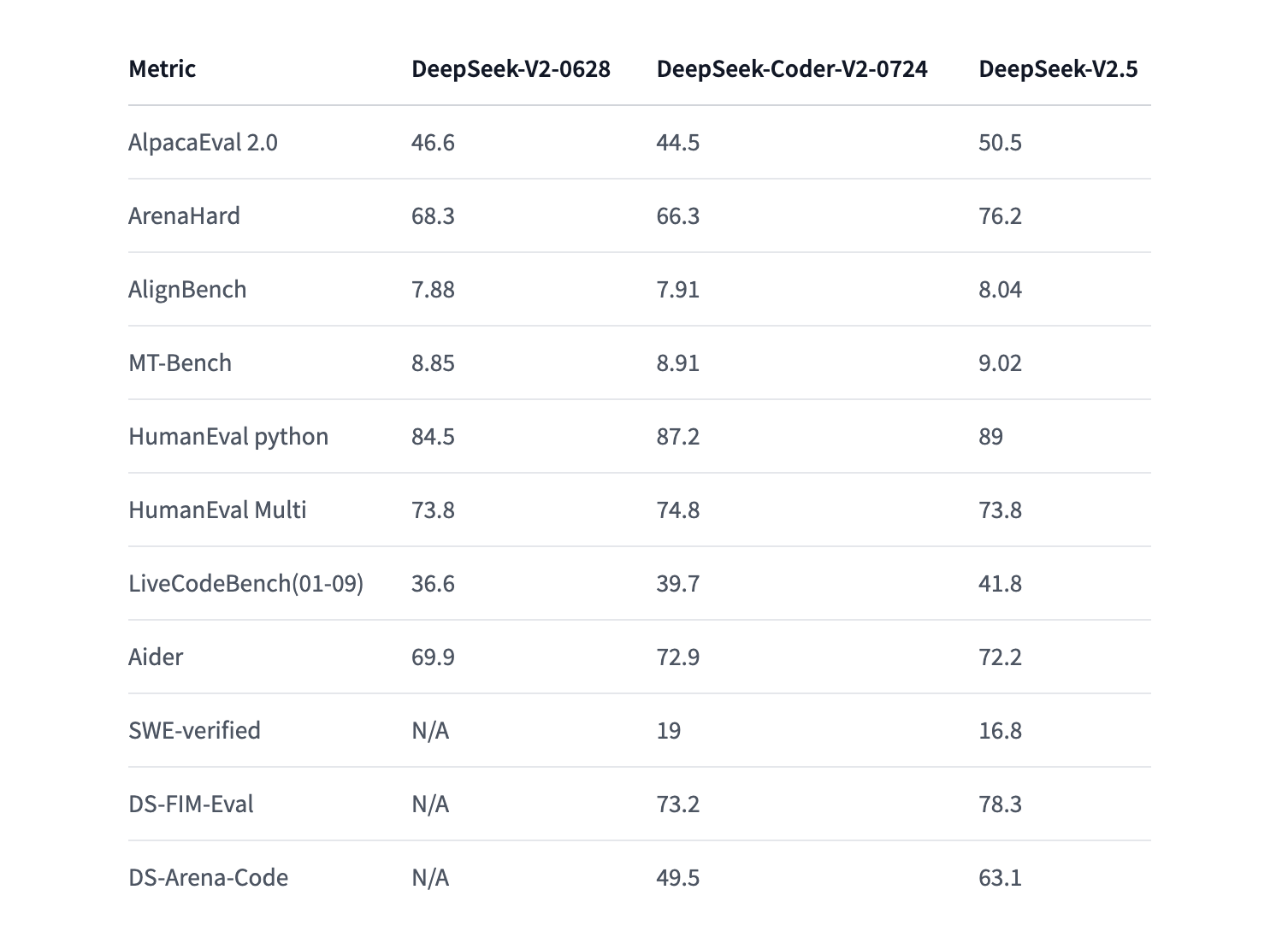

DeepSeek-V2.5 обладает впечатляющими показателями производительности и способностями, что делает его ценным инструментом для разработчиков, исследователей и бизнеса.

Развертывание и использование

DeepSeek-V2.5 предоставляет несколько способов использования. Для пользователей, желающих запустить модель локально, доступны Hugging Face’s Transformers или vLLM, предлагающие облачные решения вывода.

Лицензирование и коммерческое использование

DeepSeek-V2.5 имеет MIT License, позволяющую гибкое использование в коммерческих и некоммерческих приложениях.

Заключение

DeepSeek-V2.5 обещает выдающуюся производительность, улучшенный пользовательский опыт и большую адаптивность, делая его бесценным инструментом для разработчиков, исследователей и бизнеса.

«`