Улучшение обобщения длины в алгоритмических задачах с помощью петлевых трансформеров: исследование проблем n-RASP-L

Практические решения и ценность:

Недавние исследования показывают, что трансформеры, успешные в задачах арифметики и алгоритмов, нуждаются в помощи с обобщением длины, где модели обрабатывают входы неизвестной длины. Это критично для алгоритмических задач, таких как программирование или рассуждения, где длина ввода часто коррелирует с сложностью проблемы. Подходы, такие как цепочка рассуждений и методы scratchpad, предлагают некоторое улучшение. Перспективным решением является петлевой трансформер, который обрабатывает входы итеративно, позволяя адаптивные шаги на основе сложности задачи и улучшая обобщение длины для алгоритмических задач.

Исследователи из Университета Висконсин-Мэдисон, MIT и UC Berkeley демонстрируют, что петлевые трансформеры с адаптивными шагами улучшают обобщение длины для алгоритмических задач. Фокусируясь на функции с итеративными решениями с использованием операций RASP-L, они обучают петлевые трансформеры без промежуточного надзора, полагаясь исключительно на ввод, вывод и количество шагов. На этапе вывода модель определяет необходимые шаги для решения задачи. Их метод показывает, что петлевые трансформеры адаптируют количество циклов во время вывода, обеспечивая успешное обобщение длины. Исследование представляет проблемы n-RASP-L и демонстрирует улучшенную производительность на задачах типа Copy, Parity и Addition по сравнению с базовыми подходами.

Исследование изучает позиционные вложения, RNN, иерархию Чомского, Универсальные трансформеры, представления ввода и цепочку рассуждений в обобщении длины. Позиционные вложения улучшают способность трансформеров к обобщению, но не используются в операциях RASP-L. Исследования показывают, что RNN и трансформеры испытывают трудности с нерегулярными задачами, в то время как структурированная память помогает в обобщении без контекста. Петлевой трансформер адаптирует Универсальный трансформер с шагозависимым надзором, улучшая обобщение задач. Кроме того, цепочка рассуждений может упростить предсказания, но ее шаги могут внести сложность, которая затрудняет обобщение. Исследование также различает методы предсказания следующего токена (NTP) и полного ответа (FAP).

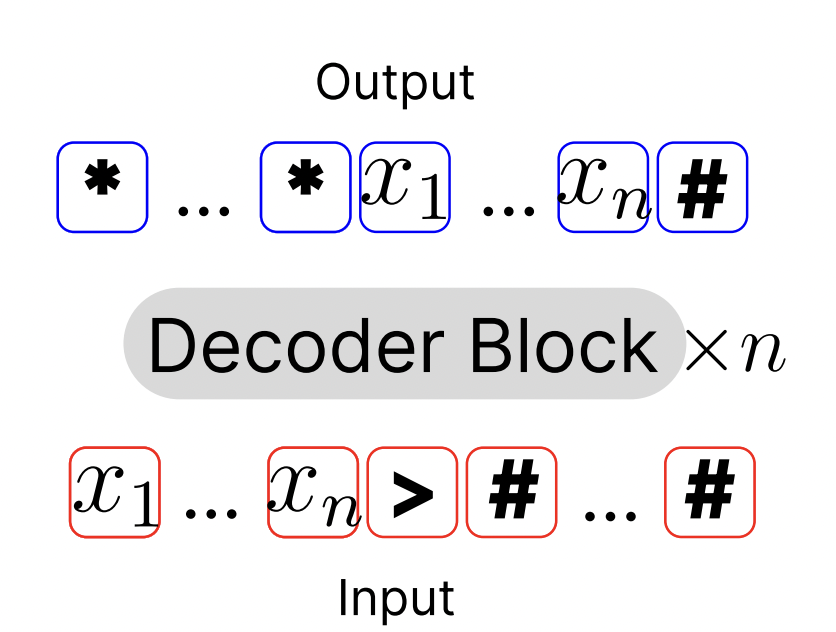

Фреймворк n-RASP-L решает алгоритмические задачи с использованием декодеров трансформеров только с фиксированной глубиной без циклов, что делает задачи, такие как сложение или четность, сложными. Предлагается архитектура «петлевого трансформера», которая повторно использует блоки декодера на нескольких итерациях в зависимости от длины ввода. Это позволяет решать задачи, такие как сложение n-разрядных чисел и четность через итеративные процессы. Модель надзирается на протяжении всего обучения, используя пары ввода-вывода без промежуточных шагов. На этапе вывода используются адаптивные правила остановки, такие как оракул шагов или пороги уверенности, для принятия решения о завершении петлевого процесса.

Исследование оценивает эффективность петлевых трансформеров для задач, требующих обобщения длины. Были оценены различные задачи, включая четность, копирование, сложение, двоичную сумму и умножение. Экспериментальная установка включает обучение по курсам, и петлевая модель показывает превосходное обобщение, особенно в обработке более длинных последовательностей, превышающих длины обучения. Сравнения с базовыми методами, такими как обычное NTP, NTP с токенами паузы и связанными весами, показывают, что петлевая модель с адаптивной глубиной значительно превосходит эти подходы. Анализ отбора подчеркивает положительное влияние ввода и адаптивной глубины на производительность, а критерии остановки на основе максимальной уверенности обеспечивают оптимальные результаты.

Эта работа имеет несколько ограничений, включая вычислительные требования прямого обучения с петлями при обработке многих шагов и ограниченные данные обучения из-за ограничений ресурсов. Использование более простых позиционных вложений (NoPE) также оставляет место для улучшений. Несмотря на то, что для надзора требуются истинные номера шагов, метод предполагает меньше, чем обучение CoT. В заключение, петлевые трансформеры с шагозависимым надзором эффективно улучшают обобщение длины, особенно для сложных задач n-RASP-L. В то время как предыдущие модели сталкивались с неизвестными длинами ввода, этот подход адаптирует количество шагов во время вывода, показывая потенциал для более широкого применения в более сложных задачах рассуждения.

Проверьте статью. Вся заслуга за это исследование принадлежит исследователям этого проекта. Также не забудьте подписаться на нас в Twitter и присоединиться к нашему каналу в Telegram и группе в LinkedIn. Если вам нравится наша работа, вам понравится наш рассылка.

Не забудьте присоединиться к нашему 52k+ ML SubReddit.

Мы приглашаем стартапы, компании и исследовательские учреждения, работающие над небольшими языковыми моделями, принять участие в предстоящем журнале/отчете «Маленькие языковые модели» от Marketchpost.com. Этот журнал/отчет будет выпущен в конце октября/начале ноября 2024 года. Нажмите здесь, чтобы назначить звонок!

Используйте ИИ для развития вашего бизнеса

Если вы хотите, чтобы ваша компания развивалась с помощью искусственного интеллекта (ИИ) и оставалась в числе лидеров, грамотно используйте Improving Length Generalization in Algorithmic Tasks with Looped Transformers: A Study on n-RASP-L Problems.

Проанализируйте, как ИИ может изменить вашу работу. Определите, где возможно применение автоматизации: найдите моменты, когда ваши клиенты могут извлечь выгоду из AI.

Определитесь какие ключевые показатели эффективности (KPI): вы хотите улучшить с помощью ИИ.

Подберите подходящее решение, сейчас очень много вариантов ИИ. Внедряйте ИИ решения постепенно: начните с малого проекта, анализируйте результаты и KPI.

На полученных данных и опыте расширяйте автоматизацию.

Если вам нужны советы по внедрению ИИ, пишите нам на https://t.me/itinai. Следите за новостями о ИИ в нашем Телеграм-канале t.me/itinainews или в Twitter @itinairu45358.

Попробуйте AI Sales Bot https://itinai.ru/aisales. Этот AI ассистент в продажах помогает отвечать на вопросы клиентов, генерировать контент для отдела продаж, снижать нагрузку на первую линию.

Узнайте, как ИИ может изменить ваши процессы с решениями от AI Lab itinai.ru. Будущее уже здесь!