Block Transformer: Улучшение эффективности вывода в больших языковых моделях через иерархическое глобальное-локальное моделирование

Практические решения и ценность:

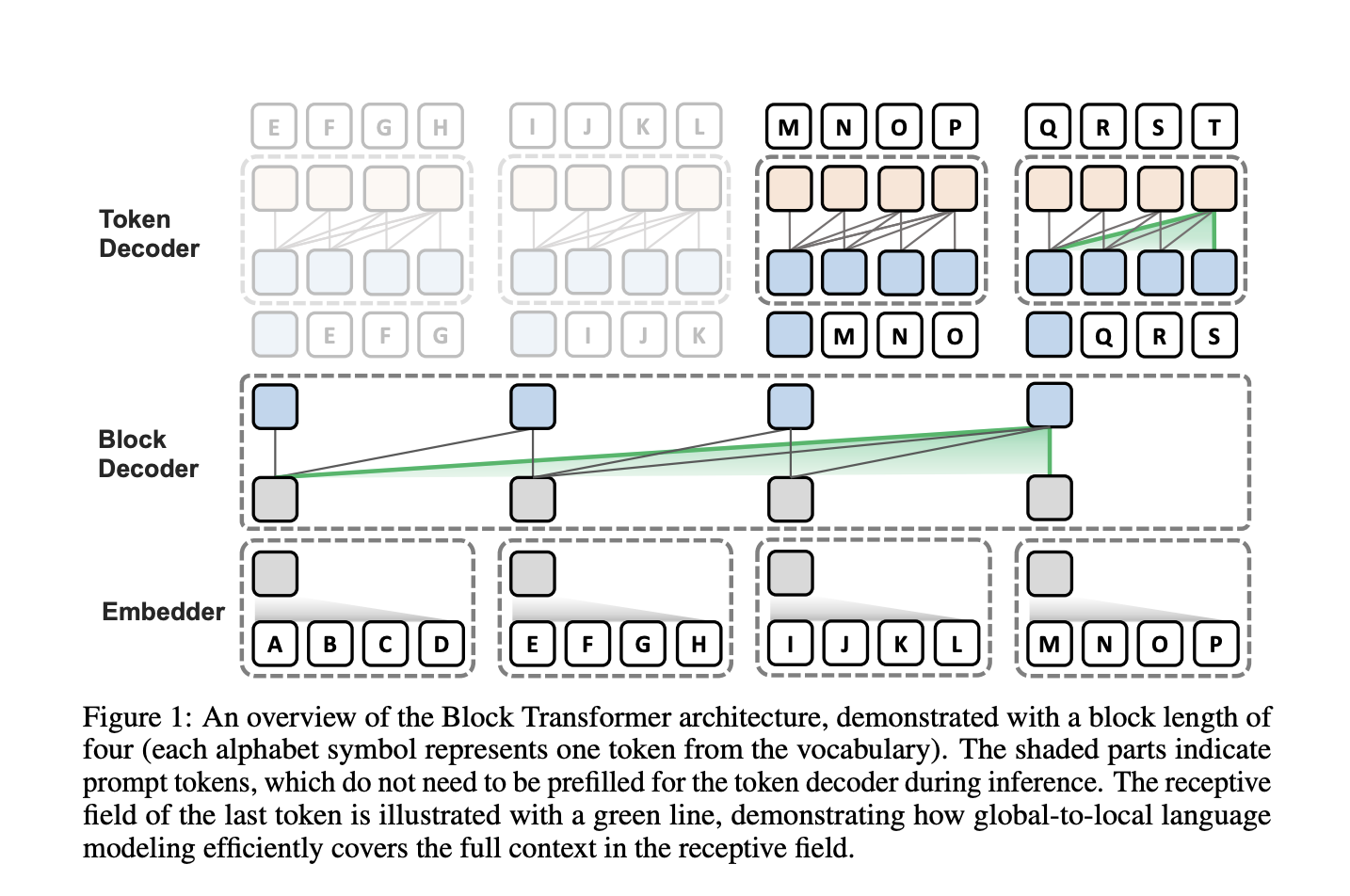

Благодаря архитектуре Block Transformer, исследователи предложили подход к авторегрессивным трансформерам, который позволяет значительно улучшить время вывода. Эта модель представляет собой значительное улучшение по сравнению с обычными трансформерами при равной производительности благодаря стратегическому архитектурному дизайну.

Block Transformer обеспечивает существенное увеличение производительности вывода по сравнению с обычными моделями трансформеров с помощью глобального и локального моделирования, выявляя ранее недооцененные преимущества вывода декодера токенов.

Архитектура Block Transformer позволяет сравнимую производительность языкового моделирования с обычными моделями с эквивалентными параметрами, достигая подобной перплексии и точности на оценочных задачах без обучения.

Эффективность Block Transformer проявляется как на этапе предварительной загрузки, так и на этапе декодирования, обращаясь к основным узким местам в традиционных моделях трансформеров.

Используйте решения от AI Lab itinai.ru, чтобы понять, как ИИ может оптимизировать ваши процессы и принести вашему бизнесу конкурентные преимущества.

Для получения консультаций по внедрению ИИ обращайтесь к нам на Telegram или следите за новостями в нашем Телеграм-канале и на Twitter.

Ознакомьтесь с AI Sales Bot здесь. Этот AI ассистент в продажах поможет взаимодействовать с клиентами, создавать контент и снижать нагрузку на персонал.

Начните использовать инновационные решения ИИ сегодня, чтобы оставаться на шаг впереди в вашей отрасли.