Революционные рекуррентные нейронные сети (RNNs)

RNNs являются важными в машинном обучении для работы с последовательностями, такими как прогнозирование временных рядов и обработка естественного языка. Они могут использоваться для решения сложных задач на основе последовательностей разной длины.

Проблемы и решения

Проблемы с градиентом могут снизить эффективность RNNs на длинных последовательностях. Но современные модели, такие как Transformers, предлагают баланс между производительностью и эффективностью.

Новые методы и эффективность

Методы, такие как Mamba и линейные модели внимания, позволяют улучшить производительность и эффективность обучения. Однако они требуют специальных методов реализации.

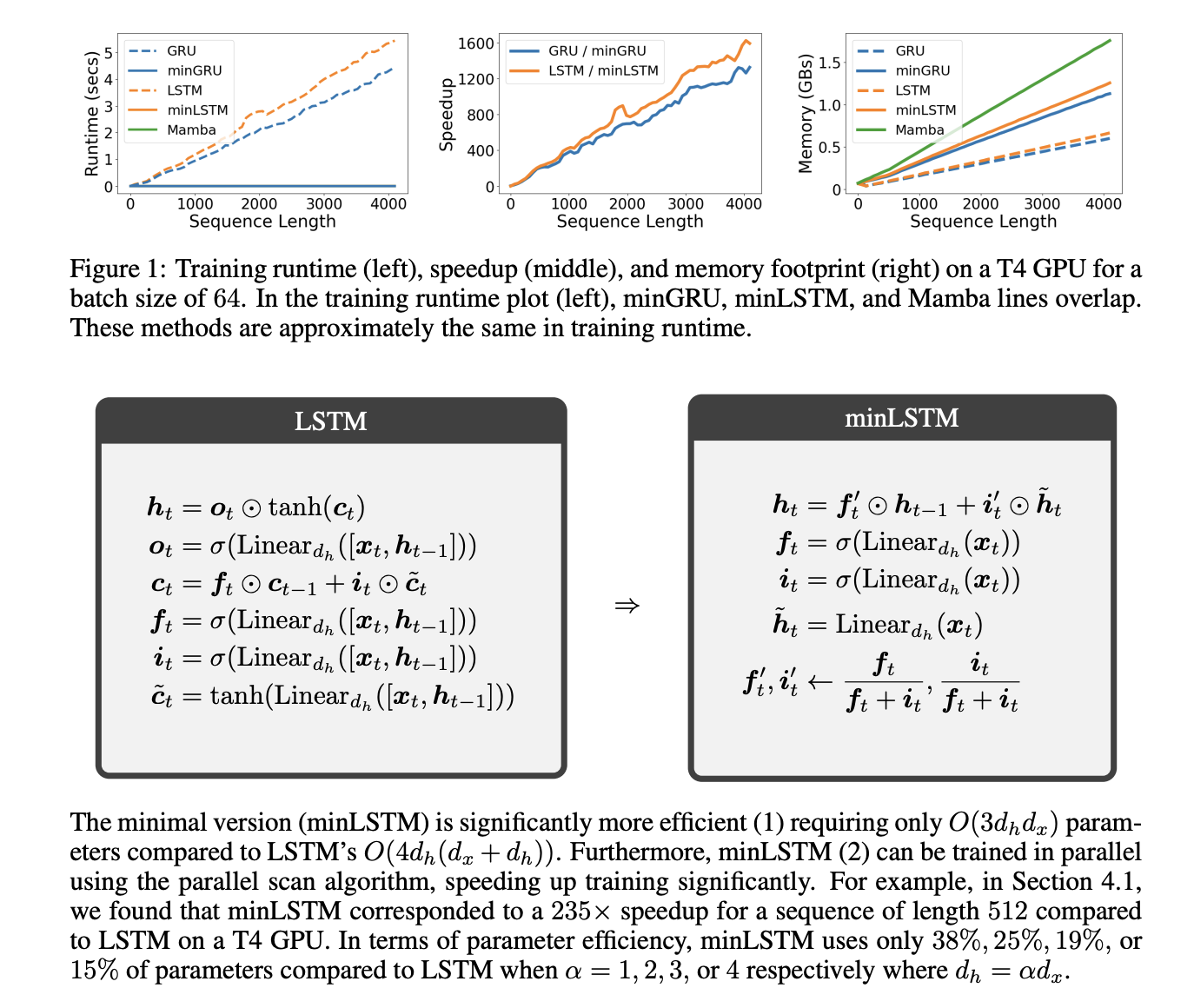

Минимизированные LSTM и GRU модели

Модели minLSTM и minGRU улучшают эффективность обучения на длинных последовательностях, уменьшая количество параметров и ускоряя процесс обучения до 175 раз.

Практическое применение

Эти минимальные модели демонстрируют высокую производительность в задачах обучения с подкреплением и языковом моделировании, сравнимую с современными архитектурами.