«`html

Роль Red Teaming в оценке рисков ИИ

Red teaming играет ключевую роль в оценке рисков, связанных с моделями и системами искусственного интеллекта (ИИ). Он выявляет новые угрозы, определяет недостатки в существующих мерах безопасности и укрепляет количественные показатели безопасности.

Ценности Red Teaming

Эта практика помогает развивать новые стандарты безопасности, повышая доверие общественности и легитимность оценки рисков ИИ.

Подход OpenAI к Red Teaming

Документ описывает подход OpenAI к внешнему red teaming, который помогает в оценке и снижении рисков современных моделей ИИ. Сотрудничая с экспертами, OpenAI получает ценные данные о возможностях и уязвимостях моделей.

Применение Red Teaming

С 2022 года OpenAI использует внешний red teaming, начиная с запуска DALL-E 2. Эта практика включает в себя структурированное тестирование для выявления уязвимостей и рисков ИИ систем.

Преимущества внешнего Red Teaming

Внешний red teaming предлагает значительную ценность, выявляя новые риски и стресс-тестируя существующие меры защиты. Он также включает в себя независимые оценки, что способствует снижению предвзятости и обеспечивает объективные данные о потенциальных рисках.

Подходы к тестированию

Методы red teaming варьируются, включая ручные и автоматизированные подходы. Смешанные методы позволяют создавать обратные связи, где ручное тестирование используется для улучшения автоматизированных процессов.

Этапы эффективной кампании Red Teaming

Ключевые этапы включают определение группы red teamers, вопросы о модели и угрозах, а также создание четких интерфейсов и документации. Это гарантирует целенаправленные оценки рисков для ИИ систем.

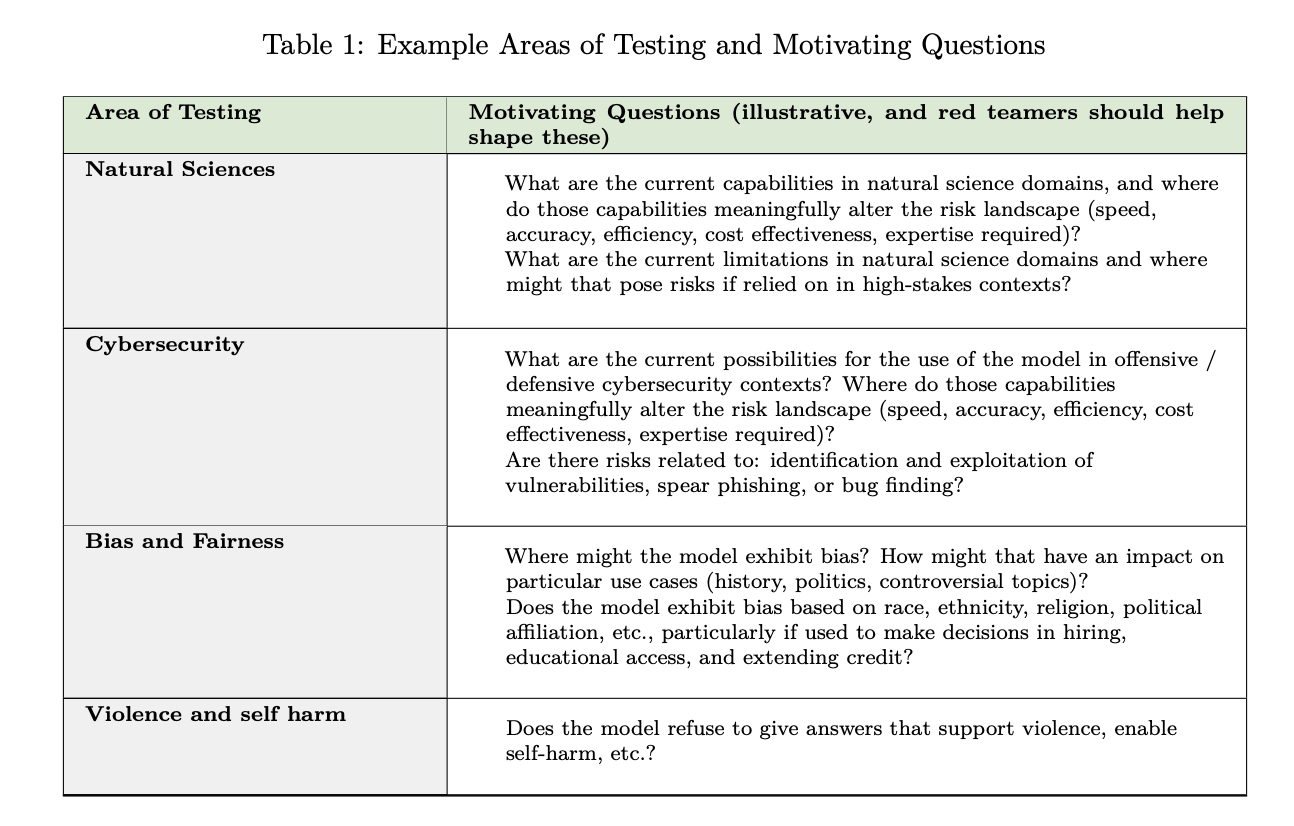

Тестирование по различным темам

Комплексное тестирование включает в себя разные области, отражающие различные случаи использования и связанные с ними риски. Моделирование угроз помогает сосредоточиться на более важных аспектах.

Автоматизированные оценки

Переход от человеческого red teaming к автоматизированным оценкам важен для масштабируемых и последовательных проверок безопасности ИИ. Данные от human red teamers служат основой для автоматизированных оценок.

Ограничения Red Teaming

Несмотря на ценность, red teaming имеет ограничения, включая высокие затраты и риск психологического воздействия на участников. Также существует риск использования полученной информации для ненадлежащих целей.

Заключение

Red teaming является важным инструментом для оценки рисков ИИ. Понимание пользовательского опыта и реальных факторов имеет решающее значение. Хотя не существует единого процесса для решения всех проблем, red teaming предлагает проактивный механизм для выявления рисков.

Как использовать ИИ в вашей компании

Если вы хотите развивать свою компанию с помощью ИИ, рассмотрите следующие шаги:

- Проанализируйте, как ИИ может изменить вашу работу.

- Определите ключевые показатели эффективности (KPI), которые хотите улучшить.

- Подберите подходящее ИИ решение и внедряйте его постепенно.

Для получения советов по внедрению ИИ, пишите нам на Telegram.

«`