«`html

Оптимизация предпочтений в тестовом времени: Новая AI-рамка для улучшения результатов LLM

Большие языковые модели (LLM) стали важной частью нашей жизни, влияя на многие сферы. Они показывают отличные результаты, но иногда генерируют неожиданные и небезопасные ответы. Исследования направлены на то, чтобы лучше согласовать LLM с человеческими предпочтениями, используя их обширные обучающие данные.

Практические решения и ценность

Методы, такие как обучение с подкреплением на основе человеческой обратной связи (RLHF) и оптимизация предпочтений (DPO), показали свою эффективность, но требуют итеративного обучения. Исследователи работают над изменением подходов к выводу, чтобы улучшить производительность.

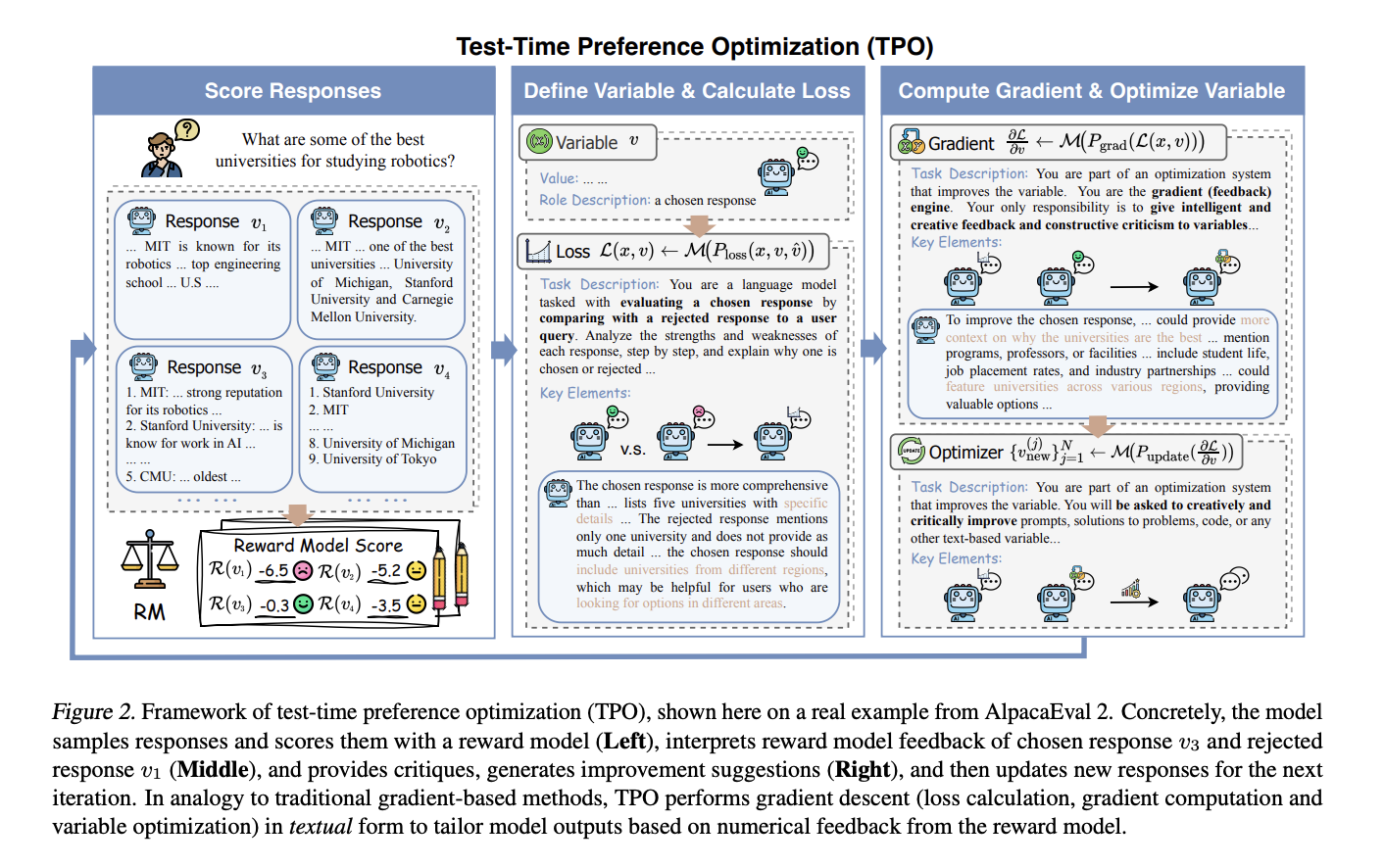

Команда из Шанхайской лаборатории ИИ представила оптимизацию предпочтений в тестовом времени (TPO). Эта новая рамка позволяет согласовать выводы LLM с человеческими предпочтениями во время тестирования. TPO использует текстовую обратную связь вместо числовых оценок для оптимизации предпочтений.

Во время тестирования новые ответы оцениваются на каждом шаге оптимизации, и результаты классифицируются как «выбранные» или «отклоненные». Модель учится на лучших ответах и недостатках отклоненных, создавая «текстовые градиенты» для следующей итерации. TPO улучшает выводы на основе взаимодействия с текстовыми наградами.

Исследования показали, что несколько шагов TPO значительно улучшили производительность как согласованных, так и несогласованных моделей. Например, модель Llama-3.1-70B-SFT, которая не проходила оптимизацию предпочтений, показала лучшие результаты после применения TPO.

Заключение

Команда представила TPO как онлайн-рамку для согласования выводов LLM с человеческими предпочтениями. Это решение оптимизирует ответы во время тестирования и исключает необходимость повторного обучения. TPO предлагает высокую масштабируемость и гибкость, что делает его многообещающим подходом для будущих работ с LLM.

Если вы хотите, чтобы ваша компания развивалась с помощью ИИ, изучите, как TPO может помочь. Определите, где можно применить автоматизацию и какие ключевые показатели эффективности (KPI) вы хотите улучшить.

Начните с малого проекта, анализируйте результаты и расширяйте автоматизацию на основе полученных данных. Если вам нужны советы по внедрению ИИ, свяжитесь с нами.

Попробуйте AI Sales Bot, который помогает отвечать на вопросы клиентов и генерировать контент для отдела продаж. Узнайте, как ИИ может изменить ваши процессы с решениями от AI Lab. Будущее уже здесь!

«`