«`html

Эффективные решения для внедрения ИИ на устройствах с ограниченными ресурсами

Устройства, такие как смартфоны и IoT-устройства, обрабатывают данные локально. Это повышает конфиденциальность, снижает задержку и улучшает отзывчивость. Однако внедрение больших языковых моделей (LLM) на таких устройствах сложно из-за их высоких требований к вычислительной мощности и памяти.

Проблемы с внедрением LLM

Большие языковые модели требуют значительных ресурсов, что превышает возможности большинства устройств. Традиционные методы используют высокую точность вычислений, что увеличивает потребление памяти и энергии. Низкоточные методы, такие как quantization, помогают, но могут возникнуть проблемы совместимости с оборудованием.

Новые решения от Microsoft

Исследователи Microsoft представили ряд инноваций для эффективной работы LLM на устройствах с ограниченными ресурсами:

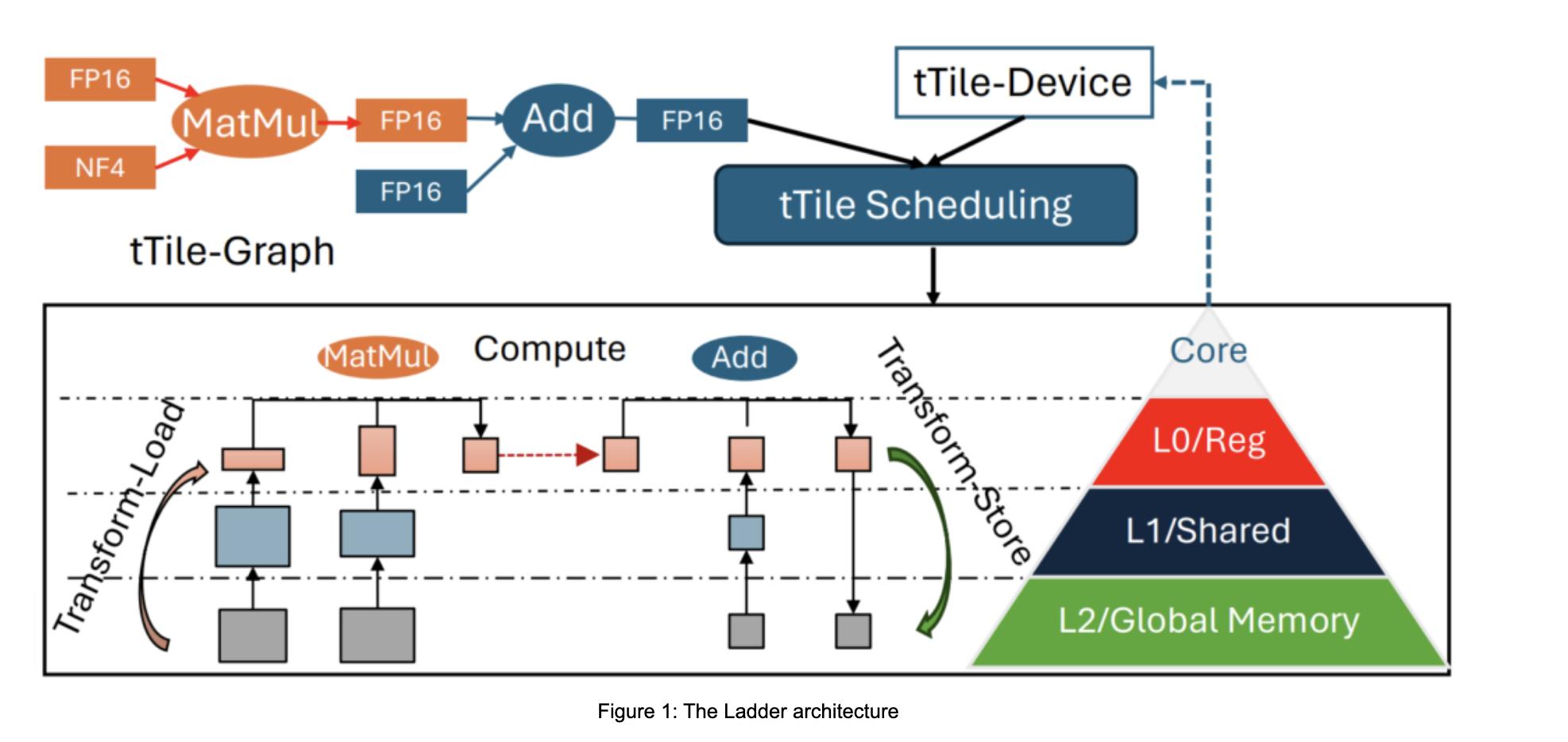

- Компилятор типов данных Ladder — обеспечивает совместимость низкоточных моделей с аппаратными ограничениями.

- Библиотека T-MAC mpGEMM — оптимизирует вычисления с переменной точностью, улучшая эффективность.

- Аппаратная архитектура LUT Tensor Core — специализированный ускоритель для низкоточной квантизации, снижает потребление энергии.

Преимущества новых технологий

Эти методы позволяют LLM эффективно работать на различных устройствах, от высокопроизводительных ноутбуков до низкопотребляющих IoT-устройств:

- Снижение размера модели за счет низкоточной квантизации.

- Увеличение скорости вывода благодаря оптимизации вычислений.

- Легкая интеграция пользовательских форматов данных с существующим оборудованием.

- Снижение потребления энергии, что делает LLM доступными для устройств с низким энергопотреблением.

Заключение

Работа исследователей Microsoft подчеркивает важность новых методов квантизации для внедрения LLM на устройствах с ограниченными ресурсами. Эти решения помогают преодолеть проблемы, связанные с потреблением памяти и эффективностью вычислений. Внедрение технологий Ladder, T-MAC и LUT Tensor Core открывает новые возможности для AI-приложений.

Если вы хотите, чтобы ваша компания развивалась с помощью ИИ, проанализируйте, как ИИ может изменить вашу работу. Определите ключевые показатели эффективности (KPI) и выберите подходящее решение.

Внедряйте ИИ постепенно: начните с малого проекта и расширяйте автоматизацию на основе полученных данных.

Если вам нужны советы по внедрению ИИ, пишите нам. Следите за новостями о ИИ в нашем канале.

«`