Оптимизация модели NV-Embed-v1 для анализа настроений

В этом руководстве мы рассмотрим, как настроить модель NV-Embed-v1 от NVIDIA на наборе данных Amazon Polarity с использованием LoRA (низкоранговой адаптации) и PEFT (эффективной настройки параметров) от Hugging Face. Это позволяет адаптировать модель без изменения всех её параметров, что делает настройку возможной даже на GPU с низким объемом видеопамяти.

Шаги реализации

- Аутентификация в Hugging Face для доступа к NV-Embed-v1

- Эффективная загрузка и настройка модели

- Применение LoRA для настройки с использованием PEFT

- Предобработка набора данных Amazon Polarity для обучения

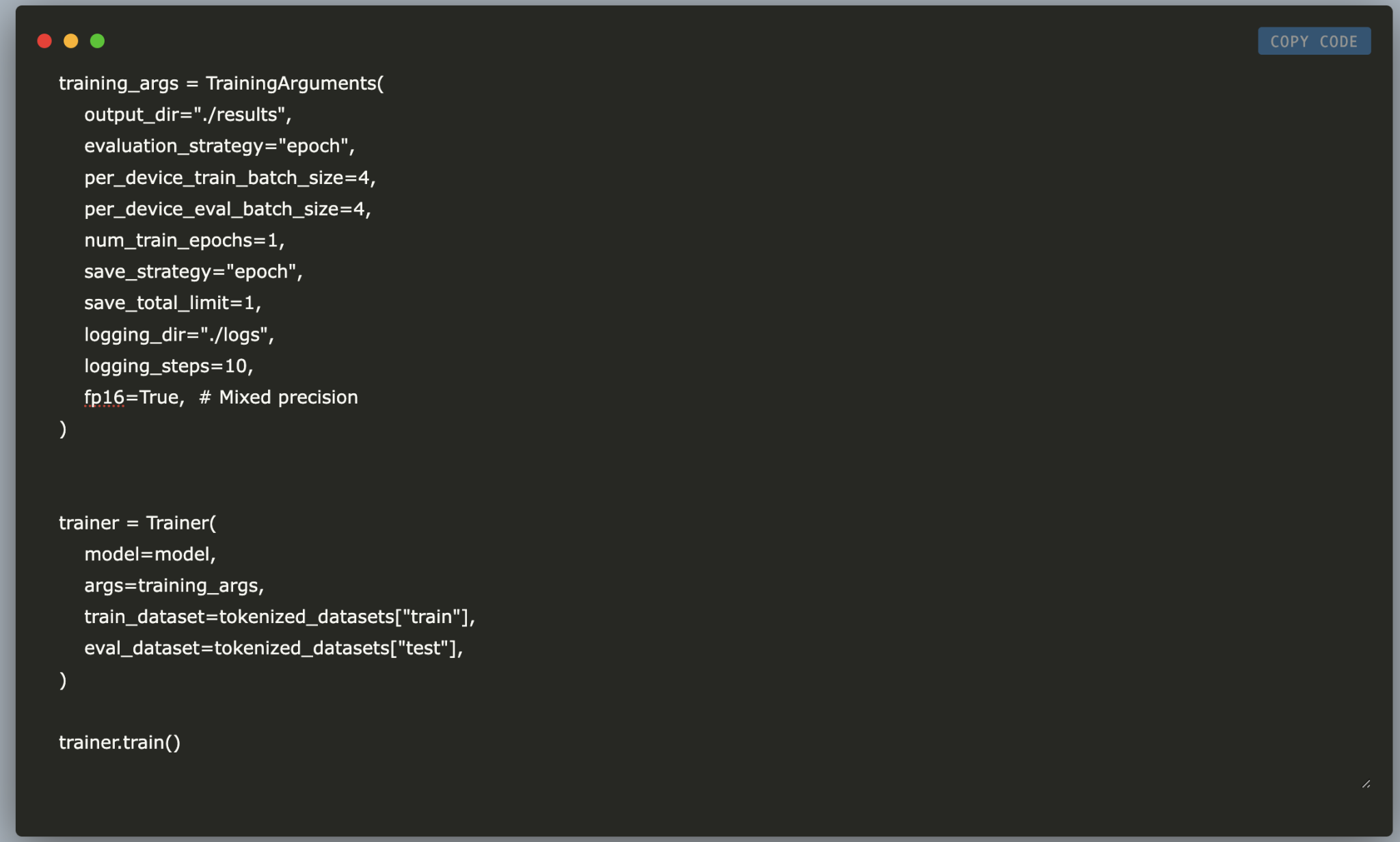

- Оптимизация использования видеопамяти GPU с помощью

device_map="auto" - Обучение и оценка модели для классификации настроений

В конце этого руководства у вас будет настроенная модель NV-Embed-v1, оптимизированная для бинарной классификации настроений, что демонстрирует применение эффективных методов настройки для реальных задач обработки естественного языка.

Практическое применение

Используя данную методику, вы сможете:

- Автоматизировать процессы, связанные с анализом отзывов клиентов.

- Оптимизировать взаимодействие с клиентами с помощью AI-решений, таких как чат-боты.

- Эффективно использовать ресурсы, минимизируя затраты на вычисления.

Если вам нужна помощь в управлении AI в бизнесе, свяжитесь с нами по адресу hello@itinai.ru. Подписывайтесь на наш Telegram, чтобы быть в курсе последних новостей в области AI.