Решения для бизнеса с использованием искусственного интеллекта

Обучение крупных языковых моделей (LLMs) стало важным направлением в развитии искусственного интеллекта, однако это связано с определенными проблемами. По мере увеличения размеров моделей и объемов данных традиционные методы оптимизации, такие как AdamW, начинают проявлять свои ограничения. Основные трудности заключаются в управлении вычислительными затратами и обеспечении стабильности во время длительных тренировок.

В ответ на эти вызовы, компания Moonshot AI в сотрудничестве с UCLA разработала модель Moonlight — Mixture-of-Expert (MoE), оптимизированную с помощью оптимизатора Muon. Moonlight доступна в двух конфигурациях: версия с 3 миллиардами активированных параметров и общим количеством 16 миллиардов параметров, обученная на 5.7 триллионах токенов.

Технические детали

Ключевыми модификациями, сделанными для оптимизатора Muon, являются интеграция весового распада и калибровка масштаба обновления для каждого параметра. Эти изменения способствуют более равномерному обновлению параметров и контролю роста весов, что особенно важно при обучении крупных моделей.

Распределенная реализация Muon основана на методах ZeRO-1, что позволяет снизить затраты памяти и уменьшить расходы на коммуникацию в процессе распределенного обучения. Это делает оптимизатор более эффективным и менее требовательным к вычислительным ресурсам.

Практические результаты

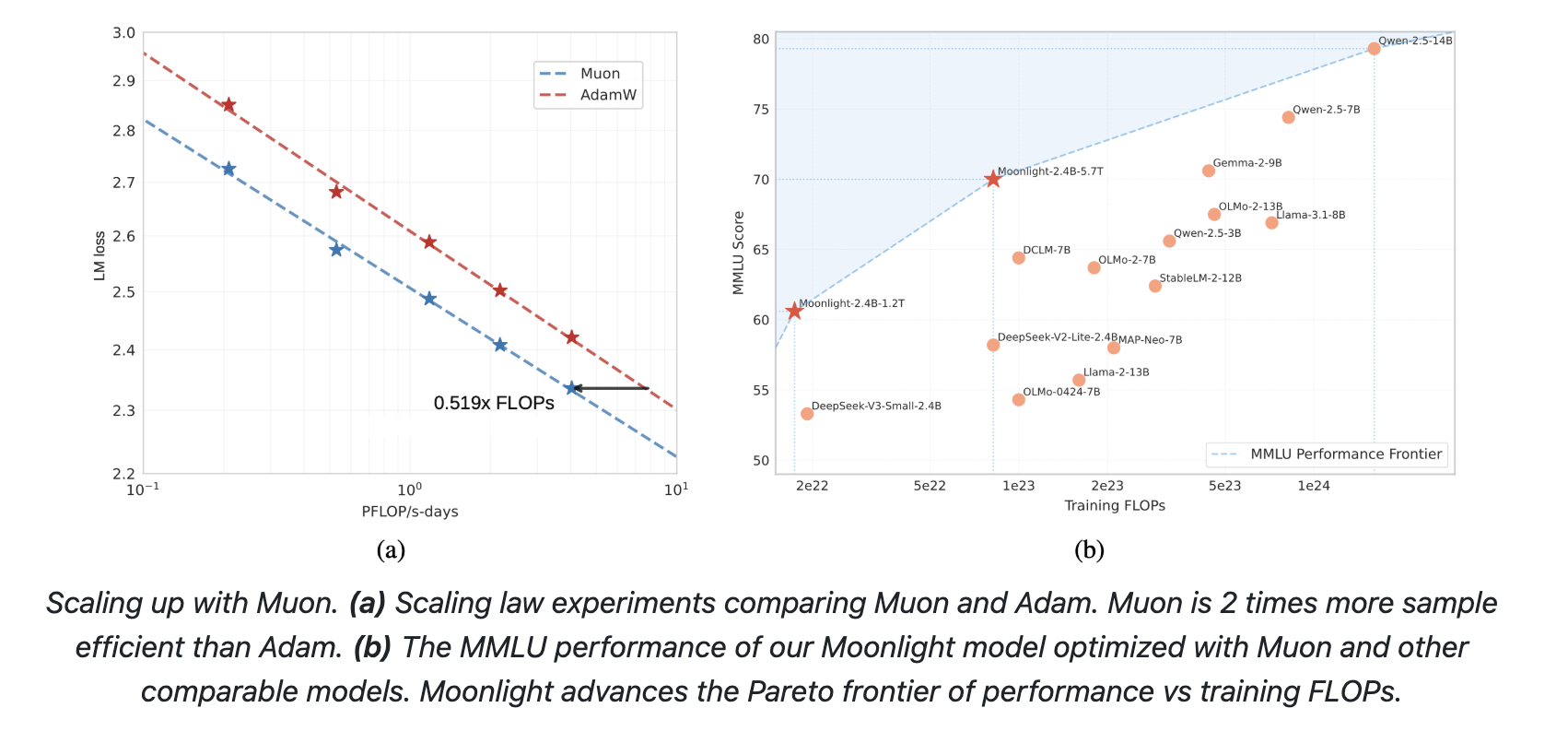

Эмпирические оценки Moonlight показывают, что она демонстрирует улучшения по сравнению с моделями, обученными с использованием AdamW. Например, в задачах по оценке языкового понимания Moonlight показала более высокие результаты на бенчмарках. Эксперименты с законом масштабирования показывают, что Muon может сопоставить производительность моделей, обученных с помощью AdamW, при использовании только половины вычислительных затрат.

Заключение

Разработка Moonlight представляет собой значительный шаг вперед в обучении крупных языковых моделей. Использование оптимизатора Muon демонстрирует улучшения в эффективности обучения и стабильности моделей. Ключевые улучшения и распределенная реализация подчеркивают практические преимущества данного подхода.

Ожидается, что открытый доступ к реализации Muon и предобученным моделям будет способствовать дальнейшим исследованиям в области масштабируемых методов оптимизации. Будущие работы могут исследовать расширение Muon для других нормовых ограничений или интеграцию его преимуществ в единую оптимизационную структуру.

Если вам нужна помощь в управлении искусственным интеллектом в бизнесе, свяжитесь с нами по адресу hello@itinai.ru. Чтобы быть в курсе последних новостей в области ИИ, подписывайтесь на наш Telegram: https://t.me/itinai.

Посмотрите практический пример решения на базе ИИ: продажный бот, предназначенный для автоматизации общения с клиентами круглосуточно и управления взаимодействиями на всех этапах клиентского пути.