«`html

Оптимизатор Adam-mini: революционное решение для обучения больших языковых моделей с уменьшенным использованием памяти и улучшенной производительностью

Исследования в области оптимизации алгоритмов для обучения больших языковых моделей (LLM) являются ключевыми для понимания и генерации человеческого языка. Оптимизация этих процессов имеет высокий приоритет для исследователей из-за значительного потребления вычислительных ресурсов и памяти.

Проблема и решение

Основная проблема, рассмотренная в данной статье, связана с высокими требованиями к памяти оптимизационных алгоритмов, используемых при обучении больших языковых моделей. Оптимизатор Adam, стандарт в этой области из-за своей высокой производительности, требует значительного объема памяти для хранения состояний оптимизатора. Альтернативные методы, такие как Adafactor, пытаются снизить использование памяти, но зачастую компрометируют производительность, что подчеркивает необходимость более эффективных решений.

Революционное решение

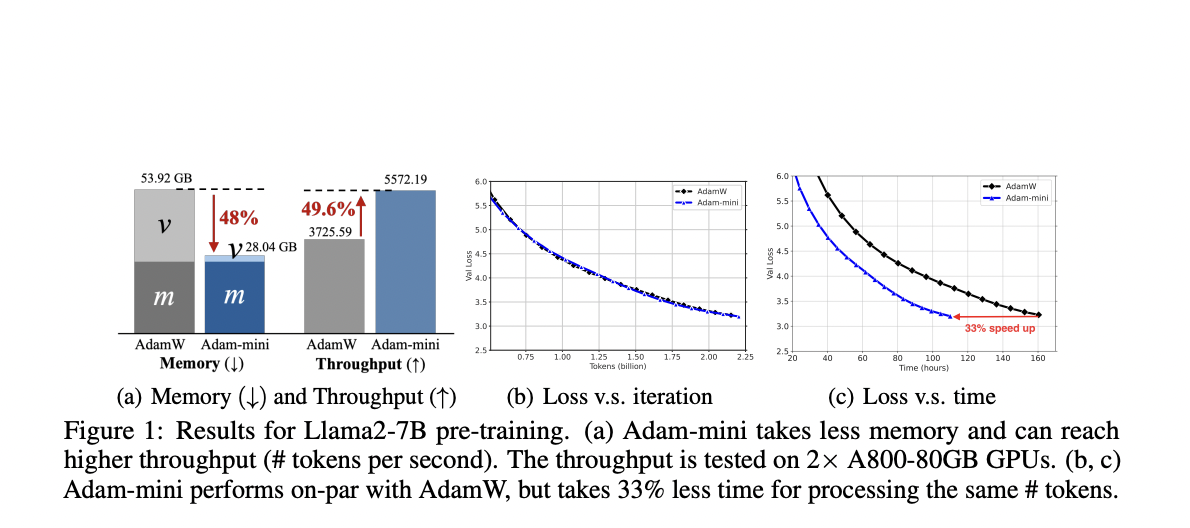

Adam-mini разработан для достижения аналогичной или даже более высокой производительности по сравнению с Adam при снижении использования памяти на 45% — 50%. Оптимизатор достигает этого путем разделения параметров модели на блоки на основе гессианской структуры трансформаторов. Каждому блоку назначается один качественный коэффициент обучения, что значительно сокращает количество коэффициентов обучения. Этот подход позволяет Adam-mini поддерживать или даже улучшать производительность при существенно меньшем объеме памяти, необходимом по сравнению с Adam.

Практические результаты

Adam-mini показал эффективность на различных языковых моделях от 125 миллионов до 7 миллиардов параметров, включая предварительное обучение, надзорное дообучение и обучение с подкреплением от обратной связи человека. Оптимизатор продемонстрировал сопоставимую или более высокую производительность по сравнению с AdamW, с заметными улучшениями в эффективности памяти и скорости обучения.

Поддержка и контакты

Если вам нужны советы по внедрению ИИ, пишите нам на https://t.me/itinai. Следите за новостями о ИИ в нашем Телеграм-канале t.me/itinainews или в Twitter @itinairu45358.

Попробуйте AI Sales Bot https://itinai.ru/aisales. Этот AI ассистент в продажах помогает отвечать на вопросы клиентов, генерировать контент для отдела продаж и снижать нагрузку на первую линию.

Узнайте, как ИИ может изменить ваши процессы с решениями от AI Lab itinai.ru. Будущее уже здесь!

«`