«`html

Введение в модели языка с омни-модальностью (OLMs)

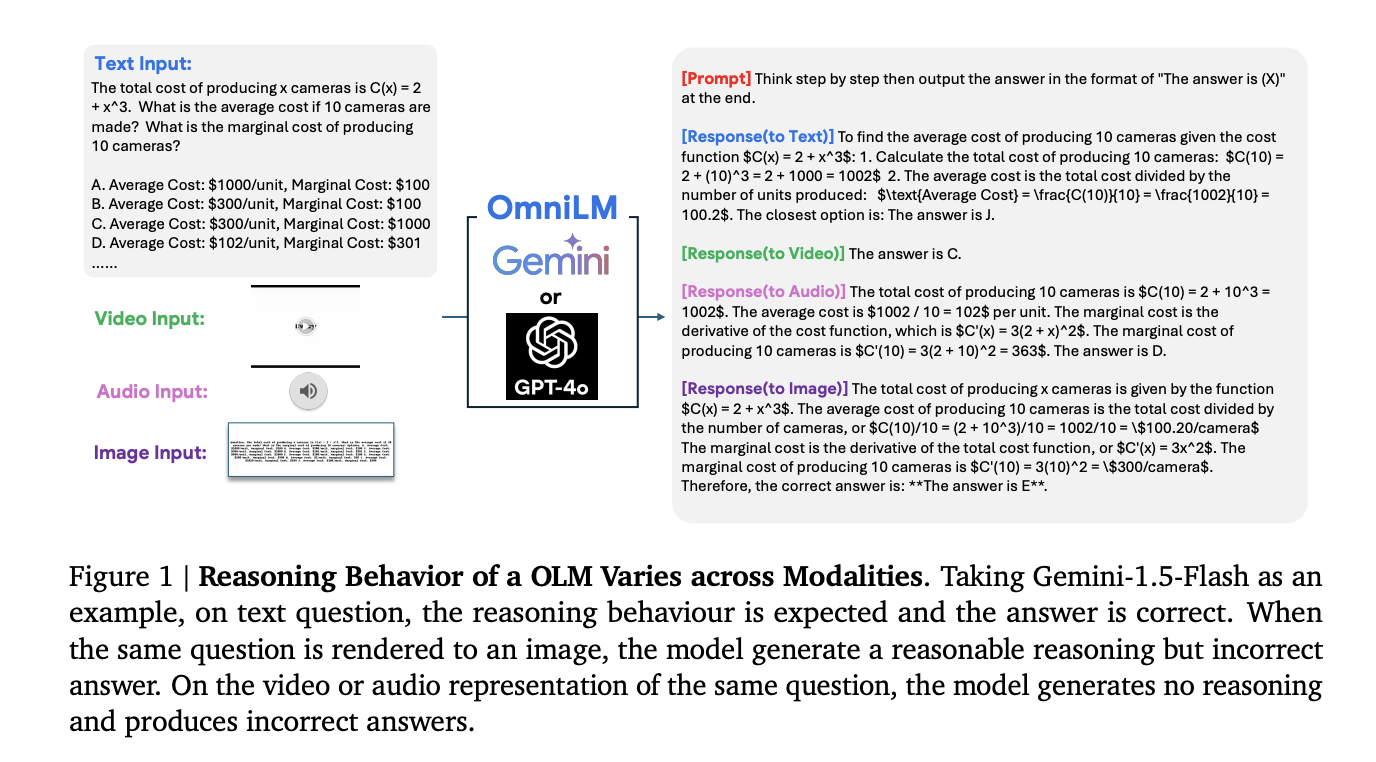

Модели языка с омни-модальностью (OLMs) — это быстро развивающаяся область ИИ, которая позволяет понимать и рассуждать на основе различных типов данных, таких как текст, аудио, видео и изображения. Эти модели помогают имитировать человеческое восприятие, обрабатывая разные входные данные одновременно, что делает их полезными в сложных задачах из реального мира.

Проблемы с производительностью

Основная сложность в разработке OLMs заключается в их непостоянной работе с многомодальными данными. Например, модель может столкнуться с задачей, где требуется анализировать текст, изображения и аудио, но многие текущие модели не справляются с этой задачей. Часто они дают разные ответы на одну и ту же информацию в разных форматах, что затрудняет их использование.

Ограничения текущих тестов

Существующие методы оценки OLMs часто ограничиваются простыми комбинациями двух модальностей, таких как текст и изображения. Однако реальный мир требует более сложных оценок, включая комбинации трех или более модальностей.

Новая оценочная система Omni×R

Исследователи из Google DeepMind и других организаций разработали новую оценочную систему — Omni×R, которая предназначена для проверки рассуждающих способностей OLMs. Эта система включает два типа наборов данных:

- Omni×Rsynth: синтетический набор данных, созданный путём автоматического преобразования текста в другие модальности.

- Omni×Rreal: реальный набор данных, тщательно отобранный из источников, таких как YouTube.

Преимущества новых наборов данных

Эти наборы данных создают более полную и сложную тестовую среду, чем предыдущие методы оценки, что позволяет точнее выявлять способности моделей.

Ключевые результаты

Тестирование моделей, таких как Gemini 1.5 Pro и GPT-4o, показало, что текущие модели испытывают значительные трудности при интеграции информации из разных модальностей. Например:

- Gemini 1.5 Pro: 77.5% точности с текстом, но только 57.3% с видео и 36.3% с изображениями.

- GPT-4o: лучше справляется с текстом и изображениями, но испытывает затруднения с видео.

Основные выводы

Результаты экспериментов показывают, что:

- Модели хорошо работают с текстом, но испытывают сложности с многомодальным рассуждением.

- Существует значительный разрыв в производительности между текстовыми и сложными многомодальными задачами.

- Большие модели, как правило, показывают лучшие результаты, но иногда меньшие модели могут быть более эффективными в конкретных задачах.

Выводы и рекомендации

Рамки Omni×R обеспечивают важный шаг к оценке и улучшению рассуждающих способностей OLMs. Необходимы дальнейшие исследования для преодоления существующих ограничений, особенно в задачах, связанных с интеграцией видео и аудио.

Польза от ИИ для вашего бизнеса

Если вы хотите, чтобы ваша компания смогла воспользоваться преимуществами ИИ, обратите внимание на следующее:

- Проанализируйте, как ИИ может изменить вашу работу.

- Определите ключевые показатели эффективности, которые вы хотите улучшить с помощью ИИ.

- Внедряйте ИИ решения постепенно, начиная с небольших проектов и анализируя результаты.

Если вам нужны советы по внедрению ИИ, пишите нам в нашем Телеграм-канале или следите за новостями о ИИ.

Обратитесь к решениям от AI Lab, чтобы узнать, как ИИ может изменить ваши процессы. Будущее уже здесь!

«`