«`html

DeepSeek-Prover-V1.5: Новый уровень в формальном доказательстве теорем

Большие языковые модели (LLM) сделали значительные успехи в математическом рассуждении и доказательстве теорем, однако они сталкиваются с серьезными проблемами в формальном доказательстве теорем с использованием систем Lean и Isabelle. Эти системы требуют строгих выводов, соответствующих строгим формальным спецификациям, что создает трудности даже для продвинутых моделей, таких как GPT-4.

Решение DeepSeek-AI: DeepSeek-Prover-V1.5

DeepSeek-Prover-V1.5 представляет собой объединенный подход, который комбинирует преимущества техник генерации шагов доказательства и целого доказательства через мощный механизм обрезки и возобновления. Этот метод начинается с генерации целого доказательства, где языковая модель создает полный код доказательства на основе утверждения теоремы. Затем Lean-проверяющий проверяет этот код. Если обнаружена ошибка, код обрезается до первого сообщения об ошибке, и успешно сгенерированная часть служит подсказкой для следующего сегмента доказательства.

Вклад и результаты

Это исследование представляет следующие вклады:

- Улучшенная базовая модель с дополнительным обучением по математике и коду, с акцентом на формальных языках, таких как Lean, Isabelle и Metamath.

- Улучшенный набор данных для завершения кода Lean 4 через две техники аугментации данных.

- Применение алгоритма GRPO для обучения с подкреплением от обратной связи доказательного ассистента.

- Усовершенствованный метод поиска дерева Monte-Carlo с механизмом обрезки и возобновления и алгоритмом RMaxTS.

Результаты DeepSeek-Prover-V1.5

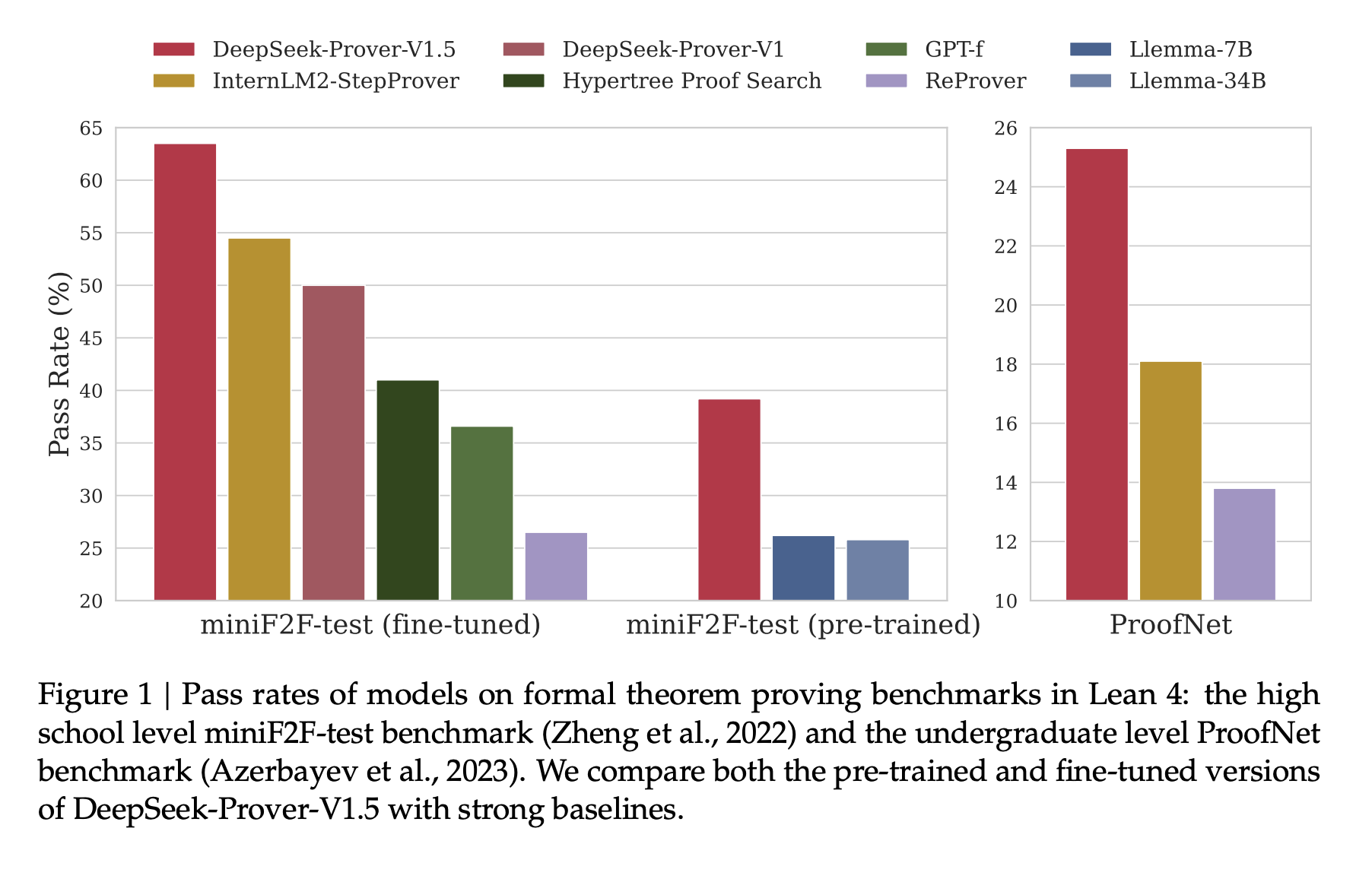

DeepSeek-Prover-V1.5 демонстрирует значительные преимущества в формальном доказательстве теорем на различных бенчмарках. На наборе данных miniF2F-test DeepSeek-Prover-V1.5-RL достиг 60,2% успешных доказательств в однопроходной генерации целого доказательства, что на 10,2 процентных пункта превышает предыдущий результат. Также он превзошел предыдущий лучший результат с значительно меньшим количеством попыток. На наборе данных ProofNet DeepSeek-Prover-V1.5-RL достиг процентов успешных доказательств 22,6% и 25,3% в однопроходной и RMaxTS-усовершенствованных настройках соответственно, превзойдя существующие методы.

Перспективы

DeepSeek-Prover-V1.5, 7-миллиардная языковая модель, устанавливает новые стандарты в формальном доказательстве теорем с использованием Lean 4. Эта рамка устанавливает пайплайн, аналогичный AlphaZero, для формального доказательства теорем, используя итерацию экспертов и синтетические данные.

Подробнее ознакомьтесь с статьей и GitHub.

Все заслуги за это исследование принадлежат исследователям этого проекта. Также не забудьте подписаться на наш Twitter и присоединиться к нашей Telegram-группе и LinkedIn-группе. Если вам нравится наша работа, вам понравится наш рассылка.

Не забудьте присоединиться к нашему сообществу Reddit.

Найдите предстоящие вебинары по ИИ здесь.