«`html

Jina AI выпустила Reader-LM-0.5B и Reader-LM-1.5B: Революционные модели для преобразования HTML в Markdown с мультиязычностью и долгим контекстом

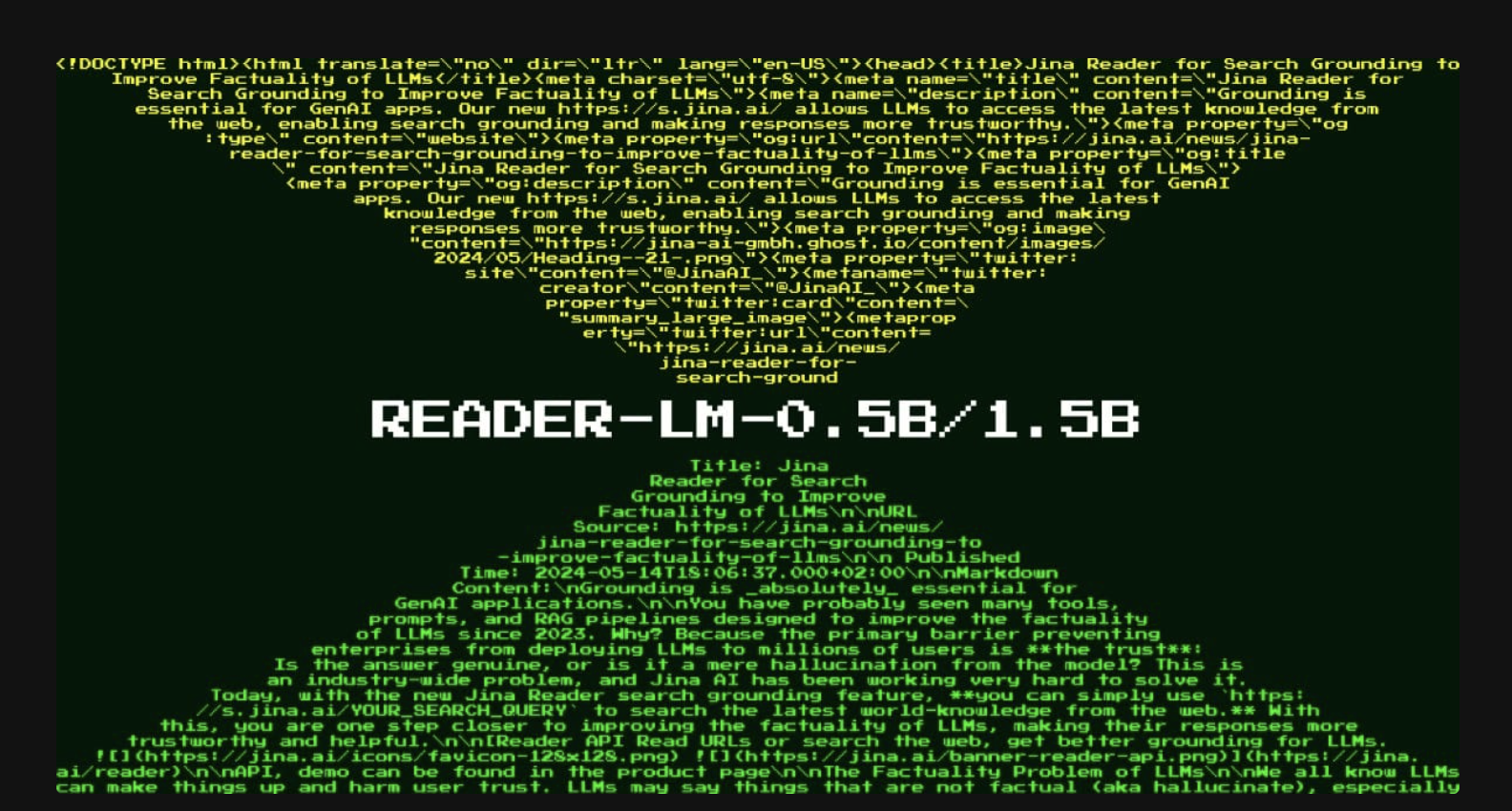

Выпуск Reader-LM-0.5B и Reader-LM-1.5B от Jina AI является значительным событием в технологии малых языковых моделей (SLM). Эти модели разработаны для решения уникальной и конкретной задачи: преобразование сырого, шумного HTML с открытого веб-сайта в чистый формат markdown. Хотя эта задача кажется простой, она представляет сложные вызовы, особенно в обработке обширного шума в современном веб-контенте, такого как заголовки, подвалы и боковые панели. Серия моделей Reader-LM нацелена на эффективное решение этой задачи, с акцентом на экономичность и производительность.

Фон и Цель

В апреле 2024 года Jina AI представила Jina Reader, API, которое преобразует любой URL в markdown, подходящий для крупных языковых моделей (LLM). Это API использует инструменты, такие как пакет Readability от Mozilla, для извлечения основного контента с веб-страницы, а затем регулярные выражения и библиотеку Turndown для преобразования очищенного HTML в markdown. Однако этот метод столкнулся с проблемами, такими как неправильная фильтрация контента и трудности в преобразовании сложных структур HTML. Получив обратную связь от пользователей, Jina AI поняла, что патчинг существующего конвейера с помощью дополнительных регулярных выражений и эвристик не является устойчивым решением.

Чтобы преодолеть эти ограничения, Jina AI поставила важный вопрос: можно ли эту проблему решить end-to-end с использованием языковой модели? Вместо ручно созданных правил языковая модель могла бы более эффективно обрабатывать задачу преобразования HTML в markdown, особенно с менее чем миллиардом параметров, что делает ее выполнимой для запуска на краю.

Введение моделей Reader-LM

Jina AI выпустила две малые языковые модели: Reader-LM-0.5B и Reader-LM-1.5B. Эти модели обучены специально для преобразования сырого HTML в markdown, и обе поддерживают мультиязычность с возможностью обработки до 256 тыс. токенов контекста. Эта способность обрабатывать большие контексты критически важна, поскольку содержимое HTML современных веб-сайтов часто содержит больше шума, чем когда-либо прежде, с встроенным CSS, JavaScript и другими элементами, значительно увеличивающими количество токенов.

В то время как крупные языковые модели известны своими высокими вычислительными требованиями, малые языковые модели, такие как Reader-LM, разработаны для обеспечения эффективной производительности без дорогостоящей инфраструктуры. Reader-LM-0.5B и Reader-LM-1.5B превосходят многие более крупные модели в конкретной задаче преобразования HTML в markdown, при этом имея лишь долю их размера.

Архитектура и Спецификации

Модели Reader-LM разработаны для обработки входов с длинным контекстом и выполнения выборочного копирования из HTML в markdown. Эта задача проще, чем типичные функции LLM, такие как генерация текста или написание кода. Это поведение выборочного копирования фокусируется в первую очередь на идентификации соответствующего контента, пропуская ненужные элементы, такие как боковые панели и заголовки, и форматируя оставшийся контент в синтаксисе markdown.

Спецификации моделей

Reader-LM-0.5B: С 494 миллионами параметров, эта модель имеет 24 слоя, 896 скрытых размеров и 14 запросов. Она компактна, но способна эффективно обрабатывать задачу выборочного копирования.

Reader-LM-1.5B: Эта более крупная модель имеет 1,54 миллиарда параметров, 28 слоев, 1536 скрытых размеров и 12 запросов. Она работает лучше, чем более маленькая модель, особенно при работе с более сложными структурами HTML.

Обе модели поддерживают длину контекста до 256 тыс. токенов, что критически важно для обработки часто длинного и шумного HTML-контента, найденного в Интернете. Их способность обрабатывать мультиязычный контент делает их универсальными инструментами для глобальных приложений.

Производительность и Бенчмаркинг

Производительность Reader-LM-0.5B и Reader-LM-1.5B была тщательно оценена по сравнению с несколькими крупными языковыми моделями, включая GPT-4o, Gemini-1.5-Flash, LLaMA-3.1-70B и Qwen2-7BInstruct. Модели были протестированы с использованием метрик, таких как ROUGE-L (для задач суммаризации и ответов на вопросы), Token Error Rate (TER, который измеряет уровень галлюцинаций контента) и Word Error Rate (WER, который оценивает несоответствия между сгенерированным markdown и оригинальным HTML).

В этих оценках модели Reader-LM превзошли многие более крупные модели в терминах генерации чистого, точного markdown из HTML. Например, Reader-LM-1.5B достигла ROUGE-L оценки 0,72, WER 1,87 и TER 0,19, значительно лучше, чем GPT-4o и другие протестированные модели. Reader-LM-0.5B, хотя и меньше, также продемонстрировала конкурентоспособные результаты, особенно в задаче сохранения структуры, что важно для преобразования HTML в markdown.

Обучение и Разработка

Для обучения моделей Reader-LM требовалось подготовить высококачественные пары данных с сырым HTML и соответствующим markdown. Jina AI сгенерировала эти данные, используя свое существующее API Jina Reader, дополненное синтетическим HTML, сгенерированным GPT-4o для обучения. Итоговый набор данных для обучения содержал примерно 2,5 миллиарда токенов.

Модели обучались в два этапа:

Короткий и простой HTML: На этом этапе использовались до 32 тыс. токенов и 1,5 миллиарда обучающих токенов.

Длинный и сложный HTML: На этом этапе последовательности увеличились до 128 тыс. токенов с 1,2 миллиарда обучающих токенов. Ключевым новшеством на этом этапе было использование механизма «zigzag-ring-attention», что улучшило обработку длинного контекста.

Несмотря на сложность преобразования HTML в markdown, модели были оптимизированы для эффективной обработки этой задачи без излишней вычислительной нагрузки. Они используют техники, такие как контрастный поиск, чтобы предотвратить дегенерацию токенов и повторяющиеся циклы во время генерации markdown.

Прикладные Применения в Реальном Мире

Reader-LM разработан для практического использования как в индивидуальных, так и корпоративных средах. Модели могут быть легко протестированы с помощью Google Colab, а производственные среды могут использовать платформы, такие как Azure и AWS, где модели скоро будут доступны. Reader-LM лицензирован под CC BY-NC 4.0, с возможностью коммерческого использования для компаний, ищущих решения для своих предприятий.

Модели идеально подходят для автоматизации извлечения и очистки данных с открытого веба в производственных средах. Преобразуя сырой HTML в чистый markdown, Reader-LM обеспечивает эффективную обработку данных, упрощая последующую суммаризацию, анализ и получение информации из веб-контента с помощью LLM. Кроме того, их мультиязычные возможности расширяют их применимость в различных отраслях и регионах.

Заключение

Выпуск Reader-LM-0.5B и Reader-LM-1.5B представляет собой прорыв в технологии малых языковых моделей, специально разработанных для преобразования HTML в markdown. Эти модели решают критическую потребность в эффективном, экономичном извлечении данных из шумного и часто ошеломляющего веб-контента, который характеризует современный интернет. Благодаря своему компактному размеру, поддержке длинного контекста и мультиязычным возможностям, модели Reader-LM предлагают мощный инструмент для разработчиков и предприятий, стремящихся оптимизировать свои рабочие процессы.

Проверьте модели Reader-LM-0.5B, Reader-LM-1.5B и Colab Notebook. Вся заслуга за этот исследовательский проект принадлежит исследователям этого проекта. Также не забудьте подписаться на наш Twitter и присоединиться к нашей Telegram-группе и LinkedIn-группе. Если вам нравится наша работа, вам понравится наш newsletter.

Не забудьте присоединиться к нашему 50k+ ML SubReddit

FREE AI WEBINAR: ‘SAM 2 for Video: How to Fine-tune On Your Data’ (Wed, Sep 25, 4:00 AM – 4:45 AM EST)

The post Jina AI Released Reader-LM-0.5B and Reader-LM-1.5B: Revolutionizing HTML-to-Markdown Conversion with Multilingual, Long-Context, and Highly Efficient Small Language Models for Web Data Processing appeared first on MarkTechPost.

«`